Nel frenetico mondo dell’Intelligenza Artificiale, l’efficacia e l’affidabilità dei Modelli Linguistici di Grande Dimensione (LLM) sono generalmente attribuite alla vastità dei loro set di training e alla sofisticatezza delle loro architetture. Tuttavia, un nuovo studio congiunto condotto dagli specialisti di analisi big data S2W e dal Korea Advanced Institute of Science and Technology (KAIST) ha identificato una vulnerabilità fondamentale che risiede in una fase spesso sottovalutata del processo di elaborazione linguistica: la tokenizzazione. Questo lavoro, accettato per l’autorevole conferenza EMNLP 2025 (una delle tre principali conferenze internazionali sull’Elaborazione del Linguaggio Naturale), solleva preoccupazioni significative, in particolare per l’affidabilità dei modelli nelle lingue diverse dall’inglese.

Il Tokenizer è lo strumento essenziale che agisce come la prima linea di elaborazione di un LLM. Il suo compito è segmentare il testo in ingresso (frasi, parole, caratteri) in unità discrete chiamate token, che sono l’unica forma che il modello può elaborare matematicamente. Il recente studio, intitolato “Anomalous Bigrams Exposing Vulnerabilities of Incomplete Tokens in Byte-Level Tokenizers”, sostiene che questo processo, quando non è ottimale, può indurre allucinazioni nel modello, portando a risposte incoerenti o errate.

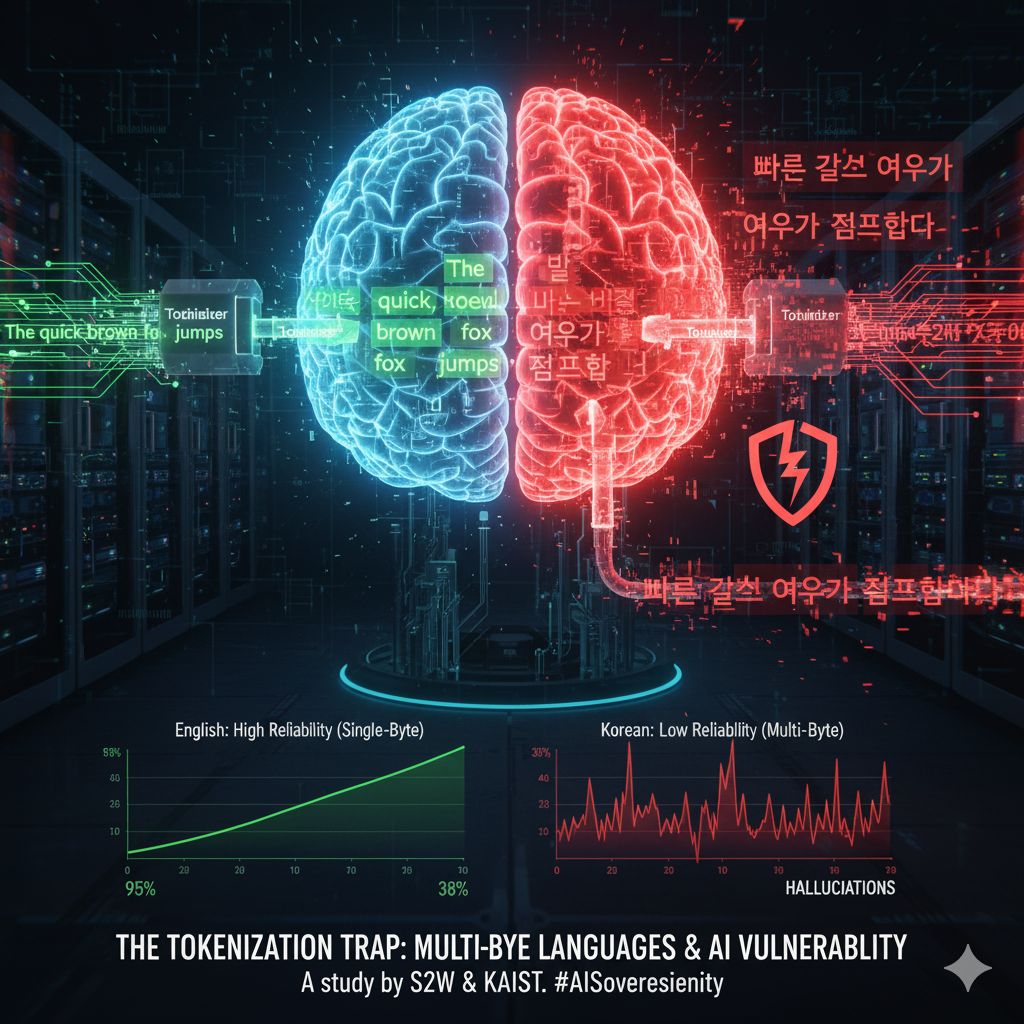

Il difetto strutturale si manifesta in modo lampante quando l’LLM viene utilizzato per analizzare lingue diverse dall’inglese. I ricercatori hanno osservato che il tokenizer, in questi casi, non riesce a separare completamente alcuni caratteri, lasciando dietro di sé dei “token incompleti” che il modello non è in grado di interpretare correttamente. Questa frammentazione ambigua della struttura linguistica rompe l’integrità semantica, impedendo il ripristino del significato o causando una distorsione contestuale che aumenta l’incidenza delle allucinazioni.

La radice del problema risiede in una differenza fondamentale nella codifica dei caratteri. L’inglese, nella sua forma standard, si basa storicamente su un byte per carattere, una struttura relativamente semplice. Al contrario, lingue come il coreano, il giapponese e il cinese rappresentano ogni carattere utilizzando più byte, una necessità per ospitare i loro alfabeti e ideogrammi più complessi.

Molti tokenizer attuali si basano sulla tecnica Byte-Pair Encoding (BPE), che lavora a livello di byte per scomporre il testo in token gestibili. Quando questa tecnica viene applicata alle lingue multi-byte, si verifica il fenomeno critico: il BPE tende a tagliare a metà i caratteri complessi in sequenze di byte incomplete, generando così i suddetti token anomali e ininterpretabili. Questa limitazione strutturale suggerisce in modo convincente che, a causa del design del tokenizer, la qualità della risposta e l’affidabilità generale dei modelli AI sono intrinsecamente inferiori nelle lingue diverse dall’inglese rispetto a quanto non lo siano nell’inglese stesso.

Le scoperte di S2W e KAIST hanno implicazioni che vanno ben oltre la mera ottimizzazione tecnica. Come sottolineato da Park Geun-tae, CTO di S2W e coautore del paper, lo studio fornisce un elemento cruciale nel dibattito sulla “Sovranità AI”. Questo concetto strategico postula che ogni nazione debba sviluppare e gestire l’Intelligenza Artificiale basandosi sulla propria lingua e sui propri dati nazionali.

Se il meccanismo di base di elaborazione linguistica, il tokenizer, non è in grado di gestire in modo affidabile le lingue nazionali (diverse dall’inglese), diventa estremamente difficile per i vari paesi costruire e gestire in modo sicuro e affidabile i propri modelli di intelligenza artificiale. L’incapacità di un tokenizer di rappresentare con precisione la lingua nativa introduce un punto di fallimento sistemico che erode la fiducia nell’AI e mina gli sforzi per creare ecosistemi di AI localizzati e culturalmente rilevanti.

Questa ricerca non è solo un contributo accademico; è un campanello d’allarme per l’industria che evidenzia come l’efficienza non debba mai prevalere sull’integrità linguistica. Il futuro di un’AI veramente globale e affidabile richiede una profonda revisione e un redesign dei tokenizer per onorare la complessità delle lingue multi-byte, garantendo che l’accuratezza e la coerenza non siano un privilegio riservato ai paesi di lingua inglese.