Una delle sfide più concrete e tecnicamente rilevanti nell’uso dei modelli linguistici di grandi dimensioni (LLM) nelle applicazioni reali è la compromissione delle capacità pregresse quando si tenta di specializzarli su nuove competenze o domini di conoscenza. Quando un’azienda addestra ulteriormente un modello per un compito specifico tramite fine-tuning tradizionale, l’aggiunta di nuove informazioni tende a “rompere” aspetti delle abilità generali che il modello aveva già acquisito nella fase di pre-addestramento. Questo fenomeno, ben noto nella comunità di apprendimento automatico come catastrophic forgetting (dimenticanza catastrofica), costringe spesso le organizzazioni a gestire veri e propri “zoos di modelli”, con varie versioni specialistiche che devono essere mantenute contemporaneamente per coprire tutte le esigenze tecniche interne.

Ricercatori del Massachusetts Institute of Technology (MIT), dell’Improbable AI Lab e dell’ETH Zurich hanno recentemente proposto un approccio innovativo, denominato Self-Distillation Fine-Tuning (SDFT), che mira a risolvere questo problema permettendo a un singolo modello di acquisire nuove competenze senza perdere le capacità acquisite in precedenza. Questa tecnica è descritta in dettaglio in un articolo pubblicato l’11 febbraio 2026 su VentureBeat e si colloca a metà strada tra i metodi di supervised fine-tuning (SFT) classico e le tecniche di apprendimento on-policy derivate dal reinforcement learning (RL).

Il punto di partenza di SDFT è un’osservazione fondamentale sulle modalità con cui i moderni LLM gestiscono l’apprendimento contestuale: modelli come quelli basati su architetture transformer sono capaci di eseguire compiti nuovi in base agli esempi forniti nel prompt senza modificare i propri parametri interni, un comportamento noto come in-context learning (apprendimento contestuale). In un tipico scenario di fine-tuning, il modello impara a imitare esempi esperti presenti in un dataset di addestramento fisso (off-policy learning), ma ciò non gli consente di correggere dinamicamente i propri errori o di generalizzare efficacemente a esempi non presenti nel training set. L’apprendimento on-policy, al contrario, insegna al modello a generare e valutare i propri output, correggendo quindi i propri processi di ragionamento proprio come in un ciclo di feedback. Tuttavia, per i modelli linguistici, l’implementazione diretta dell’on-policy learning tramite RL richiede normalmente la definizione di una funzione di ricompensa matematica, cosa che è semplice in compiti con risposte binarie o numeriche, ma estremamente complessa in scenari reali come la stesura di documenti giuridici o la sintesi di riunioni aziendali.

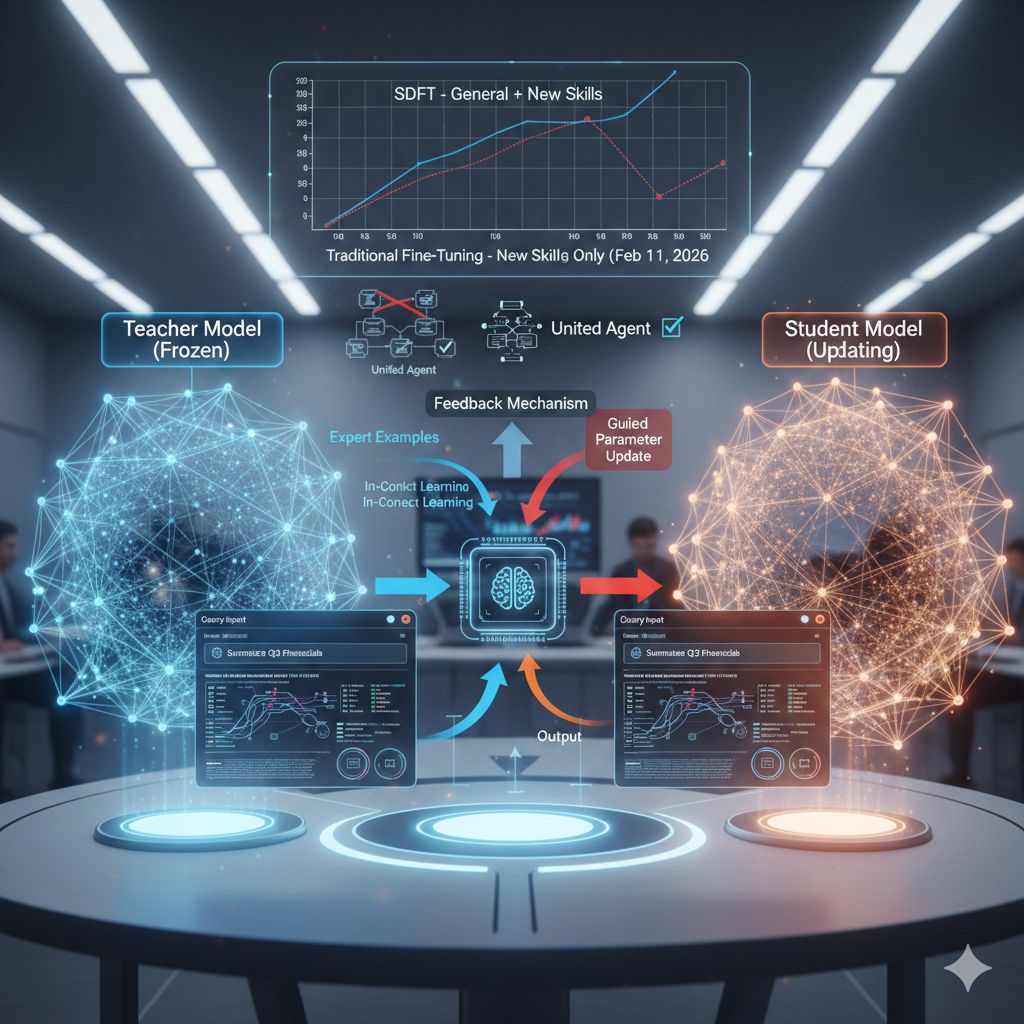

La tecnica SDFT supera questa limitazione combinando distillation — il processo in cui un “studente” impara a imitare un “insegnante” — con l’utilizzo intrinseco delle capacità di in-context learning del modello. In pratica, durante ogni ciclo di addestramento, il modello assume due ruoli distinti. In primo luogo, una copia congelata del modello agisce come teacher, ricevendo sia la richiesta (query) sia esempi di soluzioni corrette. Questa versione teacher utilizza gli esempi per dedurre sia la risposta corretta sia il ragionamento che la sostiene. In secondo luogo, una copia separata del modello funge da student, vedendo solo la query e generando una risposta “in bianco”, come succederebbe in un ambiente di produzione reale. A questo punto, il teacher confronta la propria soluzione (basata anche su esempi esperti) con quella prodotta dallo student e fornisce un feedback che guida lo student model ad aggiornare i propri parametri per avvicinarsi alla distribuzione del teacher. Questo ciclo simula i benefici dell’apprendimento on-policy pur utilizzando dati preregistrati, evitando la necessità di definire una funzione di ricompensa esterna come nei metodi di RL.

Un aspetto cruciale del metodo è che l’insegnamento non si basa unicamente su dataset statici di esempi, ma sul confronto diretto tra produzione del modello e interpretazione esperta della stessa situazione. In sostanza, il modello impara a correggere i propri errori di ragionamento e ad internalizzare nuove informazioni senza comprometterne altre già acquisite. Questo meccanismo differisce sostanzialmente dal supervised fine-tuning tradizionale, in cui il modello tende a focalizzarsi solo sui dati nuovi, perdendo performance su compiti precedenti. Nelle prove condotte dai ricercatori, il modello addestrato con SDFT ha mostrato un vantaggio significativo rispetto al fine-tuning standard su tre categorie di compiti enterprise-grade — domande scientifiche complesse, uso di strumenti software e ragionamento medico — e, soprattutto, ha preservato le proprie abilità generali mentre apprendeva le nuove.

Il vantaggio pratico di questa tecnica è evidente: le organizzazioni che adottano LLM per numerose applicazioni non dovrebbero più mantenere una molteplicità di modelli specializzati, ma potrebbero consolidare tutte le competenze in un singolo agente, capace di accumulare nuove conoscenze nel tempo. Questo abbattimento delle “isole di modello” ridurrebbe il costo di infrastrutture e inferenza, permettendo di gestire un’unica istanza efficace invece di molteplici versioni addestrate separatamente.

Va detto che l’approccio ha vincoli operativi: SDFT richiede modelli con capacità robuste di in-context learning, caratteristiche tipiche di architetture con un numero significativo di parametri, e comporta un aumento dell’impegno computazionale rispetto al fine-tuning tradizionale. L’operazione di generazione delle risposte (rollouts) per il confronto e l’aggiornamento dei pesi richiede una quantità di calcolo maggiore, stimata all’incirca 2,5 volte quella necessaria per il supervised fine-tuning. Inoltre, l’efficacia della tecnica su modelli di dimensioni più piccole è ancora in fase di valutazione, anche se si prevede che i miglioramenti nell’architettura e nell’addestramento consentiranno di ridurre rapidamente queste barriere.