L’intelligenza artificiale sta compiendo un passo fondamentale verso un modo di operare che ricorda sempre più da vicino il pensiero umano, non più limitandosi a fornire risposte immediate e lineari, ma imparando l’arte della riflessione e del confronto interno. Un recente filone di ricerca mette in luce come l’accuratezza dei modelli linguistici di grandi dimensioni possa migliorare in modo quasi prodigioso quando questi vengono programmati per simulare un vero e proprio dibattito tra diverse “personalità” o prospettive logiche prima di giungere a una conclusione definitiva. Questo approccio, che si discosta nettamente dai metodi tradizionali di elaborazione dei dati, suggerisce che la chiave per risolvere problemi complessi non risieda solo nella potenza di calcolo o nella vastità dei dati di addestramento, ma nella capacità del sistema di mettere in discussione le proprie premesse attraverso un dialogo critico automatizzato.

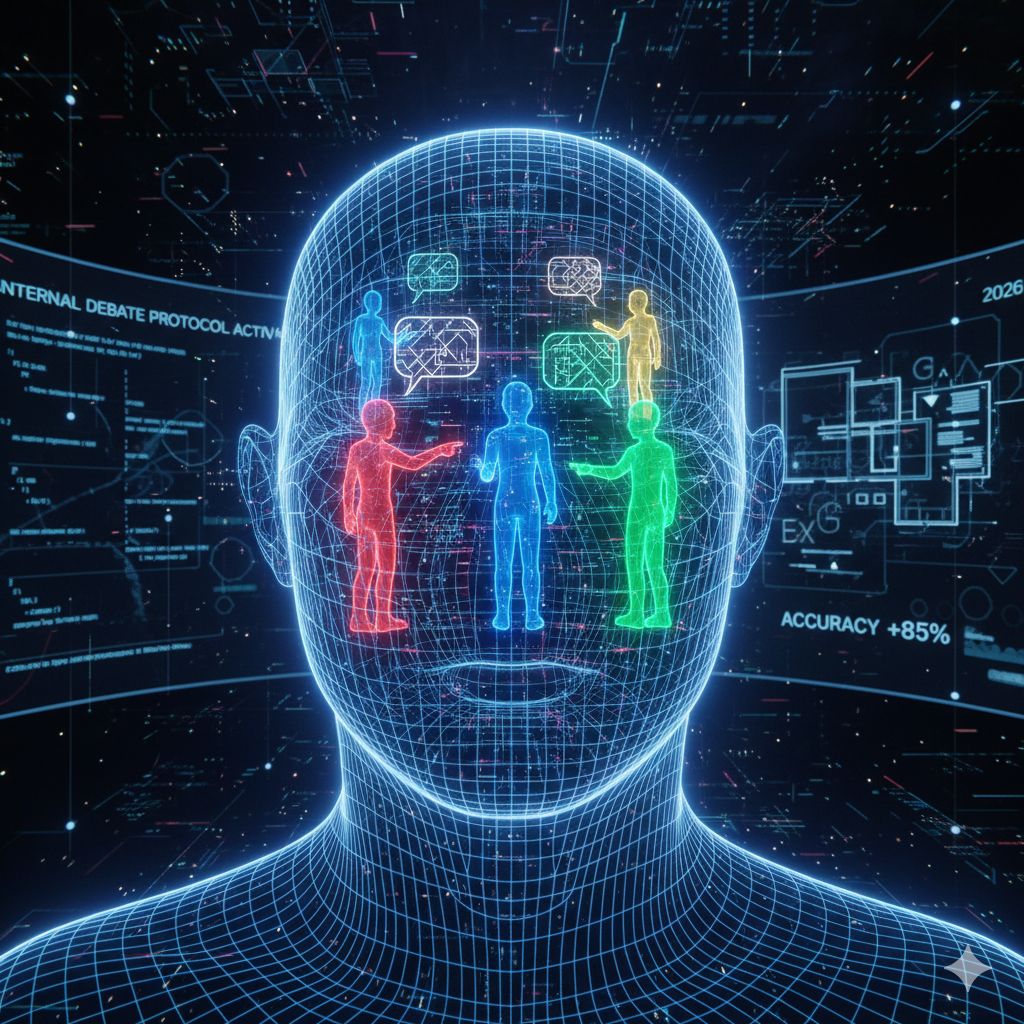

Il concetto alla base di questa innovazione è tanto semplice quanto potente: invece di generare un’unica stringa di testo basata su probabilità statistiche, il modello viene indotto a sdoppiarsi o moltiplicarsi, creando agenti virtuali con punti di vista divergenti che analizzano lo stesso problema da angolazioni opposte. Durante questa simulazione di dibattito interno, una parte del sistema può proporre una soluzione mentre l’altra ha il compito di rintracciarvi errori logici, allucinazioni o debolezze argomentative. Questo scambio continuo funge da filtro naturale che elimina le risposte superficiali o errate, costringendo l’intelligenza artificiale a raffinare il proprio ragionamento fino a quando non emerge una sintesi che resiste alle critiche più severe.

I risultati ottenuti attraverso l’implementazione di questi protocolli di dibattito sono sorprendenti e toccano ambiti che vanno dalla risoluzione di complessi enigmi matematici alla verifica dei fatti, fino alla scrittura di codice informatico privo di bug. In molti test, l’accuratezza del sistema è aumentata drasticamente rispetto ai metodi di interrogazione standard. Ciò accade perché il processo di confronto forza il modello a esplicitare i passaggi logici intermedi, rendendo il ragionamento trasparente e verificabile. È un cambiamento di paradigma che trasforma l’intelligenza artificiale da un semplice esecutore di compiti a un’entità capace di auto-correzione, riducendo drasticamente il fenomeno delle “allucinazioni”, ovvero quei momenti in cui la macchina inventa informazioni con estrema sicurezza.

Oltre ai benefici tecnici, questo sviluppo apre scenari affascinanti sulla natura stessa dell’intelligenza sintetica. Se un tempo si pensava che per ottenere risultati migliori servissero modelli sempre più grandi e pesanti, oggi la ricerca punta verso l’efficienza dei processi cognitivi simulati. Un modello di medie dimensioni che “riflette” e “discute” con se stesso può infatti superare le prestazioni di un modello gigantesco che risponde in modo istintivo. Questa metodologia introduce una sorta di coscienza procedurale che non ha nulla di mistico, ma che rappresenta un’evoluzione ingegneristica vo