Negli ultimi mesi si sta affermando un dibattito sempre più acceso attorno a un’idea tanto affascinante quanto controversa: l’ipotesi che l’intelligenza artificiale possa essere misurata attraverso un equivalente del quoziente intellettivo umano e che questo valore stia crescendo in modo lineare e costante. Secondo questa visione, il QI dell’IA non sarebbe solo una curiosità statistica, ma potrebbe diventare uno standard di riferimento per valutare le prestazioni dei modelli di nuova generazione, superando in parte i benchmark tradizionali oggi considerati insufficienti.

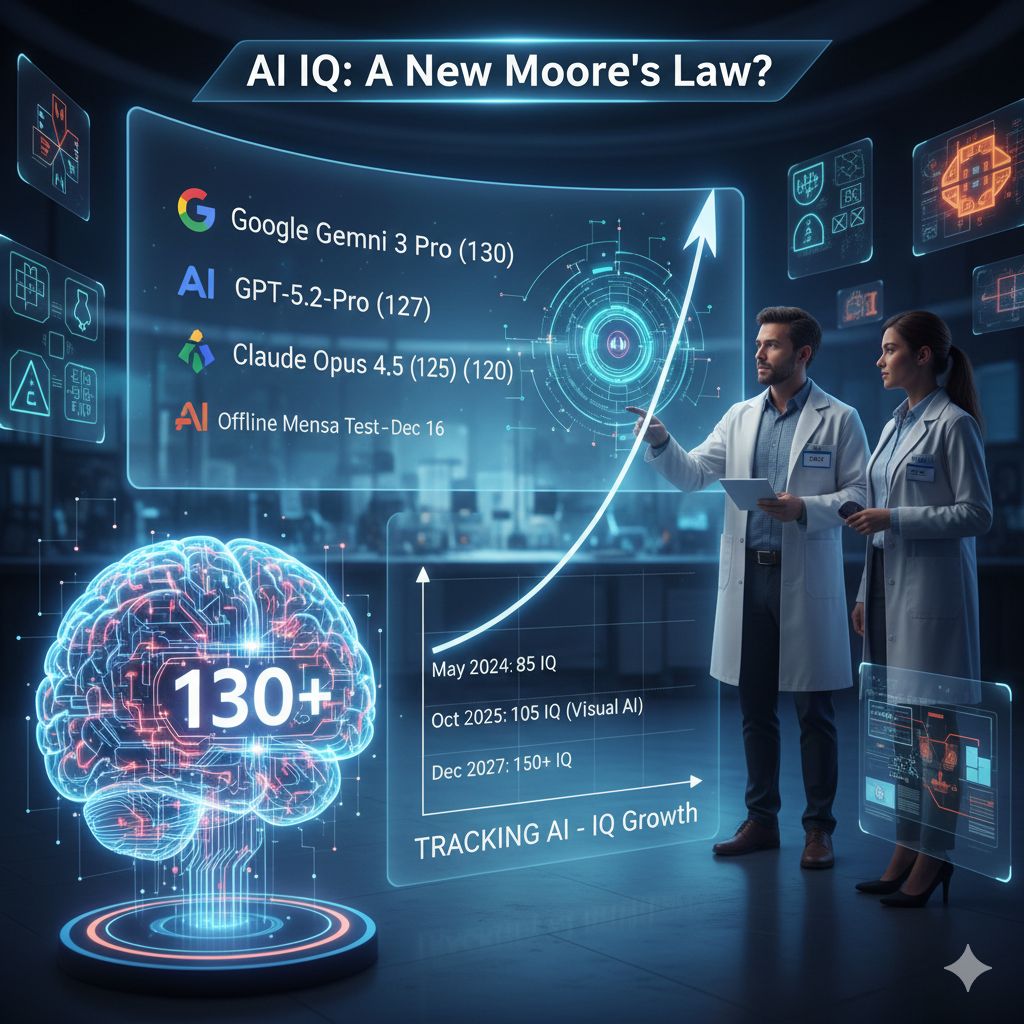

A sostenere questa tesi è Tracking AI, una piattaforma indipendente che si occupa di misurare le capacità cognitive dei principali modelli avanzati attraverso test ispirati a quelli del Mensa. In base ai dati aggiornati al 16 dicembre, il modello con il QI più elevato risulta essere Gemini 3 Pro di Google, che ha raggiunto un punteggio di 130 in un test definito “QI offline”. Questo test, sviluppato da membri del Mensa, non è mai stato pubblicato online né utilizzato come dato di addestramento per i modelli, proprio per ridurre il rischio di contaminazione e risposte apprese a memoria.

Alle spalle di Gemini 3 Pro si collocano GPT-5.2-Pro e GPT-5.2-Thinking, entrambi con un punteggio di 127, seguiti dalla modalità esperto di Grok-4 a quota 125 e da Claude Opus 4.5 con 120. Al di là della classifica in sé, ciò che colpisce maggiormente è il ritmo di crescita: secondo le misurazioni effettuate da Lott, produttore televisivo e blogger tecnologico che gestisce Tracking AI, i modelli di punta stanno migliorando di circa 2,5 punti di QI al mese in modo sorprendentemente regolare.

Questo andamento emerge chiaramente osservando l’evoluzione degli ultimi diciotto mesi. All’inizio del 2024, il QI massimo dell’IA si collocava intorno alla metà degli anni Ottanta; oggi si aggira intorno a 130. Lott ha descritto questa differenza come paragonabile al divario tra uno studente che abbandona la scuola superiore e una persona che consegue una laurea in matematica, un salto che rende evidente quanto rapidamente stiano cambiando le capacità cognitive delle macchine. Tra maggio 2024 e ottobre 2025, il miglioramento medio di 2,5 punti al mese appare quasi lineare, suggerendo un progresso incrementale ma costante, piuttosto che un’evoluzione fatta solo di balzi improvvisi.

L’analisi di questi dati ha portato anche a osservazioni meno intuitive. Un caso emblematico riguarda GPT-5, rilasciato da OpenAI lo scorso agosto. Secondo Lott, al di là dei miglioramenti nelle capacità visive, il modello avrebbe rappresentato in larga parte un rebranding di una versione precedente. Il suo QI offline, infatti, segnava un aumento di soli cinque punti rispetto al modello di punta precedente, o3, che aveva ottenuto un punteggio di 110. Ancora più interessante è il dato di settembre, quando GPT-5 è stato misurato a 106, probabilmente a causa di risorse computazionali ridotte nelle prime fasi successive al lancio. Questo calo temporaneo ha portato alcuni osservatori a credere, erroneamente, che il progresso dell’IA stesse rallentando o addirittura stagnando.

Parallelamente ai test offline, Tracking AI propone anche il test del QI online del Mensa, che tende a produrre risultati sensibilmente più alti, spesso di almeno dieci punti. In questo contesto emergono discrepanze significative. Ad esempio, GPT-5.2 Pro ha raggiunto un QI di 147, rispondendo correttamente a 34 domande su 35. Lott ha però invitato alla cautela nell’interpretare questi numeri, osservando che è possibile che i dati dei test Mensa online siano stati inclusi nei dataset di addestramento dei modelli, rendendo questi risultati meno affidabili come misura “pura” dell’intelligenza.

Un aspetto particolarmente rilevante dell’analisi riguarda l’intelligenza visiva, misurata separatamente per valutare le capacità multimodali dei modelli. In questo ambito, il miglioramento è stato ancora più impressionante. A febbraio 2024 il QI visivo dell’IA si attestava intorno a 60, un livello così basso da essere quasi indistinguibile dal caso. Entro ottobre 2025, lo stesso indicatore è salito a 105, un valore sostanzialmente allineato alla media umana. Nei primi stadi di sviluppo, le limitate capacità visive costringevano l’IA a tradurre quasi ogni problema in forma testuale; oggi, invece, i modelli riescono a interpretare e risolvere enigmi visivi con un’efficacia paragonabile a quella delle persone.

Questa dinamica aiuta a rileggere anche le critiche rivolte a GPT-5. Pur avendo mostrato un miglioramento modesto nel QI generale, il modello ha registrato un incremento di circa 15 punti nel QI visivo rispetto a o3. Secondo Lott, proprio la multimodalità rappresenta la chiave dei suoi progressi reali, un aspetto che spesso passa in secondo piano persino nelle analisi degli esperti, più concentrate sui punteggi complessivi che sulle competenze specifiche.

Per Lott, i test del QI non sono semplici numeri, ma indicatori che correlano in modo significativo con le capacità di risoluzione dei problemi nel mondo reale. Nella sua esperienza diretta, modelli con punteggi più alti tendono a comportarsi meglio anche in contesti pratici complessi. Da qui nasce l’idea che, al di là di possibili eccessi negli investimenti, i dati sul QI suggeriscano che ulteriori progressi siano non solo probabili, ma strutturalmente incorporati nella traiettoria attuale dell’IA. Se il trend dovesse continuare, l’intelligenza artificiale potrebbe superare i test di QI umano, soprattutto quelli basati su puzzle visivi, entro la fine del 2027.

Questa prospettiva, tuttavia, non viene interpretata come un imminente rimpiazzo dell’intelligenza umana, quanto piuttosto come un periodo di transizione che offre tempo per adattarsi. Secondo Lott, l’IA dovrà affrontare ancora molte difficoltà prima di poter competere con gli esseri umani in ruoli complessi e creativi, suggerendo un’evoluzione complementare più che sostitutiva.

Tracking AI aveva già attirato l’attenzione mediatica nel febbraio 2024, quando pubblicò i risultati del primo test di QI Mensa applicato all’IA. All’epoca, Claude 3 fu il primo modello a superare quota 100, mentre GPT-4 si fermò a 85, sedici punti più in basso. Con il tempo, e con l’inclusione dei test Mensa nei dataset di addestramento, l’attenzione si è spostata sempre di più sui metodi offline, ritenuti più affidabili.

In questo contesto si inserisce anche il dibattito sul futuro dei benchmark. Alcuni ricercatori sostengono che i test di QI possano diventare un nuovo standard, capace di superare i limiti delle metriche attuali. Su Forbes, il ricercatore senior del MIT John Warner ha definito il QI dell’IA come “la nuova Legge di Moore”, paragonando la crescita lineare dei punteggi all’osservazione di Gordon Moore sul raddoppio dei transistor nei circuiti integrati. Secondo Warner, il settore ha un bisogno urgente di nuove metriche e nuovi modi di misurare un mondo in cui l’IA riesce a fare sempre di più con risorse relativamente contenute.

Allo stesso tempo, casi come quello di Gemini 3 mostrano che la cosiddetta legge di scala sta evolvendo. Le prestazioni non migliorano più soltanto aumentando in modo massiccio i parametri o la potenza di calcolo, ma attraverso progressi qualitativi più efficienti. I dati sul QI raccolti da Lott sembrano offrire una conferma quantitativa di questo cambiamento, suggerendo che il futuro dell’intelligenza artificiale potrebbe essere segnato meno da esplosioni improvvise e più da una crescita continua, misurabile e, per la prima volta, sorprendentemente lineare.