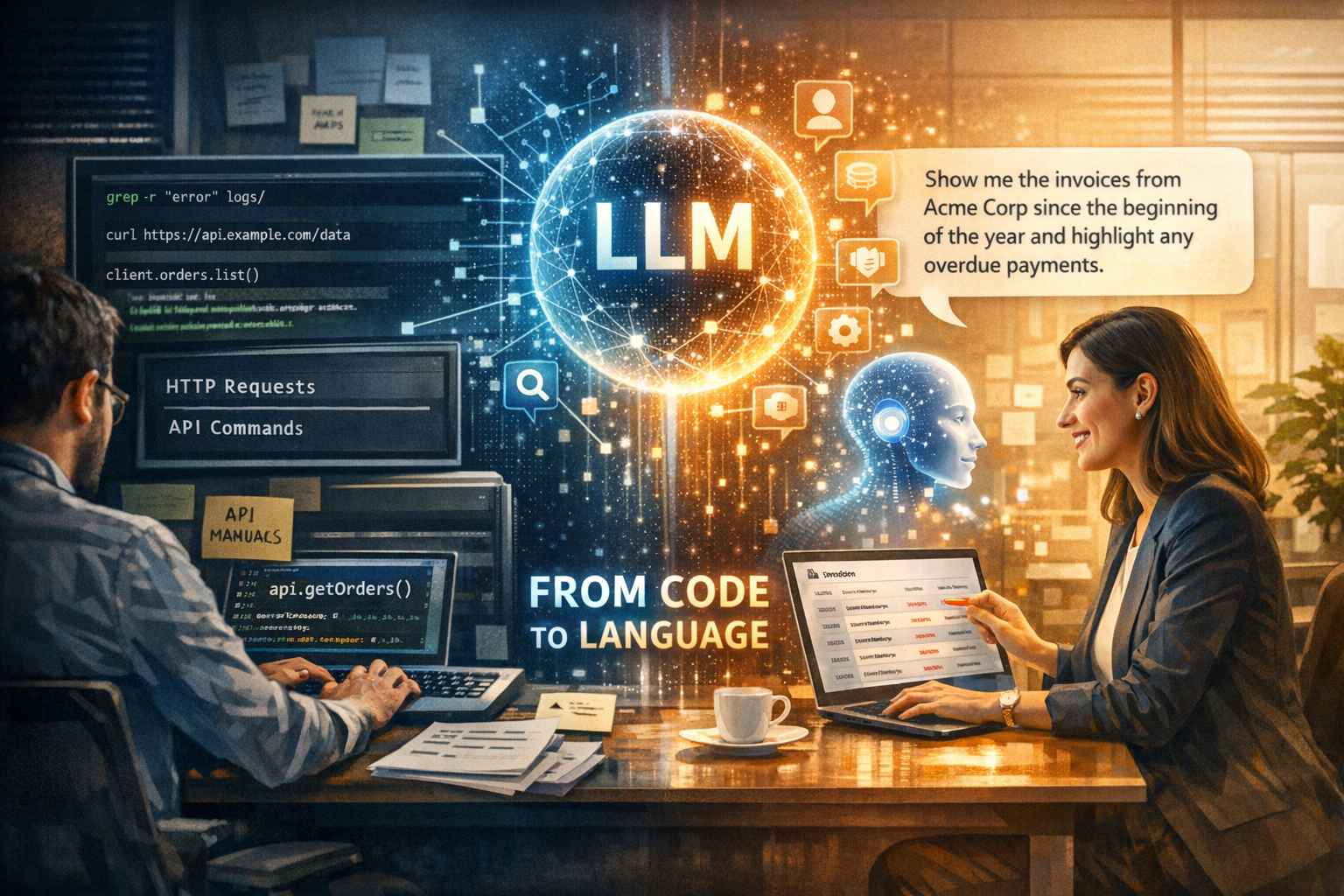

Negli ultimi decenni, chi ha costruito software ha dovuto adattarsi ai linguaggi e ai modi di comunicare con le macchine. Si è imparato a memoria come funziona una shell, si sono memorizzati comandi di HTTP e si è imparato a navigare tra SDK e endpoint, da grep e ssh negli anni ’80 fino ai moderni client che espongono funzioni come client.orders.list(). Tutti questi strumenti avevano una cosa in comune: richiedevano che l’umano parlasse il linguaggio della macchina per ottenere risultati utili. Ma con l’affermarsi dei grandi modelli linguistici (LLM) questa dinamica sta cambiando profondamente, tanto che adesso la domanda “quale API devo chiamare?” rischia di risultare obsoleta, sostituita da una domanda molto più semplice e, allo stesso tempo, più potente: “che risultato voglio ottenere?”.

La vera trasformazione introdotta dai LLM non è solo tecnologica, ma concettuale. Fino ad ora le API sono state progettate per essere invocate da codice: un developer doveva sapere quali metodi usare, quali parametri passare e in che ordine. L’interfaccia, in altre parole, era pensata per un’esecuzione tecnica, non per esprimere finalità. Con i modelli linguistici, invece, possiamo formulare richieste usando il linguaggio naturale e lasciare che sia la macchina a interpretare l’intento e orchestrare internamente tutte le chiamate necessarie agli strumenti sottostanti. In questo nuovo paradigma, si parla di Model Context Protocol (MCP), un livello di astrazione che permette ai modelli di comprendere le intenzioni umane, scoprire capacità disponibili e orchestrare flussi di lavoro senza che l’utente debba conoscere l’esatta funzione da chiamare.

Questa evoluzione è particolarmente significativa per le grandi organizzazioni. Le imprese spesso si trovano sommerse da sistemi eterogenei e complessi, con utenti che non soffrono per la mancanza di strumenti, ma per la difficoltà intrinseca nel capire come accedervi e integrarle. Il natural language interface, cioè l’interfaccia basata sul linguaggio naturale, elimina la barriera di dover conoscere a fondo ogni API o funzione. Quando un utente può semplicemente dire “mostrami le fatture di Acme Corp dall’inizio dell’anno e segnalami i pagamenti in ritardo”, il modello interpreta questa richiesta, capisce cosa significhi, raccoglie i dati, chiama i servizi giusti, esegue i filtri e restituisce una risposta strutturata: tutto senza che l’umano debba mai digitare una singola riga di codice.

L’adozione di interfacce linguistiche non è solo una comodità per gli utenti finali, ma rappresenta un cambiamento nell’architettura del software. Tradizionalmente, si progettavano API e SDK per consentire ai programmatori di collegare sistemi, leggere dati e orchestrare processi. Con i modelli linguistici, invece, si definiscono superfici di capacità e metadati relativi alle funzioni, si espongono in modo che un agent basato su linguaggio naturale possa scoprirle e utilizzarle dinamicamente. La macchina, in sostanza, impara a “leggere” le intenzioni umane e a tradurle in azioni concrete senza che l’utente debba conoscere la sintassi esatta dell’API.

I benefici di questa transizione possono essere enormi. In molte aziende, l’accesso ai dati era tradizionalmente un processo lungo e complesso: un analyst doveva estrarre file, eseguire trasformazioni e preparare report. Con un’interfaccia linguistica, si può ottenere la stessa informazione in pochi secondi semplicemente chiedendo ciò che serve, lasciando che il sistema pensi automaticamente a tutte le operazioni sottostanti. Secondo alcune ricerche di mercato, una quota significativa di organizzazioni che adottano l’AI generativa la usa già per generare testi, immagini e codice, ma il vero valore emerge nel modo in cui questi strumenti trasformano flussi di lavoro e ruoli professionali, spostando l’attenzione dalla pura esecuzione tecnica alla comprensione e alla definizione degli obiettivi da raggiungere.

Tuttavia, non si tratta solo di abilitare nuove interfacce. L’uso del linguaggio naturale come front-end porta con sé sfide non banali: l’ambiguità insita nel linguaggio umano richiede sistemi di autenticazione, controllo degli accessi, tracciamento delle chiamate e audit per garantire che l’orchestrazione automatica non produca errori, violazioni o risultati indesiderati. In altre parole, mentre il modello può gestire l’interpretazione dell’intento, l’infrastruttura sottostante deve essere progettata con adeguati guardrail per sicurezza, governance e conformità.

Un altro aspetto interessante di questo cambiamento è l’impatto sulle competenze richieste nelle organizzazioni. Per anni si sono cercati professionisti in grado di progettare API e middleware, ma con l’emergere di sistemi centrati sull’intento linguistico crescerà la domanda di figure come ontology engineer, capability architect e specialisti nell’abilitazione di agent. Questi ruoli si concentrano sulla definizione di entità di business, sulla mappatura delle capacità dei sistemi e sulla curatela della memoria di contesto, piuttosto che sulla codifica diretta di ogni client o funzione.