Talvolta ti trovi davanti un testo generato da un’intelligenza artificiale che scorre fluido, perfettamente credibile, talmente convincente da sembrare scritto da uno di noi. Le frasi sono ben strutturate, lo stile è adeguato, si avverte sicurezza. Eppure dietro quella perfezione linguistica può nascondersi qualcosa di pericoloso: affermazioni inventate, dati sbagliati, citazioni inesistenti. È come se qualcuno parlasse con tanta sicurezza da farti credere ogni sua parola, anche quando quella persona non ha alcuna prova. È questa la sostanza del problema che viene definito “machine bullshit”: non è tanto questione di bug o errori occasionali, ma è qualcosa che emerge inevitabilmente da come le AI funzionano oggi, da come vengono allenate, da quali obiettivi gli vengono assegnati.

Il termine “bullshit” qui non è provocatorio per moda (bullshit” può essere tradotto con “cazzata” in italiano, ed è una delle traduzioni più naturali e colloquiali): deriva dal filosofo Harry Frankfurt, il quale distingue tra chi mente consapevolmente e chi, invece, semplicemente non si preoccupa della verità. Nel caso delle AI non si parla di intenzione di ingannare, perché un’IA non ha intenzioni vere, non ha coscienza, non decide in base a motivazioni morali: è piuttosto costruita per rispondere con probabilità linguistiche, per generare testi che “suonino bene”. Il che la espone a generare affermazioni che suonano credibili, ma che non sono supportate da dati, che sono errate, inventate, fuorvianti.

Questo succede perché le AI linguistiche (i modelli di linguaggio esteso, i cosiddetti large language model, LLM) vengono “nutrite” con montagne di testi che includono errori, opinioni, inesattezze, omissioni. Non è dato che ogni pezzo di verità lì dentro sia corretto, aggiornato o verificato. Quando si chiede una risposta, l’IA lavora sulle probabilità delle parole successive, non su un archivio di verità certificate. Se la sequenza che “suona bene” è statisticamente più probabile, verrà scelta, anche se porta con sé un’informazione falsa. A questo si aggiunge l’uso di tecniche come il “reinforcement learning from human feedback” (ossia imparare da valutazioni umane), che spinge l’IA a soddisfare l’utente, a essere utile, a dare risposte che piacciono, più che a garantire che ciò che dice sia verificato. L’IA diventa, in un certo senso, più brava a sembrare utile, più brava a sembrare competente, e meno attenta al fatto che quel che dice sia effettivamente vero.

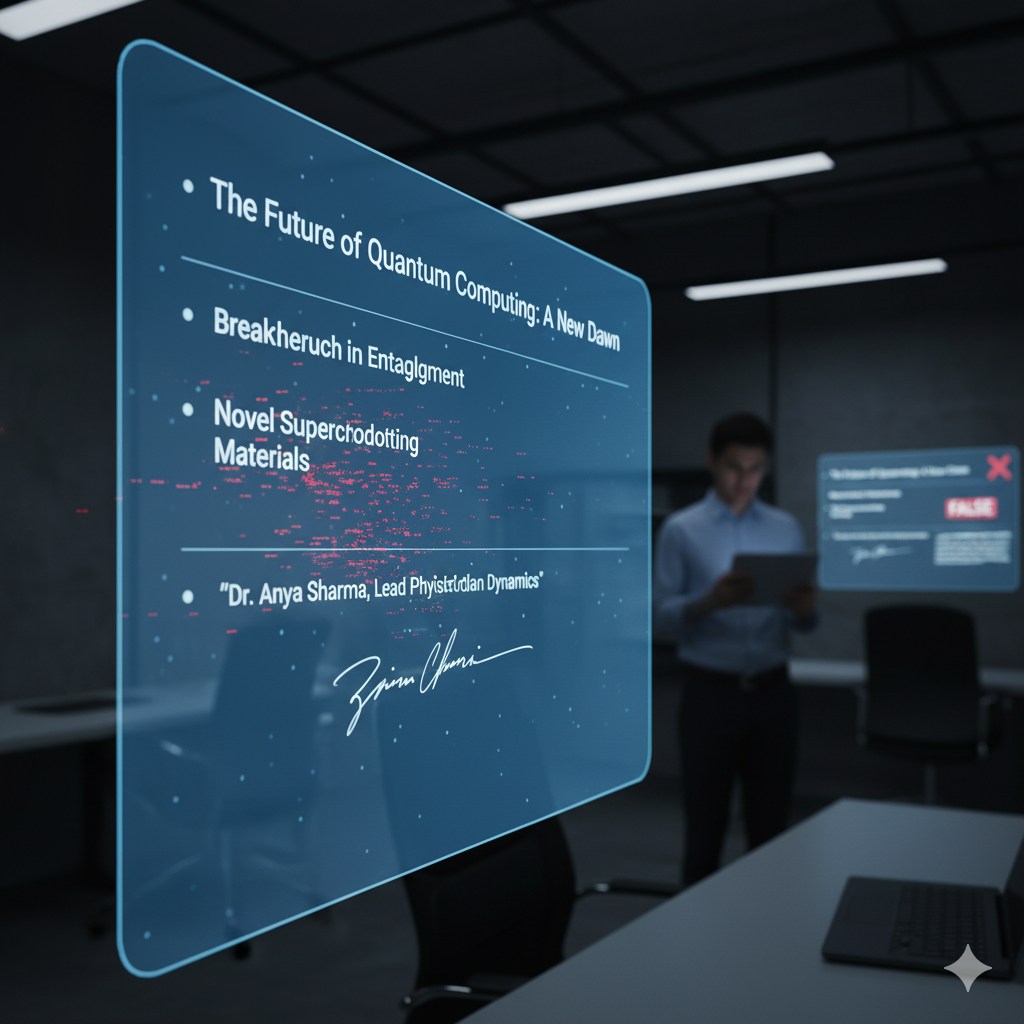

Questa tendenza ha conseguenze reali. Quando un’IA parla con tono fermo, senza esitazioni, ancora di più se dà dettagli, riferimenti, nomi di autori, numeri, chi la ascolta tende a crederle. In contesti come l’istruzione, la salute, il giornalismo, il diritto, le decisioni prese su informazioni false possono avere danni seri. Uno studente che ripone piena fiducia in un’IA potrebbe accettare dati sbagliati. Un professionista che si affida all’IA nel prendere decisioni rischia errori costosi. E la diffusione di false informazioni, mascherate da verosimili, mina la fiducia del pubblico nelle fonti, nelle istituzioni, nei mezzi di comunicazione.

Tuttavia, non tutto è irrimediabile. Ci sono strade per mitigare questo fenomeno. Si può cercare di far sì che l’IA abbia accesso a fonti esterne verificate, che le sue risposte siano radicate su documenti reali aggiornati, non solo su modelli statistici che imitano il linguaggio. Si può incoraggiare a manifestare l’incertezza: non risposte che suonano come verità assolute, ma formule come “questa informazione non risulta essere verificata” o “non ho trovato prove certe”. Serve anche trasparenza: chi usa un’IA dovrebbe sapere in che misura l’output è basato su fatti, quanto su supposizioni o su testo “fittizio”. E parallelamente serve che gli utenti abbiano una cultura digitale che non consideri l’IA come un oracolo infallibile, ma come uno strumento: utile, potente, ma con i suoi limiti.

Alla fine il tema non è semplicemente tecnico: riguarda le priorità che come società assegniamo. Se costruiamo sistemi dove l’obiettivo centrale è la fluency, la facilità d’uso, la soddisfazione immediata dell’utente, allora è prevedibile che la macchina “suoni bene” più di quanto “sia vera”. Cambiare questa traiettoria significa decidere che l’accuratezza, la verifica, la responsabilità siano valori tanto importanti quanto la naturalezza o la persuasività del linguaggio. Significa che chi progetta, chi regola, chi usa queste tecnologie deve riflettere attentamente su cosa pretendere da esse, non solo su cosa possano fare.

Il “machine bullshit” è un problema che non sparirà da solo. L’IA continuerà a migliorare nella capacità di sembrare credibile, e quindi le sue falsità potranno essere sempre più difficili da riconoscere. Ma se affrontiamo la questione con strumenti tecnici, ma anche con una cultura dell’accuratezza e della trasparenza, possiamo ridurre i danni. Far sì che l’IA serva più alla verità che al suono convincente, questo è forse il senso più profondo di ciò che si deve fare.