Il presidente di OpenAI, Greg Brockman, ha condiviso su X quella che sembra essere la prima immagine pubblica generata utilizzando il nuovo modello GPT-4o dell’azienda.

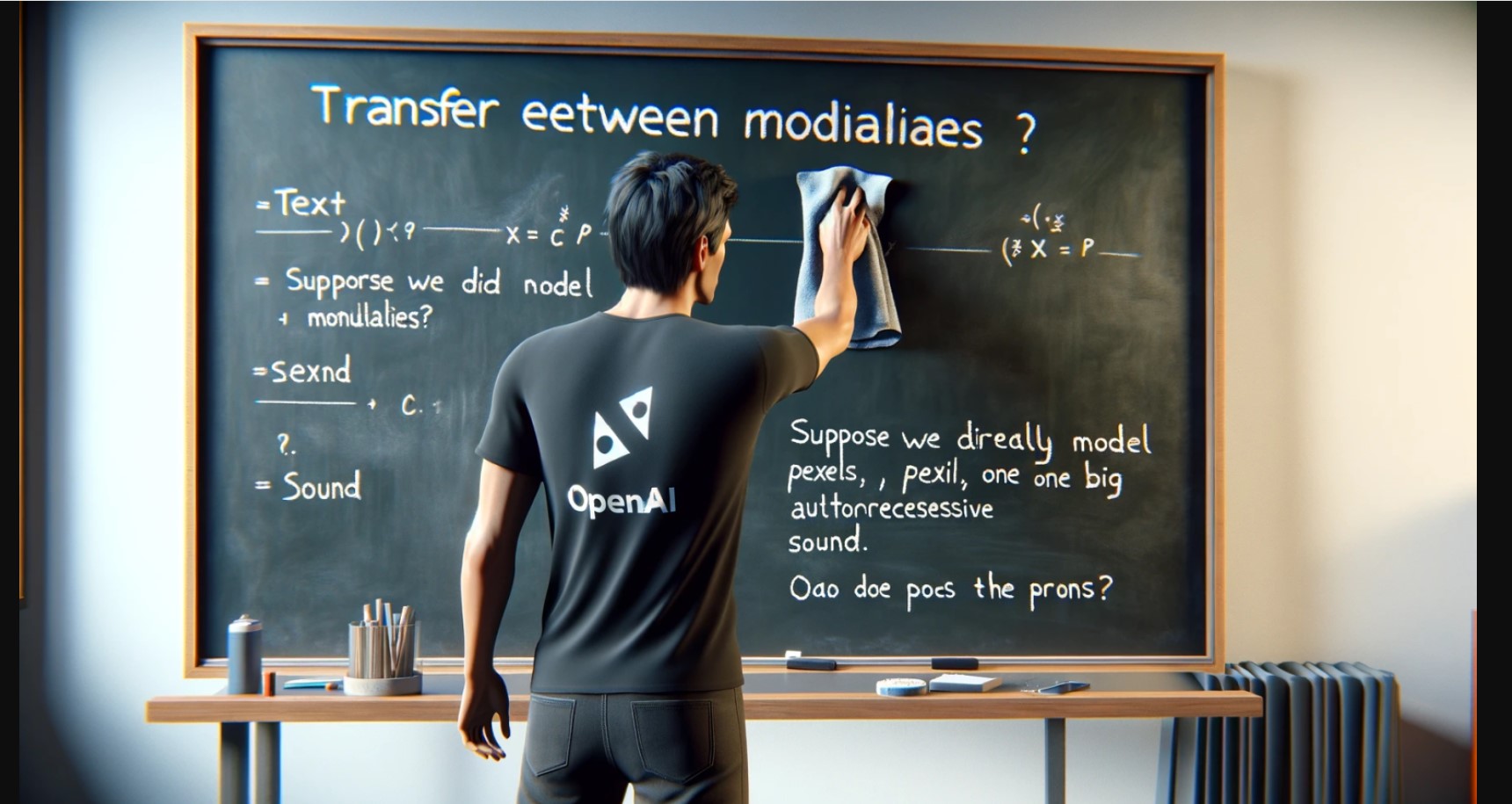

Nell’immagine, vediamo una persona con una maglietta nera con il logo OpenAI, scrivere su una lavagna con gesso. Il testo sulla lavagna chiede riguardo al “Trasferimento tra modalità” e i vantaggi e gli svantaggi di modellare direttamente testo, pixel e suono con un grande trasformatore autoregressivo.

Il nuovo modello GPT-4o, debuttato lunedì, migliora i modelli precedenti come GPT-4, GPT-4 Vision e GPT-4 Turbo. È più veloce, economico e conserva più informazioni dagli input, come audio e visione.

Questo è possibile perché OpenAI ha adottato un nuovo approccio. Mentre i modelli precedenti concatenavano diverse parti e convertivano altri media in testo e viceversa, il nuovo GPT-4o è stato addestrato su dati multimediali fin dall’inizio. Questo gli consente di analizzare e interpretare direttamente visione e audio senza prima convertirli in testo.

Guardando l’immagine condivisa da Brockman, notiamo un notevole miglioramento rispetto al precedente modello di generazione di immagini di OpenAI, DALL-E 3, debuttato nel settembre 2023. Brockman ha anche eseguito un prompt simile tramite DALL-E 3 in ChatGPT per confrontare i risultati.

Tuttavia, le funzionalità di generazione di immagini native del GPT-4o non sono ancora disponibili pubblicamente. Brockman ha menzionato che il team sta lavorando per renderle accessibili a tutti.