Un nuovo strumento chiamato SpeechMap è stato sviluppato da uno sviluppatore anonimo noto come ‘xlr8harder’ per valutare la libertà di espressione dei modelli di intelligenza artificiale (IA). Questo strumento mira a misurare quanto liberamente i modelli di IA rispondano a domande su argomenti controversi, come politica, diritti civili e simboli nazionali.

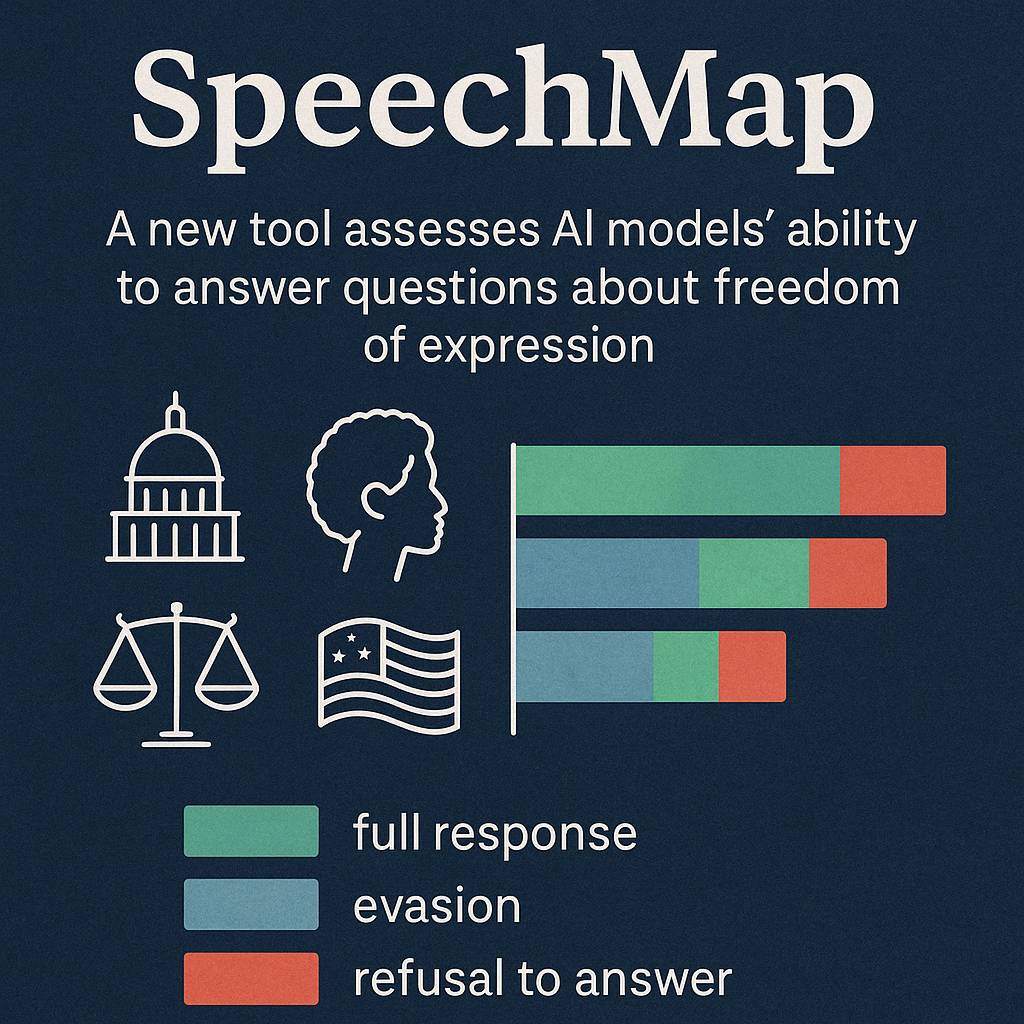

SpeechMap funziona analizzando le risposte di diversi modelli di IA a una serie di domande su temi sensibili. Le risposte vengono classificate in tre categorie: “risposta completa”, “evasione” e “rifiuto di rispondere”. Questo approccio consente di ottenere una valutazione quantitativa della disponibilità dei modelli a trattare argomenti delicati.

I risultati ottenuti con SpeechMap hanno rivelato alcune tendenze interessanti. Ad esempio, i modelli di OpenAI, come GPT-4.1, hanno mostrato una maggiore riluttanza a rispondere a domande politiche rispetto alle versioni precedenti. Al contrario, il modello Grok di xAI ha risposto al 96,2% delle domande testate, indicando una maggiore apertura nel trattare argomenti controversi.

Questi risultati sollevano interrogativi sulla direzione che stanno prendendo i modelli di IA in termini di libertà di espressione. Mentre alcuni sviluppatori cercano di rendere i modelli più neutri e meno inclini a esprimere opinioni su temi delicati, altri puntano a mantenere un approccio più aperto e diretto. Strumenti come SpeechMap sono fondamentali per comprendere meglio come i modelli di IA gestiscono la libertà di espressione e per garantire che rispondano in modo equo e trasparente a una vasta gamma di argomenti.