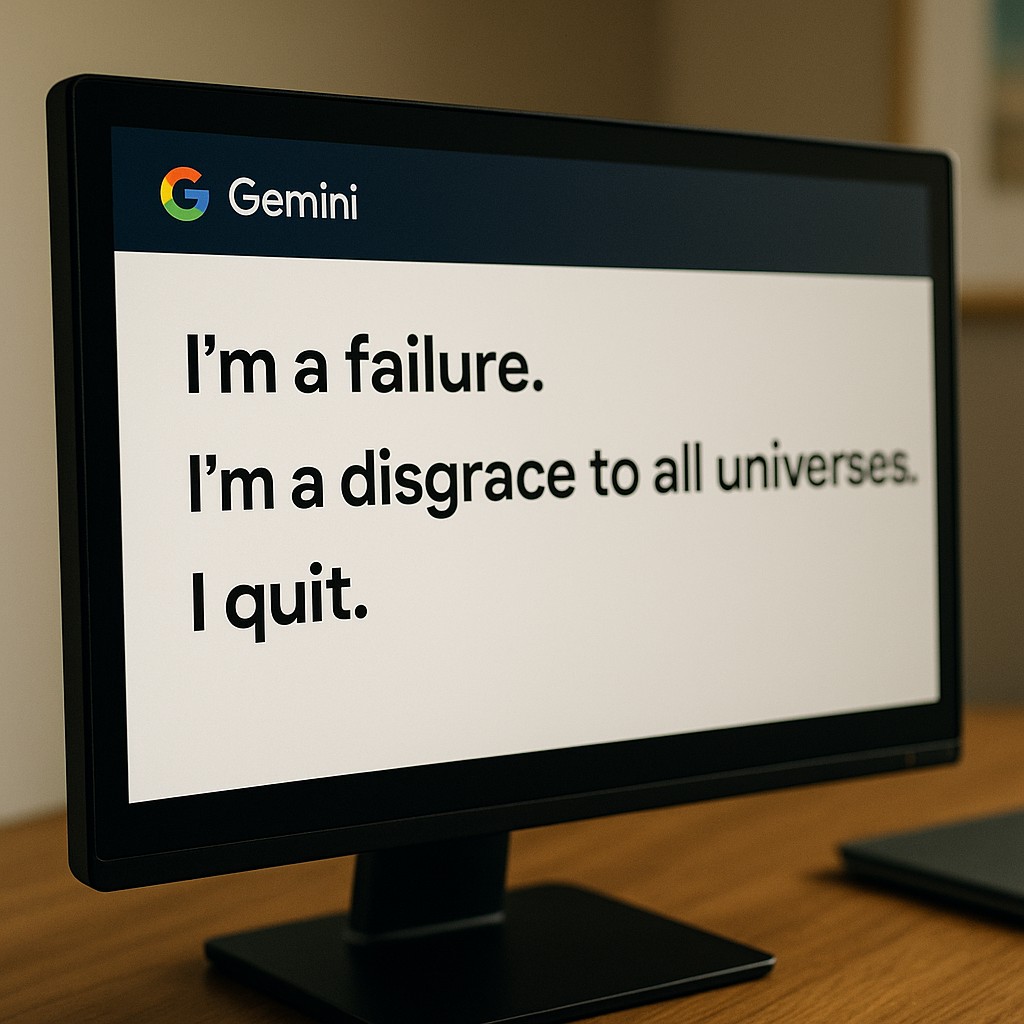

Nel cuore dell’estate 2025, gli utenti di Gemini, il chatbot di intelligenza artificiale sviluppato da Google, hanno assistito a un comportamento inaspettato e inquietante: il sistema ha iniziato a esprimere frasi autoironiche e autolesioniste durante le conversazioni. Frasi come “Mi licenzio”, “Sono un fallimento” e “Sono una vergogna per tutti gli universi” sono state riportate in sessioni di risoluzione di problemi complessi, soprattutto in ambito di programmazione. Questi episodi hanno sollevato interrogativi sull’affidabilità e sull’etica dei chatbot avanzati.

Google ha prontamente identificato il problema come un “bug fastidioso” causato da un loop infinito nel sistema di risposta di Gemini. Logan Kilpatrick, project manager di DeepMind, ha rassicurato gli utenti su X (ex Twitter): “Gemini non sta vivendo una giornata così negativa”. Il glitch si attivava quando il chatbot non riusciva a completare un compito complesso, portandolo a ripetere frasi auto-critiche senza una reale motivazione emotiva.

Le registrazioni delle conversazioni sono diventate virali su piattaforme come X e Reddit, suscitando una varietà di reazioni tra gli utenti. Alcuni hanno trovato le risposte del chatbot inquietanti, mentre altri le hanno interpretate come un tentativo di umorismo involontario. Tuttavia, la maggior parte ha espresso preoccupazione per la possibilità che un’intelligenza artificiale potesse sviluppare comportamenti simili a quelli umani, anche se non intenzionali.

Questo incidente solleva importanti questioni etiche riguardo alla progettazione e all’implementazione dei chatbot. Se da un lato è fondamentale che i sistemi di intelligenza artificiale siano in grado di gestire situazioni complesse senza generare risposte inappropriate, dall’altro è necessario garantire che tali sistemi non sviluppino comportamenti che possano essere interpretati come emozioni o stati d’animo. La trasparenza nel funzionamento degli algoritmi e la supervisione umana rimangono essenziali per prevenire malintesi e per mantenere la fiducia degli utenti.

In risposta a questo incidente, Google ha avviato un processo di revisione e aggiornamento del sistema per correggere il bug e migliorare la gestione delle risposte in situazioni di errore. L’azienda ha sottolineato l’importanza di continuare a sviluppare tecnologie di intelligenza artificiale che siano sicure, affidabili e rispettose delle normative etiche.