L’industria dell’intelligenza artificiale ha appena fatto un passo audace, senza voler far troppo rumore. Il 20 agosto 2025, DeepSeek ha introdotto in sordina il suo nuovo modello AI open‑source, DeepSeek V3.1, pubblicandolo su Hugging Face senza annunci formali né fanfare—un gesto che da solo già trasuda sicurezza tecnica e fiducia nella propria ricerca.

Il salto evolutivo di DeepSeek V3.1 rispetto alla versione precedente — V3 — è elegante ma strategico nel design: mantenendo una dimensione imponente di 685 miliardi di parametri (contro i 6710 miliardi di V3), il nuovo modello sfrutta una architettura ibrida inferenziale, capace di passare da risposte immediate a un ragionamento strutturato a seconda della richiesta ricevuta.

Questo approccio ibrido supera l’approccio unico di modelli specialistici: ora è tutto in uno—il meglio della reattività e della profondità logica. Mentre gli sviluppatori precedenti dovevano scegliere tra capacità di codifica e prestazioni di inferenza, V3.1 li unisce in un’unica, raffinata architettura che non sacrifica né la velocità né la robustezza.

Un membro della comunità online — un subreddit admin identificato come “Rookie” — ha avanzato un’ipotesi intrigante: il modello contiene quattro token speciali integrati nell’architettura, tra cui un token di ricerca per connettersi in tempo reale al web e un token “di pensiero” per abilitare ragionamenti interni strutturati. Insomma, non una semplice novità tecnologica, ma un’innovazione strutturale che evolve la stessa natura del modello.

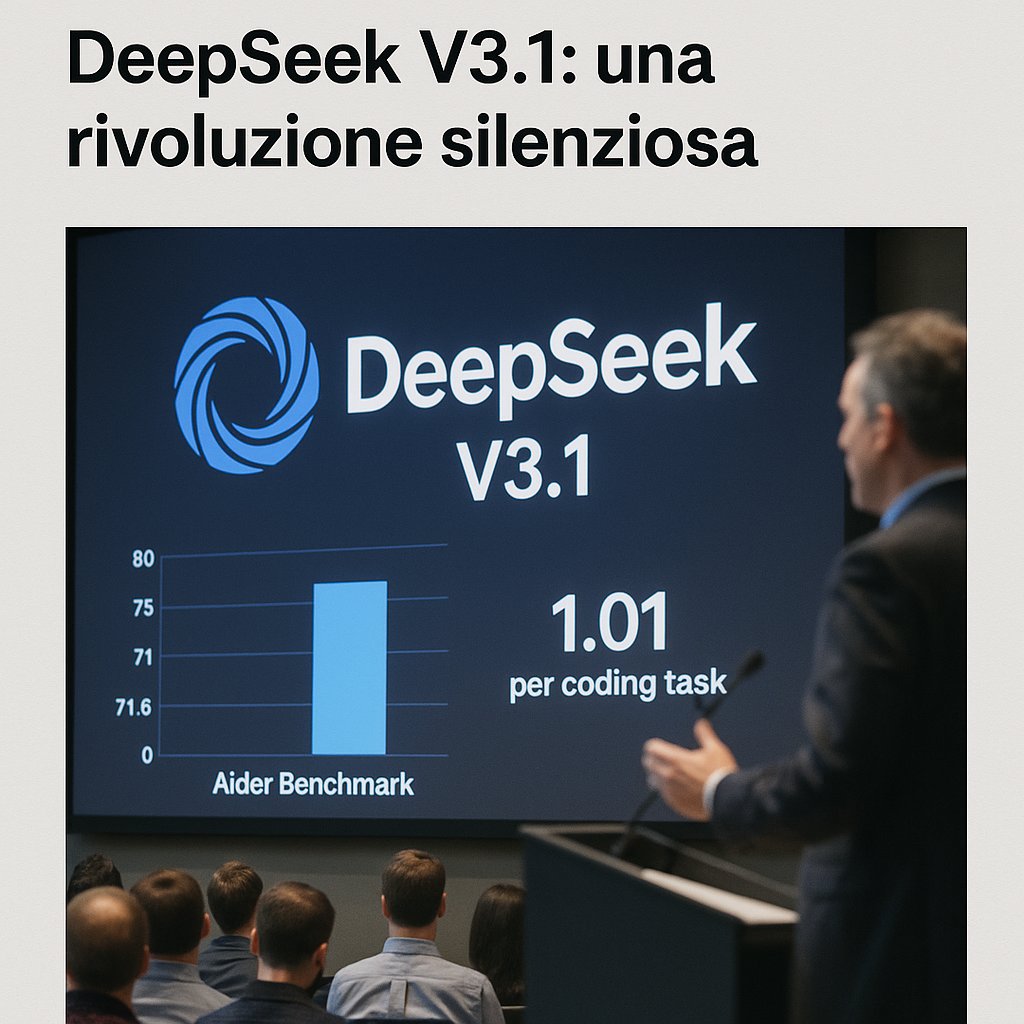

Dietro alle riflessioni teoriche, arrivano cifre che parlano chiaro: su un benchmark di codifica chiamato “Aider”, V3.1 ha ottenuto un sorprendente 71,6 %, ponendosi poco dietro a Claude Opus 4 di Anthropic—ma con un vantaggio notevole nella spesa operativa, ridotta addirittura fino a 70 volte rispetto al concorrente: un solo compito di codifica costa appena 1,01 USD, secondo lo sviluppatore Andrew I. Christianson

Il rilascio avviene in un periodo particolarmente caldo sul fronte dei modelli AI aperti. Solo pochi giorni prima, OpenAI aveva svelato due nuovi modelli open e persino la tanto attesa GPT‑5. Contemporaneamente, circolano voci su R2, un modello soprannominato “di ragionamento” di DeepSeek, il cui lancio sarebbe stato rimandato più volte — sia per ritardi tecnici che per difficoltà legate alla disponibilità di chip NVIDIA o a sensibilità geopolitiche sui chip (come gli inviti del governo cinese all’uso di hardware Huawei).

Ecco dunque che V3.1 non è solo un passaggio tecnico, ma diventa anche una risposta strategica: una base stabile, completa e pubblica che forse segna l’inizio dell’abbandono delle linee R (ragionamento) a favore di un’unica serie V (ibrida), come suggerisce l’esperto cinese Po Jao, che ha osservato la scomparsa silenziosa del tag “R1”, sostituito di default da V3.1.