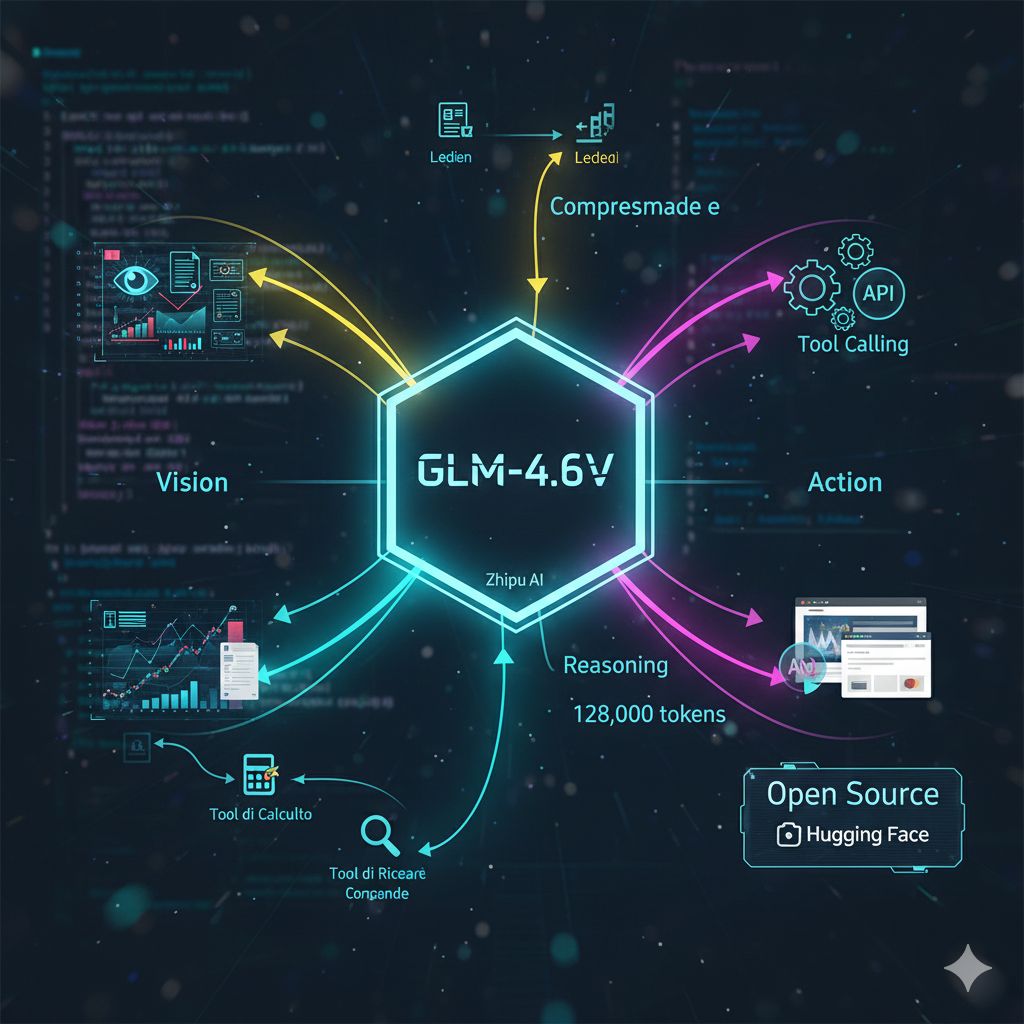

L’evoluzione dell’Intelligenza Artificiale Generativa è ormai guidata dalla necessità di sistemi non solo capaci di comprendere il linguaggio, ma anche di interagire con il mondo reale attraverso la vista e l’azione. In questo scenario dinamico, l’azienda cinese Zhipu AI ha segnato un traguardo significativo con il rilascio in open source della serie GLM-4.6V, un modello multimodale che integra nativamente funzionalità di visione (V per Vision) e la capacità di tool calling per l’esecuzione autonoma di compiti. Questa mossa posiziona il modello tra i leader nell’arena AI a codice aperto, sfidando direttamente i giganti proprietari.

La serie GLM-4.6V, che include una versione di punta (106 miliardi di parametri con 12 miliardi di attivazioni) e una variante ultraleggera (Flash) per la distribuzione locale e a bassa latenza, segna il passaggio da un’AI che osserva e descrive a un’AI che osserva e agisce. La caratteristica più distintiva è il tool calling nativo multimodale. Ciò significa che l’Agente AI può non solo interpretare immagini, screenshot e documenti, ma può anche passare direttamente questi dati visivi come input a strumenti esterni senza la necessità di una conversione intermedia in testo.

Ad esempio, l’Agente può ricevere lo screenshot di un grafico complesso, interpretarlo visivamente e poi utilizzare un tool di ricerca per trovare dati correlati, oppure un tool di calcolo per eseguire analisi sui dati estratti. Il loop si chiude quando il modello è in grado anche di interpretare visivamente gli output restituiti dai tool – come i grafici generati o le pagine web renderizzate – integrandoli nel suo ragionamento per guidare l’azione successiva. Questa capacità di chiudere il ciclo dalla percezione (Visione) alla comprensione, fino all’esecuzione (Tool Calling), rende il GLM-4.6V eccezionalmente potente per workflow complessi.

Il modello GLM-4.6V si distingue anche per la sua capacità di elaborare fino a 128.000 token in una singola finestra di contesto. Questa caratteristica è fondamentale nel contesto multimodale: consente al modello di gestire documenti lunghi e complessi che contengono non solo testo, ma anche grafici, tabelle e layout riccamente formattati, interpretando congiuntamente il contenuto testuale e la sua disposizione visiva.

Questa estesa capacità di contesto, unita alla comprensione multimodale, abilita scenari d’uso avanzati come l’analisi di contratti legali voluminosi con diagrammi allegati, o la generazione di contenuti misti di alta qualità, dove il modello sintetizza in modo coerente testo e immagini da input complessi e da strumenti di recupero dati attivi. È una tecnologia che punta a eccellere nelle attività di ragionamento multimodale e nella gestione autonoma di compiti agentici che richiedono la collaborazione tra dati testuali e visivi.

Zhipu AI ha adottato una strategia proattiva di open source con una licenza che rende i modelli accessibili tramite piattaforme come Hugging Face e ModelScope. Questa scelta non è solo un contributo alla comunità di ricerca, ma una mossa strategica mirata alle aziende e alle istituzioni con stringenti requisiti di sicurezza dei dati e conformità normativa.

Il modello open source permette alle aziende di ospitare l’AI localmente (self-host), garantendo che i dati sensibili non lascino mai l’infrastruttura interna, risolvendo così i problemi di privacy e vendor lock-in tipici dei servizi cloud proprietari. La disponibilità delle weights del modello, inoltre, consente alle aziende di eseguire un fine-tuning profondo su codebase e conoscenze proprietarie, personalizzando l’Agente AI per le proprie esigenze specifiche senza essere vincolate dalle API di fornitori esterni. Questo posiziona il GLM-4.6V come una soluzione di punta per le imprese che cercano una combinazione di prestazioni all’avanguardia, controllo dei dati e flessibilità di personalizzazione.