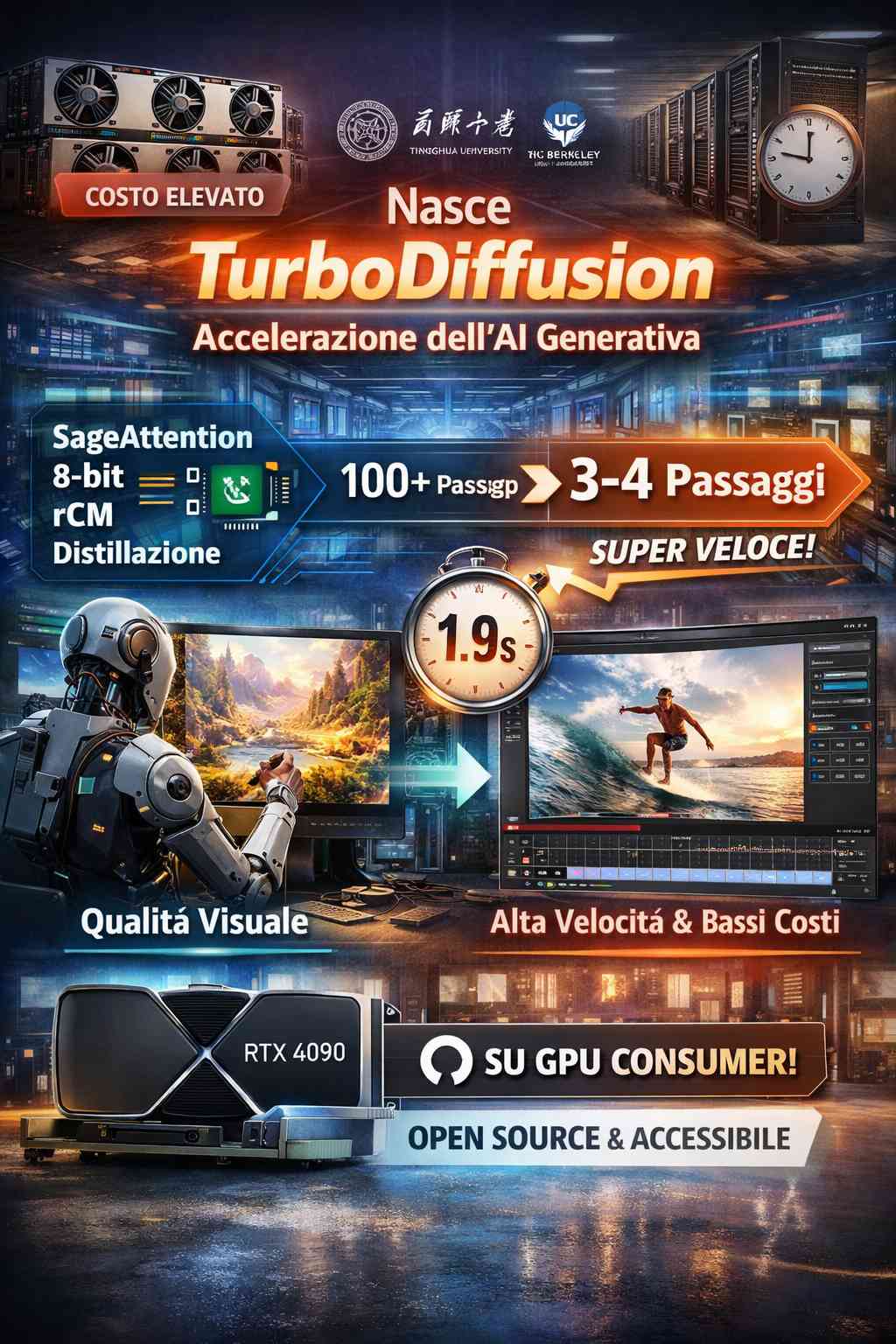

Negli ultimi anni i modelli di generazione di immagini e video basati sulla diffusione hanno compiuto passi enormi in termini di qualità visiva, ma questo progresso è stato accompagnato da un costo computazionale sempre più elevato. Tempi di attesa lunghi, infrastrutture costose e dipendenza da GPU di fascia enterprise sono diventati limiti concreti per la diffusione su larga scala di queste tecnologie. In questo scenario si inserisce TurboDiffusion, un nuovo framework di accelerazione sviluppato da un gruppo di ricercatori della Shengshou Technology cinese, della Tsinghua University e della UC Berkeley, che promette di cambiare radicalmente il rapporto tra qualità, velocità e costi nella generazione di contenuti visivi tramite intelligenza artificiale.

TurboDiffusion non è un nuovo modello generativo in senso stretto, ma un framework di inferenza pensato per essere applicato ai modelli di diffusione già esistenti. Questo aspetto è particolarmente rilevante perché consente di ottenere miglioramenti drastici delle prestazioni senza dover riprogettare da zero le architetture o rinunciare alla qualità visiva che ha reso popolari questi modelli. L’obiettivo dichiarato dei ricercatori è semplificare e comprimere l’intero processo di generazione, intervenendo in modo mirato sui colli di bottiglia computazionali che rallentano immagini e video generati dall’IA.

Uno dei primi interventi riguarda il meccanismo di attenzione, una delle parti più costose dal punto di vista computazionale. TurboDiffusion sostituisce l’approccio di Sparse Linear Attention, che seleziona solo le informazioni più rilevanti ma resta comunque oneroso, con una versione di attenzione accelerata a basso numero di bit chiamata SageAttention. Questa scelta permette di ridurre drasticamente il carico di calcolo mantenendo la capacità del modello di catturare le relazioni visive più importanti, un fattore chiave per preservare la coerenza e la qualità delle immagini generate.

Un secondo elemento fondamentale è l’uso della distillazione a stadi, indicata come rCM. Nei modelli di diffusione tradizionali, la generazione di immagini o video avviene attraverso decine o addirittura centinaia di passaggi iterativi. TurboDiffusion riduce questo numero in modo drastico, portandolo da circa 100 a soli 3 o 4 passaggi. Questo cambiamento ha un impatto diretto sui tempi di inferenza, perché ogni passaggio eliminato si traduce in una riduzione immediata del tempo necessario per ottenere il risultato finale.

A questi interventi si aggiunge una forte ottimizzazione a livello numerico. I ricercatori hanno applicato la quantizzazione a 8 bit, riducendo di circa la metà le dimensioni effettive del modello. Questo consente di sfruttare in modo efficiente le unità di calcolo INT8 Tensor Core delle GPU moderne, aumentando ulteriormente la velocità di elaborazione. Un aspetto particolarmente interessante è che, nonostante questa riduzione aggressiva della precisione numerica, il framework riesce a mantenere stabilità e coerenza visiva anche su immagini ad alta risoluzione e su sequenze video di lunga durata.

I risultati sperimentali mostrano chiaramente la portata di questa accelerazione. Nei test condotti su modelli video open source della linea Wan di Alibaba, TurboDiffusion ha dimostrato di poter ridurre il tempo di generazione di un video standard 480p di cinque secondi da oltre tre minuti a circa 1,9 secondi su una singola GPU consumer NVIDIA RTX 5090. Questo equivale a un’accelerazione di circa cento volte. Ancora più impressionanti sono i risultati sull’alta definizione: un video 720p di cinque secondi, che in precedenza richiedeva fino a ottanta minuti di calcolo, viene generato in un massimo di ventiquattro secondi, con un incremento di velocità che arriva a duecento volte.

Questi numeri vanno interpretati con attenzione, perché rappresentano le migliori prestazioni ottenute in condizioni di test ottimali. In ambienti reali, con carichi di lavoro variabili e infrastrutture meno controllate, i tempi potrebbero essere più elevati. Tuttavia, anche considerando questo fattore, il salto di prestazioni resta significativo e indica un cambiamento strutturale nel modo in cui la generazione di contenuti visivi può essere affrontata.

Un altro aspetto chiave di TurboDiffusion è la sua natura completamente open source. Il framework è disponibile su GitHub, insieme ai checkpoint dei modelli e al codice per training e inferenza. Questo rende la tecnologia immediatamente accessibile alla comunità di sviluppatori e ricercatori, favorendo sperimentazione, miglioramenti e integrazioni rapide. È particolarmente rilevante anche il fatto che TurboDiffusion consenta di eseguire modelli di grandi dimensioni su GPU consumer come la RTX 4090, riducendo la dipendenza da soluzioni molto più costose come le NVIDIA A100 o H100. In prospettiva, questo potrebbe democratizzare ulteriormente l’accesso alla generazione avanzata di immagini e video basata sull’IA.

Le reazioni della comunità non si sono fatte attendere. Sviluppatori e ricercatori stanno condividendo sui social video generati direttamente con TurboDiffusion, esprimendo sorpresa per la combinazione di velocità e qualità ottenuta. Alcuni commenti parlano addirittura di un possibile “momento DeepSeeker” per il settore dei video generativi, a indicare una svolta improvvisa e potenzialmente dirompente. Anche organizzazioni come AI Native Foundation hanno sottolineato come questa tecnologia possa aprire scenari di produzione video quasi in tempo reale, riducendo costi e cicli di iterazione per applicazioni commerciali.