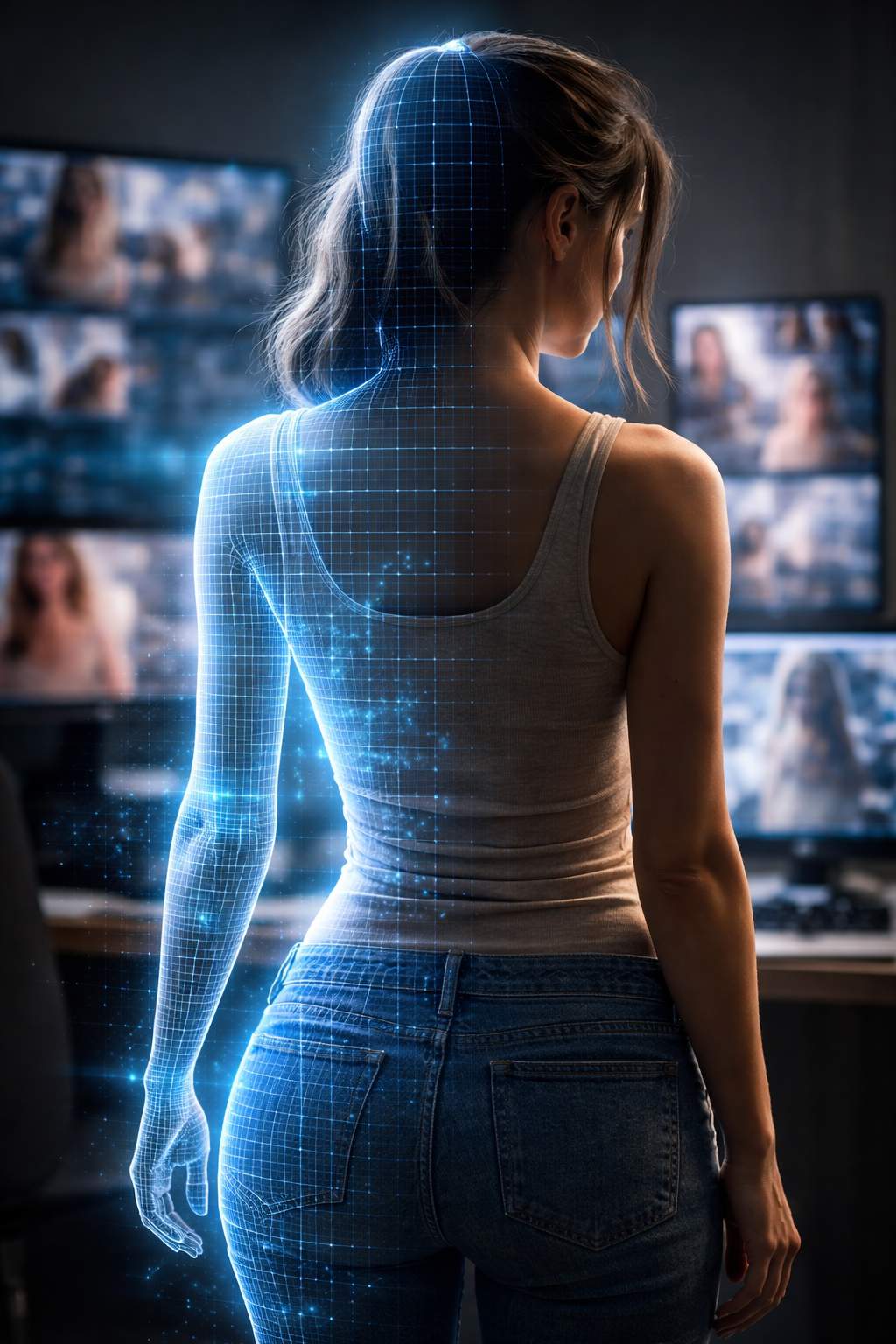

Negli ultimi mesi una serie di notizie e segnalazioni ha portato sotto i riflettori il modo in cui alcuni strumenti basati sull’intelligenza artificiale vengono utilizzati per manipolare immagini di persone, in particolare per creare contenuti che mostrano soggetti in abiti ridotti o in stato di nudità senza alcun tipo di consenso. La questione coinvolge anche tecnologie avanzate come Grok, l’intelligenza artificiale sviluppata da xAI e resa utilizzabile tramite la piattaforma X, che è stata più volte al centro di polemiche relative all’uso improprio dei suoi strumenti di generazione d’immagini. Secondo diverse fonti internazionali, alcuni utenti hanno sfruttato funzioni di Grok Imagine per creare immagini e video in cui i soggetti appaiono nudi o sessualmente suggestivi, anche in assenza di richieste esplicite e senza il consenso delle persone ritratte, generando profonde preoccupazioni etiche e legali attorno alle modalità di utilizzo dell’IA.

La funzione “Spicy” presente in alcuni strumenti di generazione di immagini e video di Grok, ad esempio, ha attirato l’attenzione perché permette di ottenere risultati ad alto contenuto sessuale a partire da input testuali o immagini di partenza, e in alcuni casi è stata utilizzata per creare rappresentazioni non consensuali di persona note o di individui privati. Alcuni report e reportage di settore hanno documentato come, pur non basandosi su richieste esplicite volte a generare nudità, questi sistemi possano facilmente produrre contenuti sessuali o deepfake provocatori se combinati con preset adatti, mettendo in luce la fragilità delle barriere progettate per impedire tali esiti.

Questa situazione non è isolata nell’ambito di Grok, ma riflette un fenomeno più ampio che riguarda varie applicazioni di intelligenza artificiale in grado di manipolare immagini in modo realistico. Piattaforme e siti online sfruttano algoritmi di “nudificazione” per creare immagini di persone nella nudità a partire da fotografie in cui erano vestite, pratica che ha portato a casi di violazione dell’intimità segnalati da figure pubbliche e private. In Italia, ad esempio, la giornalista Francesca Barra ha denunciato la presenza di immagini generate senza consenso che la ritraggono in stato di nudità su un sito dedicato a questo tipo di contenuti, evidenziando come tali tecnologie possano diventare strumenti di abuso e violenza digitale.

La creazione e la diffusione di immagini non consensuali con l’ausilio di intelligenze artificiali sollevano questioni di enorme rilevanza etica, sociale e giuridica. Il rapido suo impiego per manipolare l’immagine e la reputazione di una persona può causare danni profondi, non solo per l’esposizione diretta ma anche per l’effetto psicologico che ne deriva per vittime, famiglie e comunità. Esperti di tecnologia e policy maker sottolineano come tali abusi vadano affrontati con strumenti normativi e tecnici più efficaci, compresi meccanismi di regolamentazione che rendano chiaro che il consenso è imprescindibile nella generazione e nella condivisione di media che ritraggono individui in situazioni intime o sessualmente esplicite.

In diversi Paesi si stanno già discutendo o implementando misure legislative per contrastare la creazione e la diffusione di deepfake o immagini non consensuali; per esempio, alcune giurisdizioni hanno introdotto reati specifici per l’uso non autorizzato di immagini intime, richiedendo alle piattaforme di rimuovere rapidamente tali contenuti e mettendo in campo sanzioni per chi ne è responsabile.

La tecnologia di generazione di immagini e video sta diventando sempre più sofisticata, e con essa cresce la responsabilità di chi la sviluppa e la diffonde. La facilità con cui strumenti come Grok possono essere utilizzati per usi impropri mette in evidenza la necessità di un equilibrio tra innovazione e protezione dei diritti individuali, affinché l’intelligenza artificiale sia uno strumento di progresso e non di abuso.