La generazione automatica di movimenti umani realistici in tre dimensioni è da anni uno degli obiettivi più complessi nel campo della computer grafica e dell’intelligenza artificiale. Con il rilascio open source di HY-Motion 1.0, Tencent compie un passo significativo in questa direzione, proponendo un modello capace di trasformare semplici descrizioni testuali in clip di movimento umano 3D coerenti, fluide e utilizzabili direttamente nelle pipeline di produzione professionali.

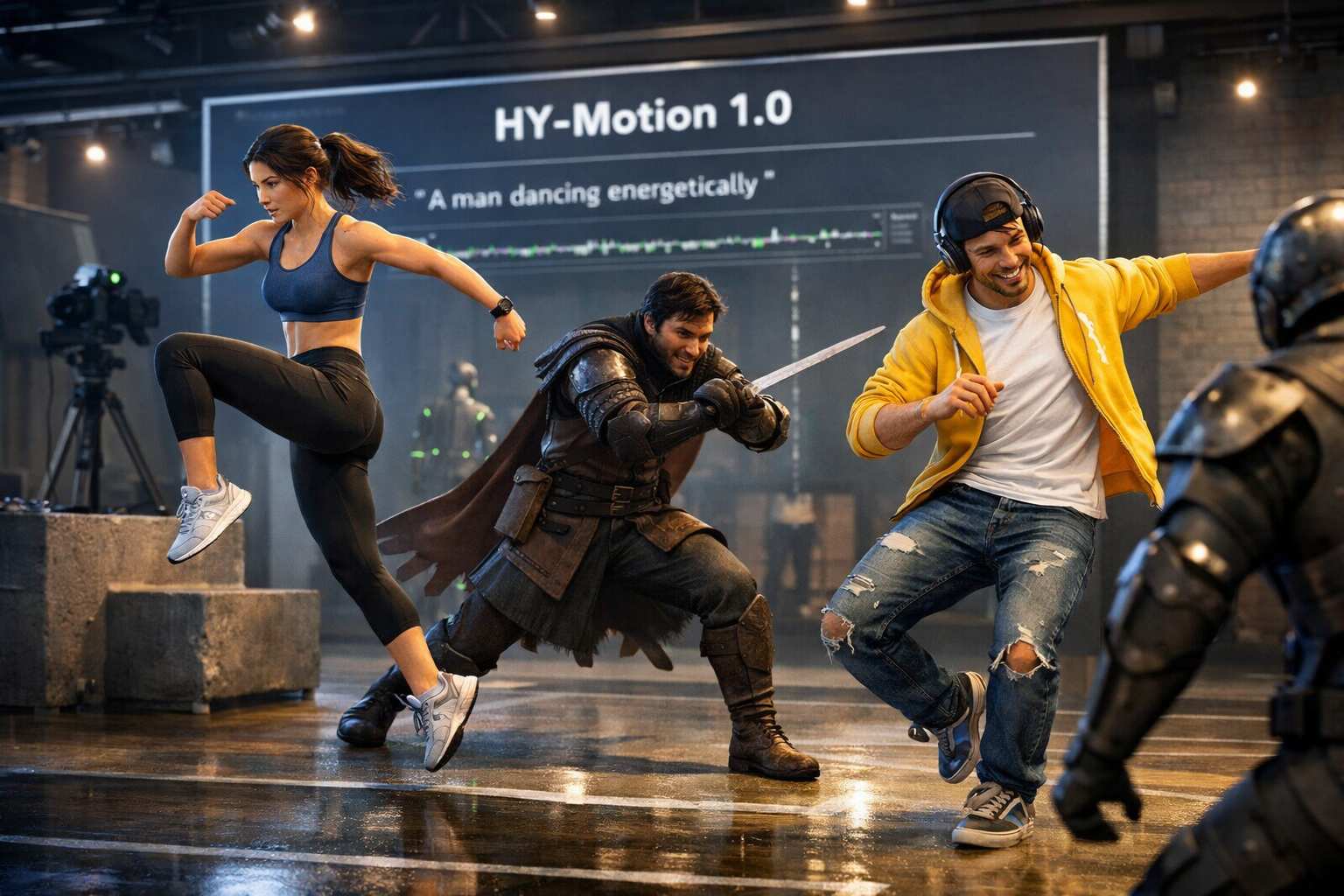

Presentato il 31 del mese scorso, HY-Motion 1.0 consente di generare sequenze di movimento specificando in linguaggio naturale cosa deve fare il personaggio e per quanto tempo. Il modello è pensato per integrarsi senza frizioni in contesti molto diversi tra loro, che vanno dagli esseri umani digitali per il metaverso ai personaggi di videogiochi, fino alle animazioni cinematografiche e alle simulazioni avanzate. L’obiettivo dichiarato è abbassare drasticamente la soglia di accesso alla creazione di animazioni complesse, riducendo la dipendenza da lunghi processi manuali di motion capture o keyframing.

Tencent ha rilasciato due versioni del modello, una standard da circa un miliardo di parametri e una versione Lite più leggera da 460 milioni di parametri, offrendo in entrambi i casi codice, pesi e un’interfaccia Gradio per l’esecuzione locale. La disponibilità tramite GitHub e Hugging Face rafforza la vocazione open research del progetto, rendendolo immediatamente accessibile a ricercatori, studi di animazione e sviluppatori indipendenti.

Le prestazioni del modello affondano le radici in un processo di addestramento particolarmente esteso e strutturato. I ricercatori hanno inizialmente pre-addestrato HY-Motion 1.0 su oltre 3.000 ore di dati di movimento, raccolti da riprese in ambienti reali, dataset di motion capture e risorse di animazione 3D utilizzate nell’industria videoludica. A questa fase è seguita una messa a punto accurata basata su circa 400 ore di dati di alta qualità, con l’obiettivo di migliorare precisione e naturalezza dei movimenti generati.

Un ulteriore salto di qualità è stato ottenuto attraverso l’apprendimento per rinforzo, sfruttando feedback umano e modelli di ricompensa per aumentare l’allineamento tra le istruzioni testuali e il movimento prodotto. Il dataset finale copre circa 200 categorie di movimento, organizzate in grandi famiglie che includono camminata, sport, attività quotidiane e interazioni sociali. Questo approccio consente al modello di gestire sia azioni semplici sia sequenze più articolate, mantenendo coerenza temporale e credibilità fisica.

Dal punto di vista architetturale, HY-Motion 1.0 adotta una struttura ibrida basata su diffusion transformer, nota come DiT. Il modello separa inizialmente le informazioni testuali da quelle legate al movimento, le elabora in modo indipendente e le riunisce successivamente in un unico flusso multimodale. Questa scelta permette di comprendere con maggiore precisione quali parti della descrizione testuale corrispondano a specifici pattern di movimento, riducendo ambiguità e interpretazioni errate.

Per la comprensione del testo, i ricercatori hanno integrato modelli come Qwen3 e CLIP, combinando la capacità di cogliere il significato dettagliato delle frasi con una visione più ampia del contesto semantico. Sul fronte della generazione temporale, invece del classico approccio di diffusione è stato utilizzato il metodo del flow matching. Questa tecnica modella l’evoluzione della distribuzione dei movimenti nel tempo, calcolando la velocità di transizione tra stati successivi e garantendo una generazione stabile anche quando la durata delle sequenze aumenta. Il risultato è un movimento più continuo e naturale, meno soggetto a artefatti o discontinuità.

I risultati delle valutazioni confermano la solidità dell’approccio. In test umani condotti su oltre 2.000 prompt, HY-Motion 1.0 ha raggiunto punteggi elevati sia nella capacità di seguire le istruzioni sia nella qualità del movimento, superando in modo netto altri modelli pubblici di conversione da testo a movimento. Un aspetto particolarmente interessante emerso dalle analisi è che, mentre la comprensione delle istruzioni continua a migliorare con l’aumentare delle dimensioni del modello, la qualità del movimento sembra già avvicinarsi a una soglia di saturazione con modelli di dimensioni medie. Questo suggerisce che, in futuro, l’efficienza e l’ottimizzazione potrebbero diventare più importanti della semplice scalabilità.

Tencent ha dichiarato di aver scelto l’open source per stimolare la ricerca e accelerare la transizione verso la generazione automatica di dati 3D sul movimento umano, con l’auspicio di favorire anche lo sviluppo di applicazioni commerciali. Va però sottolineato che l’utilizzo del modello è soggetto a una licenza separata nel caso in cui il numero di utenti attivi mensili superi il milione, e che al momento non è disponibile in Corea, nel Regno Unito e nell’Unione Europea per assenza di accordi di licenza.