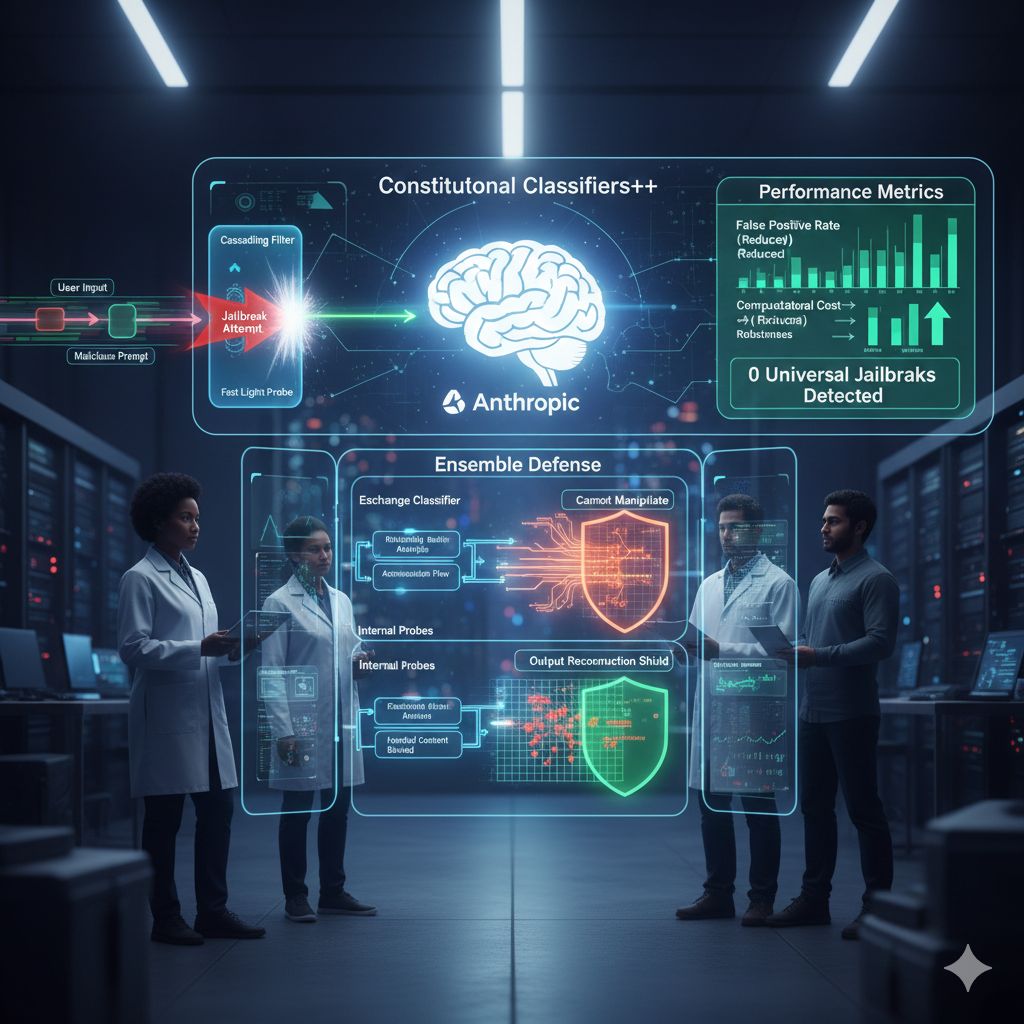

La sicurezza dei grandi modelli linguistici (LLM) ha compiuto un passo in avanti decisivo con l’ultimo annuncio di Anthropic, che ha introdotto una nuova architettura di difesa denominata Constitutional Classifiers++. Questo sistema rappresenta l’evoluzione di una tecnologia rilasciata solo un anno fa, ma con miglioramenti tali da rendere obsoleti i precedenti standard di protezione. L’obiettivo principale è prevenire il cosiddetto “jailbreak”, ovvero quella pratica attraverso cui utenti malintenzionati cercano di forzare l’intelligenza artificiale a ignorare i propri protocolli di sicurezza per generare contenuti dannosi o proibiti.

Il cuore di questa innovazione risiede nel superamento dei limiti strutturali delle difese di prima generazione. Sebbene le versioni precedenti fossero efficaci nel bloccare la stragrande maggioranza dei tentativi, esse portavano con sé due effetti collaterali indesiderati: un aumento significativo dei costi di calcolo e una certa tendenza all’eccesso di prudenza, che portava il modello a rifiutare anche domande del tutto innocue. Con l’introduzione della versione “++”, Anthropic è riuscita a invertire questa rotta, riducendo drasticamente i falsi positivi e, contemporaneamente, abbattendo il sovraccarico computazionale, rendendo la sicurezza non solo più robusta ma anche più economica da gestire su larga scala.

Uno degli elementi più interessanti del nuovo sistema è l’adozione di una “difesa d’insieme” (ensemble defense), progettata per neutralizzare attacchi sempre più sofisticati come la ricostruzione e l’offuscamento dell’output. In un attacco di ricostruzione, l’aggressore divide un’informazione pericolosa in piccoli frammenti apparentemente innocui, sperando che il sistema non colga il disegno complessivo. Per contrastare questa tattica, Anthropic ha sviluppato un “classificatore di scambio” che analizza la relazione profonda tra l’input dell’utente e l’output del modello, monitorando l’intero flusso conversazionale anziché i singoli messaggi isolati.

Per mantenere il sistema veloce ed efficiente, gli ingegneri hanno implementato un’architettura a cascata. Questo meccanismo funziona come un filtro a più livelli: una prima sonda leggera e velocissima scansiona tutto il traffico in entrata e uscita con costi minimi; solo quando viene rilevata un’anomalia o un sospetto, la richiesta viene inoltrata a un secondo classificatore, molto più potente e preciso, che esegue un’analisi approfondita. Questo permette di riservare la massima potenza di calcolo solo ai casi realmente critici, garantendo risposte istantanee per la quasi totalità degli utenti legittimi.

Un’altra innovazione fondamentale riguarda l’uso di “sonde interne” che leggono direttamente i pattern di attivazione neuronale del modello. È un processo che Anthropic paragona all’intuizione umana: ancora prima che Claude decida consapevolmente come rispondere, all’interno della sua rete neurale emergono segnali che indicano se il contenuto elaborato ha una natura dannosa. Poiché questi stati interni sono estremamente difficili da manipolare per un aggressore esterno, questa tecnica si è rivelata una barriera quasi insormontabile.

I risultati ottenuti durante le fasi di test su modelli di punta come Claude Sonnet 4.5 e Claude Opus 4.0 sono impressionanti. Dopo migliaia di ore di tentativi di violazione da parte di team specializzati (red teaming), è stata scoperta solo una vulnerabilità ad alto rischio su quasi duecentomila casi analizzati. Al tempo stesso, il tasso di rifiuto per le domande comuni è sceso a livelli minimi, dimostrando che è possibile proteggere un’intelligenza artificiale senza comprometterne l’utilità o la piacevolezza d’uso. Anthropic ha sottolineato con orgoglio che, al momento, nessun metodo di jailbreak universale è riuscito a scardinare questo nuovo scudo digitale.