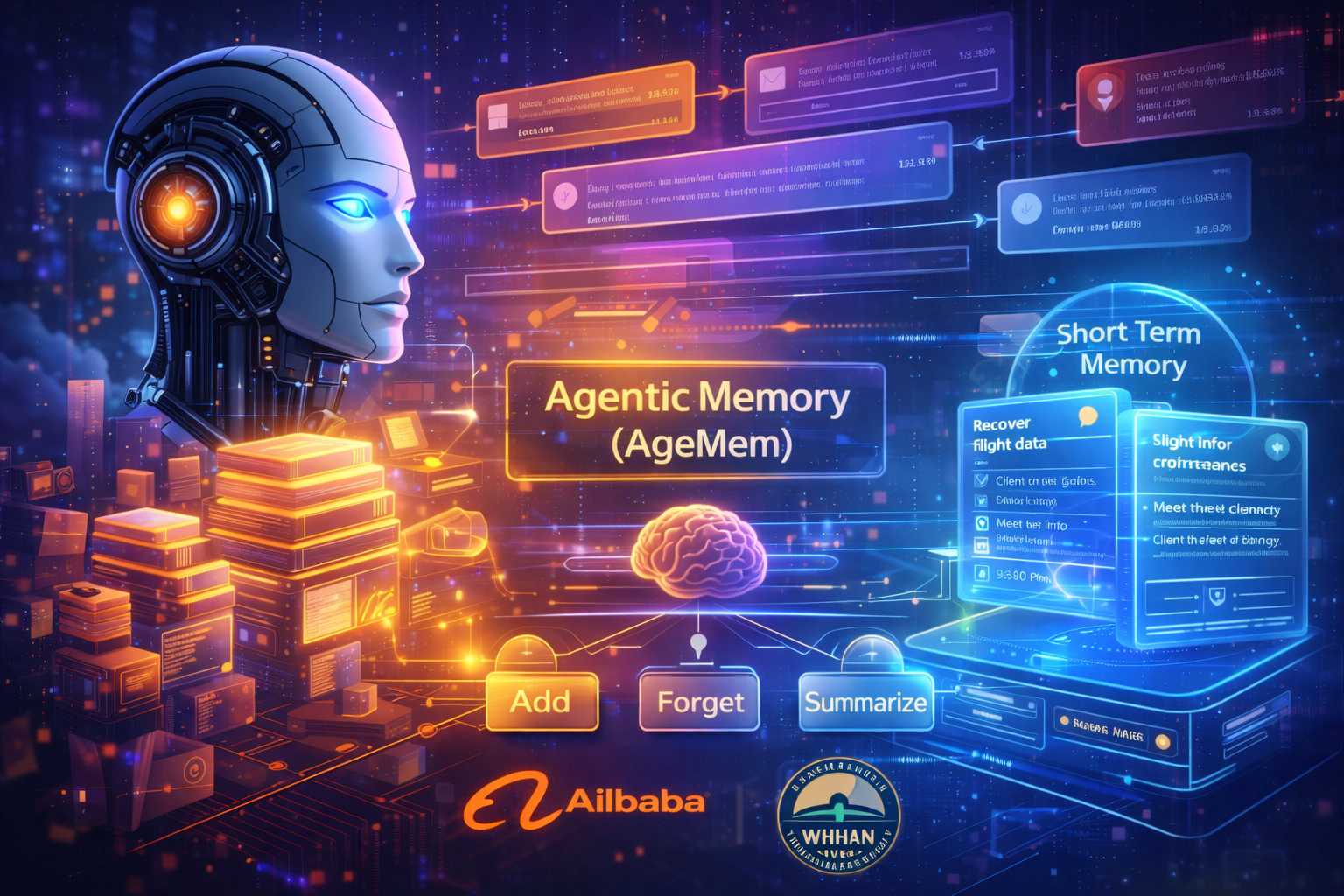

Uno dei limiti strutturali più noti dei Large Language Model non riguarda tanto la capacità di generare testo coerente o di risolvere compiti complessi, quanto la gestione della memoria nel tempo. Gli LLM sono estremamente efficaci nel lavorare su contesti limitati, ma diventano fragili quando devono mantenere informazioni rilevanti attraverso conversazioni lunghe, interazioni distribuite o sequenze di decisioni che richiedono di ricordare dettagli lontani nel tempo. È proprio su questo nodo che interviene un nuovo framework di apprendimento, chiamato Agentic Memory o AgeMem, sviluppato da ricercatori di Alibaba e della Università di Wuhan, con l’obiettivo di affrontare il problema della memoria in modo radicalmente diverso rispetto agli approcci tradizionali.

Il punto di partenza è una critica netta al modello oggi dominante, che separa artificialmente la memoria a lungo termine da quella a breve termine. Nelle architetture più diffuse, la memoria a lungo termine viene spesso affidata a database vettoriali esterni, mentre quella a breve termine è gestita tramite finestre di contesto scorrevoli, regole di sintesi o meccanismi di compressione. Questo approccio, sebbene pratico, introduce una frammentazione che rende difficile l’integrazione tra ciò che l’agente “ricorda” stabilmente e ciò che sta elaborando nel momento presente, con il rischio concreto di perdere informazioni rare ma cruciali e di aumentare la complessità complessiva del sistema.

AgeMem propone un cambio di prospettiva: la memoria non viene più trattata come un sottosistema separato, governato da regole esterne, ma come parte integrante del comportamento dell’agente. In questo framework, le azioni legate alla memoria vengono collocate nello stesso “spazio d’azione” della generazione linguistica. Ciò significa che, a ogni passo, il modello può decidere autonomamente se produrre testo oppure eseguire operazioni di gestione della memoria, come aggiungere nuove informazioni, modificarle, eliminarle, recuperarle, riassumerle o filtrare contenuti non più rilevanti.

Questa integrazione ha una conseguenza fondamentale: non è più il progettista del sistema a stabilire a priori cosa debba essere ricordato o dimenticato, ma è l’agente stesso a impararlo attraverso l’esperienza. Invece di seguire regole rigide, il modello sviluppa una politica interna che gli consente di valutare dinamicamente il valore informativo di ciò che incontra. In pratica, l’IA impara quando vale la pena conservare un’informazione per il futuro e quando, invece, è più efficiente scartarla o comprimerla.

La necessità di questo approccio emerge chiaramente osservando i limiti degli agenti LLM attuali. La capacità di elaborare contesti simultanei è intrinsecamente limitata, e questo li rende vulnerabili nei compiti di inferenza a lungo termine. Le soluzioni basate sull’esperienza, come l’uso di memorie esterne o di regole di riepilogo, funzionano fino a un certo punto, ma tendono a ottimizzare separatamente memoria a breve e a lungo termine, senza una vera coerenza globale. AgeMem cerca di superare questa dicotomia, trattando la memoria come un comportamento appreso e non come un accessorio.

Anche il metodo di addestramento adottato dai ricercatori riflette questa filosofia. Il framework viene allenato attraverso un processo di apprendimento con rinforzo progressivo articolato in più fasi, pensato per simulare situazioni realistiche in cui un agente deve accumulare, selezionare e recuperare informazioni nel tempo. In una prima fase, l’agente impara a immagazzinare conoscenze nella memoria a lungo termine durante conversazioni naturali, mentre il contesto a breve termine cresce in modo spontaneo. Successivamente, viene posto in un ambiente deliberatamente “rumoroso”, in cui informazioni utili e inutili sono mescolate, costringendolo a usare sintesi e filtraggio per preservare solo ciò che conta davvero. Infine, l’agente deve rispondere a domande chiave recuperando informazioni dalla memoria a lungo termine, riorganizzando il contesto a breve termine e dimostrando di saper utilizzare conoscenze acquisite in passato.

Particolarmente interessante è il modo in cui viene definita la funzione di ricompensa. Invece di limitarsi a valutare la correttezza della risposta finale, il sistema tiene conto in modo bilanciato dell’utilità del risultato, della qualità della compressione del contesto e dell’efficacia della memoria a lungo termine. Viene inoltre introdotta una penalità quando il contesto supera una certa lunghezza, incentivando l’agente a gestire la memoria in modo parsimonioso. Per rendere questo processo più robusto, i ricercatori hanno utilizzato una variante a gradini della Group Relative Policy Optimization, che confronta più percorsi di esecuzione e ne valuta le prestazioni relative.

I risultati sperimentali indicano che questo approccio non è solo elegante dal punto di vista teorico, ma anche efficace nella pratica. Nei benchmark di inferenza a lungo termine più noti, come ALFWorld, SciWorld, BabyAI, i problemi di pianificazione PDDL e HotpotQA, AgeMem ha superato in modo consistente gli agenti con meccanismi di memoria tradizionali. Anche gli indici di qualità della memoria a lungo termine hanno mostrato miglioramenti significativi, confermando che il modello non solo ricorda di più, ma ricorda meglio.

Un dato interessante riguarda anche l’efficienza del contesto. L’uso combinato di sintesi e filtraggio ha permesso di ridurre la lunghezza dei prompt senza alcun degrado delle prestazioni, segno che una gestione attiva della memoria può alleggerire il carico computazionale invece di appesantirlo. Gli esperimenti di ablazione hanno inoltre mostrato che i diversi componenti del framework contribuiscono in modo indipendente ai miglioramenti osservati, rafforzando l’idea che la memoria, quando viene appresa come parte della politica dell’agente, diventa un fattore chiave delle sue capacità cognitive.

Nel complesso, AgeMem suggerisce un cambio di paradigma importante. La memoria di un agente intelligente non dovrebbe essere vista come un archivio esterno o come un vincolo da gestire con espedienti tecnici, ma come una competenza da apprendere insieme al linguaggio e al comportamento. Rendendo esplicite le operazioni di archiviazione, recupero, sintesi e filtraggio e integrandole nel processo decisionale, gli agenti possono sviluppare una forma di “disciplina cognitiva” che li rende più stabili, efficienti e capaci di mantenere il contesto nel lungo periodo. È un passo significativo verso sistemi di intelligenza artificiale che non si limitano a reagire al presente, ma sanno davvero ricordare, dimenticare e usare il passato in modo funzionale.