La strategia di Meta per mantenere la propria leadership nel campo dell’intelligenza artificiale generativa e della ricerca open-source si fonda su una trasformazione radicale della propria infrastruttura computazionale. Al centro di questa evoluzione si colloca l’adozione massiva dell’architettura NVIDIA Blackwell, progettata per superare i limiti fisici e logici incontrati dalle precedenti generazioni di GPU. Questa transizione non riguarda solo un incremento della potenza di calcolo grezza, ma introduce un nuovo paradigma nella gestione di carichi di lavoro che prevedono modelli con trilioni di parametri, come le future iterazioni della famiglia Llama. L’obiettivo è creare un ecosistema hardware e software capace di supportare l’addestramento distribuito su una scala senza precedenti, ottimizzando al contempo l’efficienza energetica e il throughput dei dati.

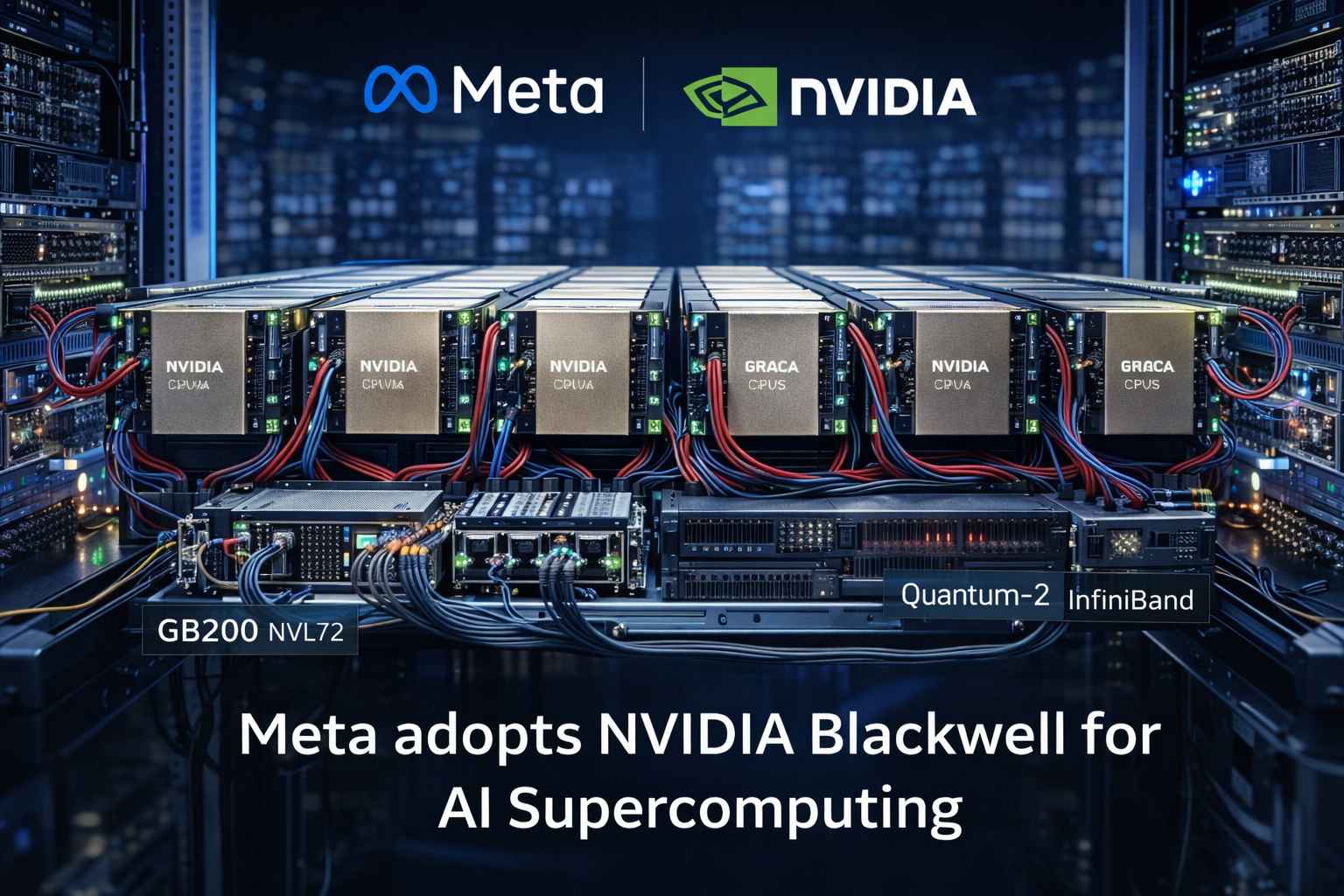

L’elemento tecnico distintivo di questa nuova infrastruttura è l’implementazione della piattaforma NVIDIA GB200 NVL72, che agisce come un unico, gigantesco computer a livello di rack. Questa configurazione interconnette 72 GPU Blackwell e 36 CPU Grace utilizzando la tecnologia NVLink di quinta generazione, creando un dominio a memoria condivisa estremamente veloce. Per Meta, questo significa poter gestire modelli che richiedono una comunicazione costante e a bassissima latenza tra i nodi, riducendo i colli di bottiglia che tipicamente affliggono l’addestramento distribuito. Il motore Transformer Engine di seconda generazione, integrato nei chip Blackwell, gioca un ruolo cruciale permettendo l’uso del formato di precisione FP4, che raddoppia le capacità di addestramento e inferenza mantenendo un’elevata fedeltà del modello, un fattore determinante per scalare verso l’intelligenza artificiale generale (AGI).

Parallelamente alla potenza di calcolo, Meta sta ridefinendo il networking dei propri data center attraverso l’integrazione di tecnologie di interconnessione avanzate come NVIDIA Quantum-2 InfiniBand e le soluzioni Ethernet Spectrum-X. La gestione del traffico dati tra migliaia di GPU richiede un’orchestrazione precisa per evitare la congestione della rete, che potrebbe rallentare i processi di sincronizzazione dei gradienti durante l’addestramento. Spectrum-X, in particolare, è progettato per ottimizzare le prestazioni dell’IA su reti Ethernet standardizzate, offrendo funzionalità di controllo della congestione e instradamento adattivo. Questa sinergia tra calcolo e networking permette a Meta di costruire cluster che operano come un organismo unitario, garantendo che ogni ciclo di clock delle GPU sia sfruttato al massimo delle sue potenzialità operative.

Un altro pilastro fondamentale di questa collaborazione è l’ottimizzazione del software attraverso l’integrazione con lo stack NVIDIA AI Enterprise. Meta sfrutta attivamente le librerie di accelerazione per ottimizzare i framework di deep learning, garantendo che i modelli possano essere distribuiti con la massima efficienza su diverse configurazioni hardware. L’uso di microservizi per l’inferenza e strumenti per la gestione del ciclo di vita dei dati permette ai ricercatori di Meta di concentrarsi sull’innovazione algoritmica, delegando la gestione della complessità infrastrutturale a un’interfaccia software robusta e collaudata. Questo approccio integrato accelera drasticamente il tempo che intercorre tra la concezione di un nuovo modello e la sua effettiva disponibilità per gli utenti finali o per la comunità degli sviluppatori.