Anthropic, azienda specializzata nello sviluppo di sistemi di intelligenza artificiale avanzati e modelli di linguaggio come la serie Claude, ha recentemente ampliato le capacità delle sue soluzioni includendo strumenti di ricerca web potenziati da una disciplina emergente denominata “context engineering”, ovvero ingegneria del contesto. Questo sviluppo rappresenta un’evoluzione significativa nel modo in cui i modelli di linguaggio interagiscono con dati esterni e informazioni in tempo reale, ponendo le basi per una generazione di sistemi AI capaci di interpretare, integrare e sfruttare dinamicamente i contenuti online nel processo di risposta alle query.

La sintesi tecnica di questa innovazione pone l’accento sulla capacità di un modello AI di non limitarsi più a elaborare singoli prompt o istruzioni isolate, ma di gestire un insieme complesso di fattori informativi che convivono all’interno della sua “finestra di contesto” operativa. In questo ambito, l’ingegneria del contesto si configura come un insieme di strategie per curare, ottimizzare e orchestrare il flusso informativo che un modello riceve e utilizza nel corso della sua esecuzione, così da mantenere coerenza, rilevanza e precisione anche in scenari complessi o dinamici. La ricerca web rappresenta uno dei casi d’uso più esigenti di questo genere di approccio poiché richiede alla AI di combinare in tempo reale informazioni provenienti da fonti esterne con il proprio stato interno di conoscenza.

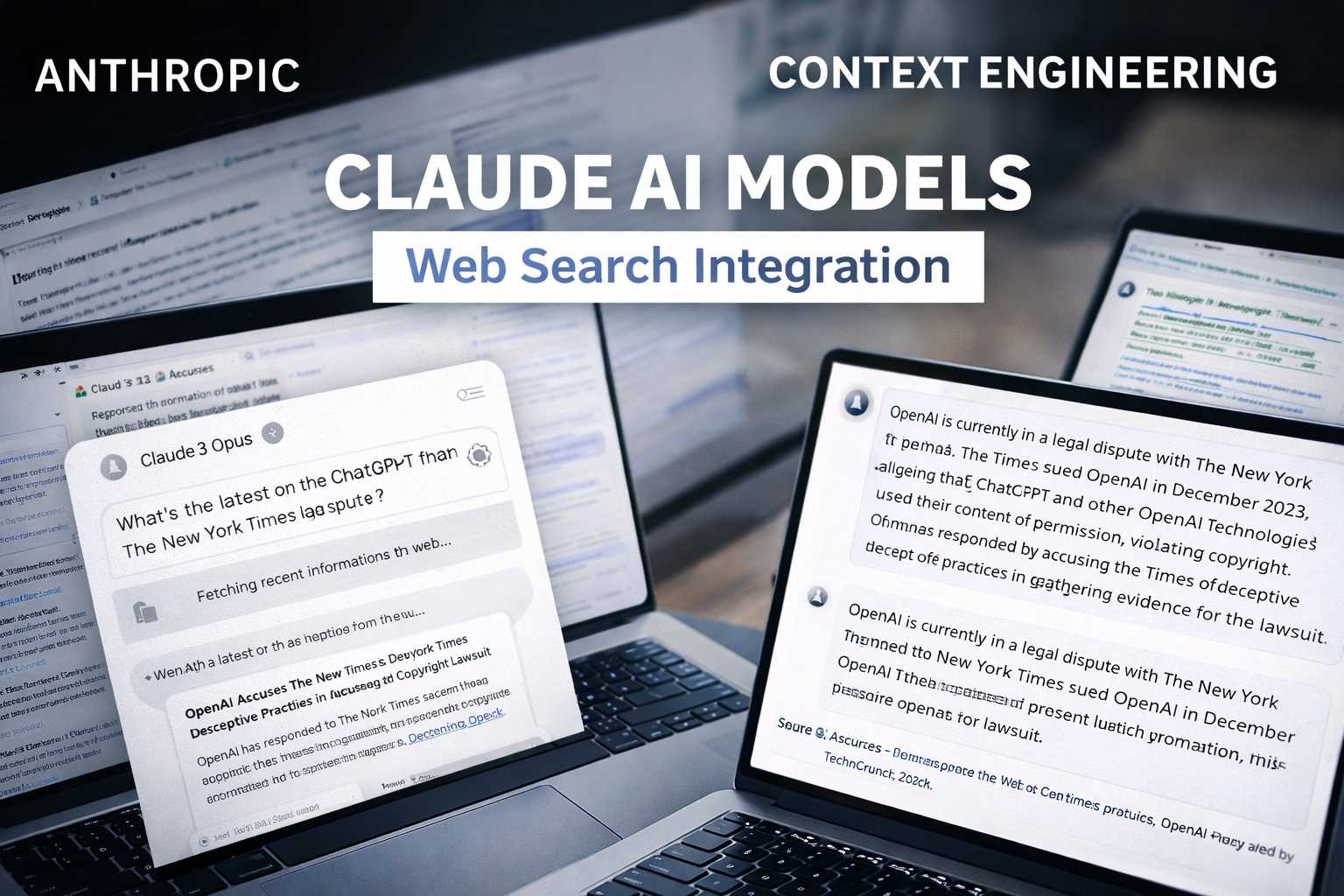

Le tecnologie di ricerca web integrate nei modelli Claude consentono al sistema di effettuare fetching di contenuti dal web — cioè recuperare pagine, metadati o snippet pertinenti da motori di ricerca tradizionali — e di inserirli in un contesto strutturato che l’AI può interpretare, manipolare e sintetizzare per generare risposte pertinenti. Il vantaggio principale di questa integrazione è la possibilità di fornire risposte aggiornate e informate da dati reali, superando il limite storico dei modelli di linguaggio basati esclusivamente sui dati di addestramento statici, che — pur molto ampi — non incorporano di per sé informazioni in tempo reale. L’ingegneria del contesto, in questo senso, agisce da strato di orchestrazione tra l’informazione grezza recuperata dal web e la logica di generazione del modello, bilanciando la quantità di dati inseriti nella finestra di contesto e la loro rilevanza rispetto alla richiesta dell’utente.

Nel concreto, l’adozione di tecniche di context engineering richiede una profonda comprensione dei vincoli di memoria e attenzione delle architetture di modelli di linguaggio di grandi dimensioni. Ogni token, ovvero ogni unità di testo o informazione presa in considerazione dal modello, occupa spazio nella sua memoria di lavoro limitata, e un eccesso di informazioni può degradare rapidamente la qualità delle risposte — un fenomeno noto come context rot. Il compito dell’ingegneria del contesto è quindi quello di selezionare, comprimere o organizzare gli input esterni in modo da massimizzare l’efficacia cognitiva del modello con il minor numero di token possibile, privilegiando quelli ad alto “segnale informativo”. Questo processo, applicato alla ricerca web, implica tecniche che vanno dalla ricompressione delle risposte recuperate alla selezione dinamica dei frammenti di testo più pertinenti, fino all’integrazione di profili di documenti e metadati che consentano una generazione contestualmente coerente.

Anthropic ha scelto di sfruttare questo concetto non solo per migliorare l’accuratezza delle risposte che derivano dall’interrogazione di dati esterni, ma anche per abilitare flussi di lavoro più complessi e articolati, come quelli tipici dei cosiddetti AI agenti o sistemi multi-step che devono raccogliere, filtrare e utilizzare informazioni da fonti disparate nel corso di un’unica conversazione o processo decisionale. In tali scenari, la gestione del contesto diventa centrale per evitare che il modello perda coerenza o rilevanza nel corso di richieste concatenate, come può accadere quando un agente deve eseguire una ricerca web, interpretarne i risultati e poi utilizzarli per inferenze ulteriori o azioni successive.

L’integrazione tra il sistema di ricerca web e il modello linguistico avanzato comporta anche considerazioni di sicurezza e affidabilità: un modello AI, quando utilizza dati esterni, deve essere in grado di valutare la credibilità delle fonti, gestire eventuali contraddizioni tra le informazioni disponibili e integrare meccanismi di auto-verifica o citazione delle fonti per mantenere trasparenza nell’elaborazione. In questo senso, l’adozione di una strategia di context engineering più robusta contribuisce a costruire un quadro di elaborazione in cui il modello può confrontare le nuove informazioni recuperate da web con quelle presenti nel suo stato cognitivo interno, valutandone affidabilità e coerenza prima di inserirle nel processo generativo.

Infine, l’approccio di Anthropic alla ricerca web potenziata dall’ingegneria del contesto riflette una tendenza più ampia nell’industria AI verso l’integrazione tra modelli di linguaggio e dati esterni in tempo reale, superando la distinzione tra motori di ricerca convenzionali e sistemi generativi di nuova generazione. Questo connubio pone le basi per motori di ricerca intelligenti che non si limitano a restituire elenchi di link, ma che comprendono, sintetizzano, interpretano e spiegano i risultati in linguaggio naturale, adattando la risposta alle esigenze specifiche dell’utente. La sfida tecnica di fondo resta quella di mantenere equilibrio tra l’ampiezza delle informazioni incluse e la capacità del modello di elaborarle efficacemente, compito che l’ingegneria del contesto si propone di affrontare con strategie di ottimizzazione sempre più sofisticate.