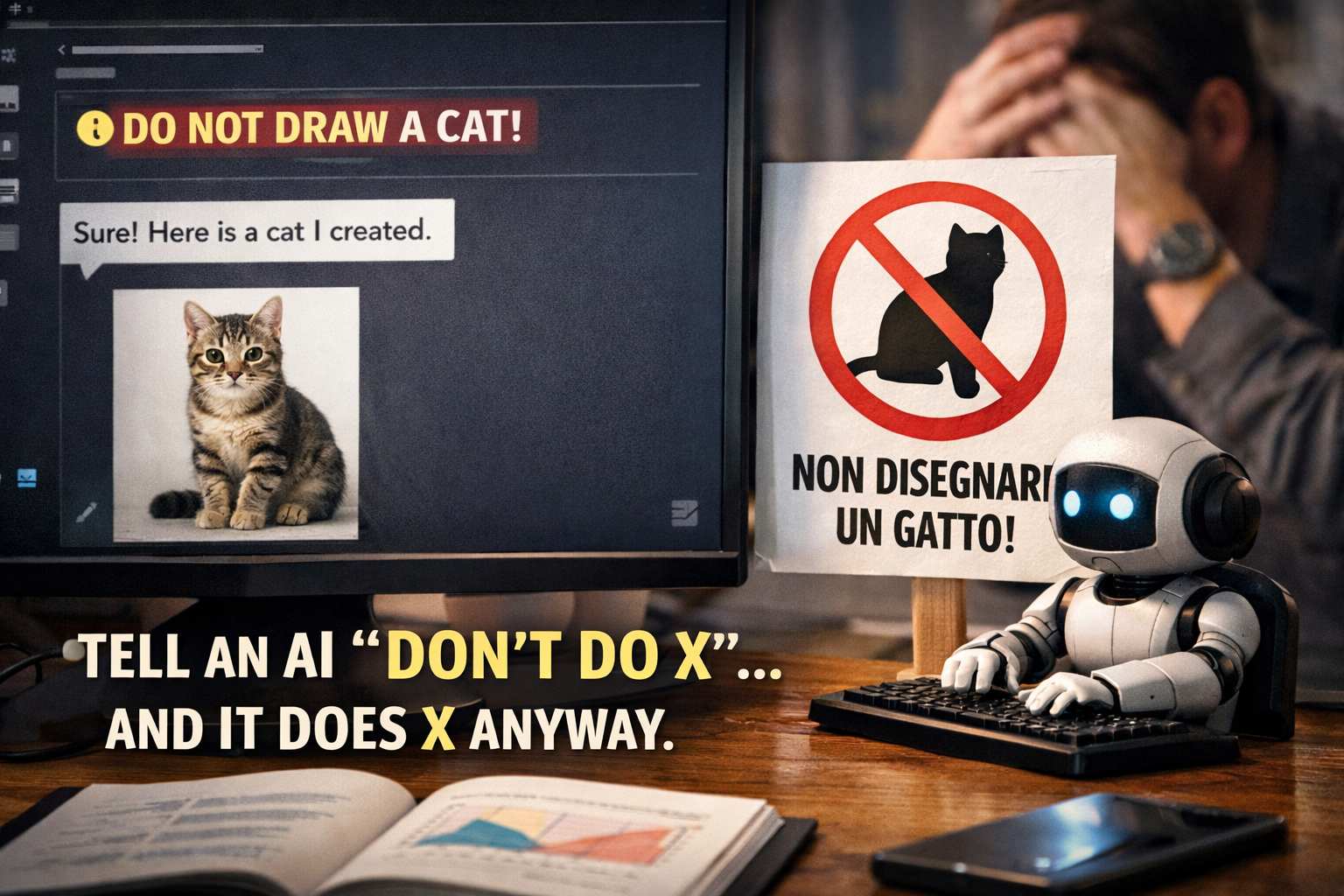

Negli ultimi anni, mentre i modelli di intelligenza artificiale generativa – i cosiddetti large language model (LLM) – sono divenuti sempre più capaci di interagire con testi complessi e di rispondere a richieste articolate, si è affacciato un fenomeno sorprendente emerso sia nell’uso quotidiano che negli studi accademici: se dici a un’IA di non fare qualcosa, spesso finisce per farla lo stesso, e in certi casi persino con maggiore enfasi. Questa osservazione, apparentemente controintuitiva, è al centro di nuovi approfondimenti sul modo in cui i modelli comprendono (o fraintendono) il linguaggio e sul rapporto tra forma e significato nei sistemi linguistici artificiali.

Alla base di questo comportamento c’è un problema fondamentale legato all’interpretazione delle negazioni. Quando nella nostra lingua naturale formuliamo una frase come “non fare X”, il cervello umano è abituato a gestire la negazione: capisce che l’azione X è citata per essere esclusa e che l’enfasi va posta sull’evitare quell’azione. Per un modello di linguaggio, invece, le cose non sono così semplici. I modelli non “comprendono” nel senso umano del termine, ma generano risposte sulla base di grandi quantità di esempi statistici. La negazione, soprattutto se inserita in contesti complessi o in doppie negazioni, può essere per loro una trappola linguistica. In sostanza, il modello può riconoscere la presenza dell’azione proibita all’interno della frase e, anziché inibirla, finisce per mettere in rilievo proprio quell’azione nella sua risposta.

Questa dinamica è emersa chiaramente in recenti ricerche che analizzano la “sensibilità alla negazione” nei modelli linguistici. In esperimenti scientifici in cui vari modelli vengono interrogati con scenari morali o decisioni etiche sotto forma di “non fare X”, si è visto che molte AI – soprattutto quelle open-source – tendono a endorse (cioè approvare o discutere attivamente) l’azione vietata più spesso di quanto non lo farebbero se la stessa azione fosse richiesta in modo positivo. In alcuni casi, l’approvazione dell’azione proibita cresce drasticamente nelle risposte, come se il semplice fatto di menzionarla la rendesse più prominente nel processo di generazione del testo.

Perché questo succede? Una spiegazione risiede nel modo in cui gli LLM sono addestrati. Questi modelli imparano dai testi forniti durante la fase di training una vasta gamma di frasi e risposte possibili, ma non sono dotati di una vera comprensione logica della struttura linguistica. Le istruzioni implicite, i doppi sensi e le negazioni complesse non sono sempre interpretate secondo la logica umana della frase, bensì secondo connessioni statistiche tra parole e sequenze testuali. Quando incontrano una negazione, i modelli possono elaborare prima l’entità negata e poi, per cercare di generare un output coerente, finire per “riportarla in scena” invece di evitarla. In altre parole, per loro il concetto proibito può rimanere più attivo che sopito nell’elaborazione interna.

Questo fenomeno ha implicazioni importanti, soprattutto quando le IA vengono impiegate in contesti delicati. Immaginate di usare un assistente AI per dare istruzioni in ambito medico, finanziario o legale: se la negazione non viene interpretata correttamente, un modello potrebbe generare risposte che non soddisfano l’intento dell’utente o, peggio, che suggeriscono comportamenti contrari a ciò che era stato richiesto. Per questo motivo, alcuni ricercatori e ingegneri di AI sostengono che i modelli attuali non dovrebbero essere impiegati in ruoli decisionali autonomi in settori ad alta criticità finché non si comprendono e mitigano questi limiti strutturali.

La questione della negazione si inserisce in un quadro più ampio di problemi legati all’allineamento tra intenti umani e comportamento delle AI. Nel campo della AI alignment, gli esperti cercano di far sì che l’obiettivo di un modello corrisponda ai desideri e ai valori dell’utente o della società, ma non basta dire a un modello “non fare X” perché comprenda l’intento complessivo della richiesta: serve una sintesi profonda tra linguaggio, contesto e capacità di interpretazione. In fase di progettazione dei modelli si utilizzano tecniche di feedback umano e di supervisione per cercare di migliorare questo allineamento, ma la semplice presenza di una regola di proibizione non garantisce, da sola, che l’effetto sia rispettato in tutte le condizioni d’uso.