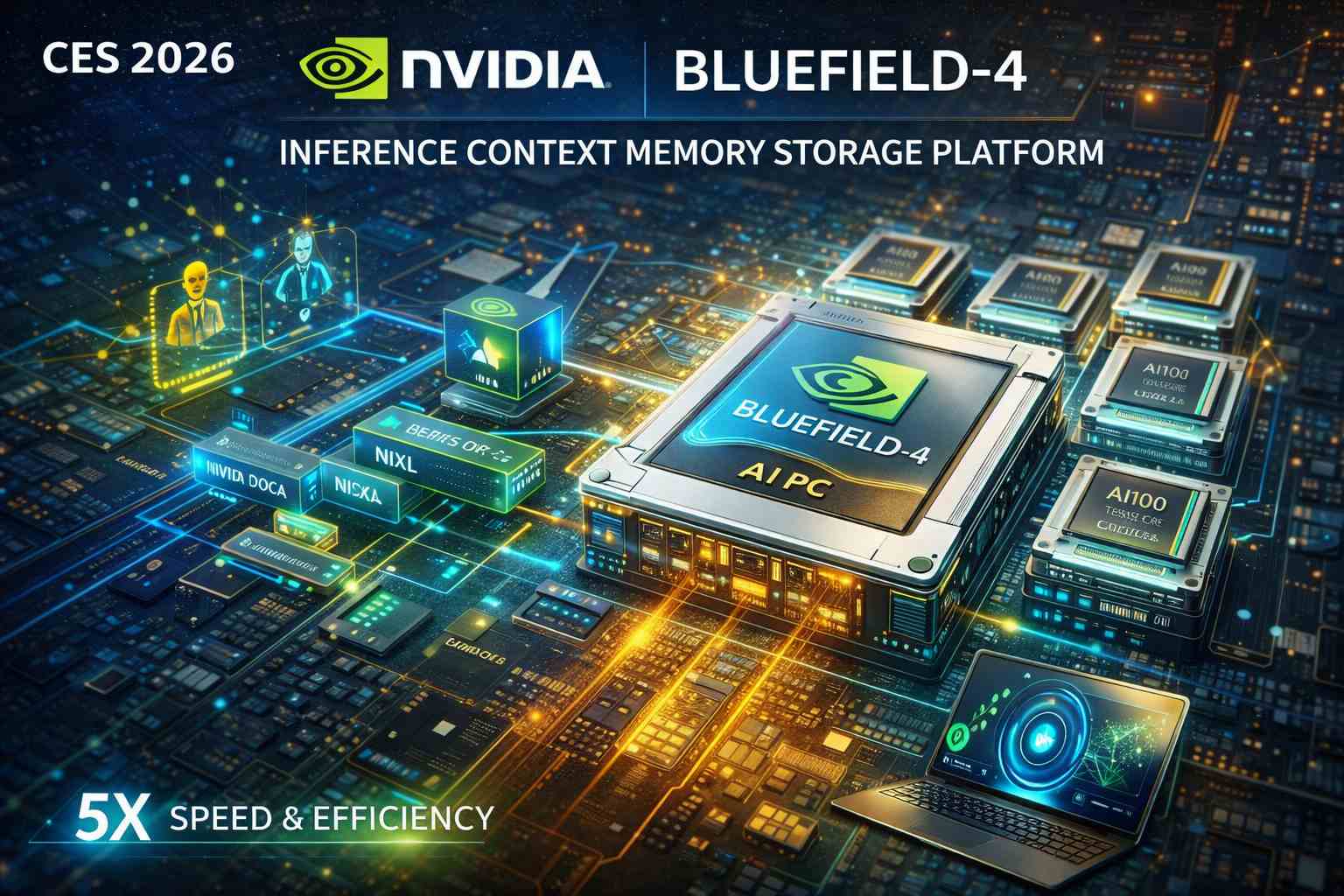

Al CES 2026, Nvidia ha presentato una delle evoluzioni tecnologiche più significative per il futuro dell’intelligenza artificiale a larga scala: BlueField-4, un processore di dati che non si limita a potenziare la velocità di calcolo o i percorsi di rete, ma reinventa completamente il modo in cui i dati di contesto vengono memorizzati, condivisi e utilizzati nei sistemi AI avanzati. Questo cambiamento riguarda in particolare l’emergente dominio dell’inference agentico e dei modelli che non si limitano a rispondere a un singolo prompt, ma generano ragionamenti complessi in più turni, conservando memoria e contesto per tempi prolungati. Per supportare efficacemente questo tipo di workflow, Nvidia ha creato la NVIDIA Inference Context Memory Storage Platform, una nuova classe di infrastruttura di storage AI-native, resa possibile proprio dal BlueField-4.

Il cuore della questione sta nell’enorme quantità di dati di contesto che i moderni modelli AI producono e consumano durante l’inferenza. Quando un agente AI deve mantenere una conversazione che si estende per più interazioni, o deve operare in gruppi di agenti cooperanti, ogni passo del ragionamento genera informazioni che devono essere rapidamente accessibili per essere riutilizzate e manipolate. Questo cosiddetto KV cache (cache chiave-valore) non può restare a lungo nella memoria delle GPU senza creare un collo di bottiglia, perché le GPU sono progettate principalmente per la computazione intensiva, non per la gestione potenti di memorie persistenti su larga scala. Per affrontare questa limitazione, Nvidia ha sviluppato un’architettura di storage dedicata, progettata specificamente per le esigenze dell’AI di nuova generazione.

BlueField-4 non è un chip generico, ma un processore di dati infrastrutturale che estende la memoria disponibile per gli agenti AI ben oltre quella delle GPU, consentendo una condivisione ad alta velocità dei dati di contesto tra sistemi su scala rack. Questa condivisione è resa possibile da tecnologie di rete come Spectrum-X Ethernet, che permettono un accesso a banda larga e bassa latenza ai dati di cache, e dall’integrazione profonda con componenti software come il framework DOCA™, le librerie NIXL e il software Dynamo di Nvidia, che massimizzano la velocità di elaborazione dei token, riducono i tempi di prima risposta e migliorano la reattività nei sistemi multi-turn. Secondo Nvidia, questa nuova infrastruttura può incrementare il numero di token processati al secondo e l’efficienza energetica fino a cinque volte rispetto allo storage tradizionale.

Il valore di un simile approccio emerge soprattutto quando si guarda alla direzione che sta prendendo l’AI moderna. Le applicazioni non sono più semplici chatbot che rispondono a domande isolate, ma sistemi che comprendono la realtà fisica, ragionano su orizzonti temporali prolungati, utilizzano strumenti e mantengono sia una memoria a breve che a lungo termine. Questi agenti generativi avanzati richiedono un’infrastruttura dove storage, memoria e calcolo sono strettamente integrati, e dove il tradizionale modello di archiviazione separata non è più adeguato. È qui che la BlueField-4 entra in gioco, spostando la logica di storage dal dominio secondario a un elemento primario e ottimizzato dell’AI stack.

Non si tratta solo di velocità: questa nuova piattaforma affronta anche una delle sfide più pressanti nella progettazione di sistemi AI su larga scala, ovvero la persistenza del contesto. Mentre i modelli diventano più grandi e i loro campi di applicazione più articolati, lo storage tradizionale può facilmente rappresentare un collo di bottiglia, rallentando l’accesso alle informazioni critiche o richiedendo complesse sincronizzazioni tra GPU e memoria secondaria. BlueField-4 risolve questo problema offrendo un livello di memoria esteso, condiviso e altamente efficiente, che può mantenere dati di contesto persistenti e facilmente accessibili da cluster di sistemi AI, senza compromettere le performance complessive della piattaforma.

Questa tecnologia non è solo una novità isolata: essa si inserisce in un contesto più ampio di evoluzione dell’infrastruttura AI, in cui l’accelerazione hardware, le reti ad alta velocità e i sistemi di storage devono lavorare all’unisono per supportare le esigenze dell’AI “agentic” e di inferenza di nuova generazione. Con BlueField-4, Nvidia non solo allarga la sua proposta tecnologica oltre le GPU e i sistemi di rete, ma propone una visione in cui lo storage diventa un componente nativo e ottimizzato dell’ecosistema AI, essenziale per soddisfare le richieste di performance, efficienza e scala che caratterizzano le applicazioni più avanzate.