In un laboratorio silenzioso tra le stanze di Harvard, un team di ricercatori ha realizzato qualcosa che fino a poco tempo fa pareva appartenere più al regno della fantascienza che a quello della scienza: un computer quantistico capace di funzionare ininterrottamente, senza dover essere riavviato. Sì, hai letto bene: per più di due ore – ed in teoria per un tempo indefinito. È un risultato che potrebbe cambiare radicalmente il modo in cui pensiamo alla stabilità e alla scalabilità dei sistemi quantistici.

Per decenni, i computer quantistici sono stati vincolati da limiti fragilissimi. Anche i più avanzati sono vulnerabili a ciò che i fisici chiamano “perdita atomica” (atom loss): i qubit, queste particelle subatomiche che costituiscono l’unità fondamentale dell’elaborazione quantistica, tendono a sfuggire dal sistema, a “perdersi”, compromettendo il calcolo, introducendo errori, e costringendo i sistemi ad arrestarsi o a essere ricaricati. Si trattava di una vera e propria barriera: anche i dispositivi più evoluti riuscivano a operare per pochi millisecondi, o, nei casi migliori, per qualche decina di secondi. Ma ora, qualcosa sembra aver rotto quel muro.

Nel recente annuncio dell’esperimento, i ricercatori hanno spiegato che il loro sistema — frutto di una collaborazione tra Harvard e MIT — è stato in grado di operare continuamente per oltre due ore. Un salto gigantesco rispetto ai precedenti record, che colloca questa macchina in una nuova era del calcolo quantistico. Secondo i protagonisti del progetto, questa non è solo una miglioria incrementale: è una nuova base su cui costruire sistemi quantistici davvero duraturi.

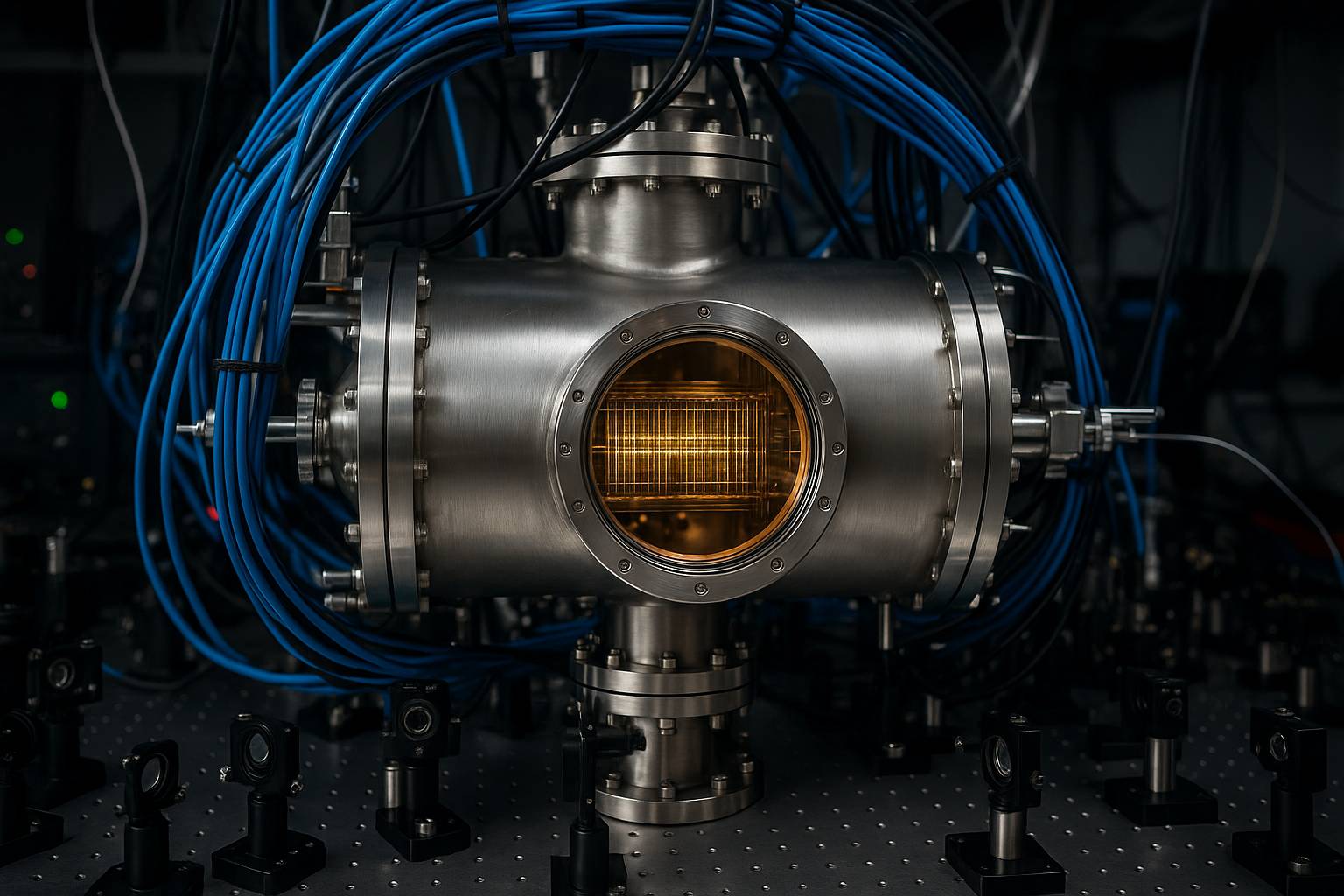

Ma come è stato fatto? Il trucco non è nella pura magia quantistica, ma nella gestione costante del sistema: gli scienziati hanno progettato un dispositivo che reintroduce atomi nel circuito mentre alcuni se ne “perdono”. Si tratta di una combinazione di due strumenti ottici sofisticati: da una parte un “nastro trasportatore ottico reticolare” (optical lattice conveyor belt), che muove atomi lungo una griglia di luce, e dall’altra “pinzette ottiche” (optical tweezers) che possono catturare e posizionare singoli atomi con precisione. In questo modo, il sistema può iniettare fino a 300.000 atomi al secondo, mantenendo circa 3.000 qubit attivi. Ciò significa che, anche se qualche qubit viene perso, ne vengono immediatamente sostituiti, senza che la memoria quantistica subisca degradazioni.

Questo meccanismo non cancella completamente il rischio di perdita atomica, ma gestisce la fragilità in tempo reale. In termini concreti, non esiste più un limite intrinseco, almeno teorico, al tempo di funzionamento continuativo del computer quantistico: basta che il sistema continui a sostituire i qubit perduti, senza interrompere il flusso di calcolo. Come ha detto uno dei ricercatori, “anche se esiste una piccola probabilità che un atomo venga perso, può essere sostituito da un nuovo atomo, quindi l’informazione quantistica memorizzata nel sistema non viene influenzata.”

È vero che due ore possono sembrare un lasso modesto se confrontato con i computer tradizionali che restano accesi per settimane o mesi, ma nel contesto dell’informatica quantistica è un tempo quasi epocale. Fino a poco fa, gli impianti quantistici più avanzati non superavano la decina di secondi, e spesso solo qualche millisecondo. Questo passo avanti ridefinisce il concetto stesso di “autonomia” in ambito quantistico.

I ricercatori stimano che, partendo da questa architettura, nel giro di tre anni si potrebbe arrivare a sistemi che operano indefinitamente — non solo in laboratorio, ma con criteri di robustezza sufficienti per applicazioni pratiche. Un orizzonte che solo poco tempo fa veniva posto a cinque anni o più. Naturalmente, l’obiettivo non è “fare girare il computer per sempre” come una curiosità, ma abilitare calcoli complessi, simulazioni e applicazioni che richiedono continuità di esecuzione per ore, se non giorni.

I potenziali campi che potrebbero beneficiare di una tale rivoluzione sono numerosi: dalla crittografia (dove la potenza quantistica può testare la resistenza delle chiavi crittografiche convenzionali), al finanziario (modellizzazione, simulazioni, ottimizzazione), fino alla medicina e alla scienza dei materiali (simulazioni molecolari, progettazione di farmaci, analisi complesse). Un computer quantistico che non si ferma può fare attività incrementali durante le pause, aggiustare calcoli in corso, analizzare dati continuamente, rendendo molte applicazioni più efficienti.

Questa ricerca coinvolge, al fianco di Harvard, scienziati del MIT, e si basa su piattaforme che condividono strettamente il know-how con spin-off e iniziative come QuEra Computing — startup che sviluppa computer quantistici basati su atomi neutri partendo da ricerche Harvard/MIT.

Per chi non è fisico o coinvolto direttamente nella ricerca, va detto che un computer quantistico “personale” non apparirà nelle nostre case o nei nostri uffici nel prossimo decennio. Le macchine quantistiche restano strumenti da laboratorio, con requisiti estremi di raffreddamento, isolamento, controllo laser e infrastrutture specifiche. Ma il fatto che si stia avvicinando la soglia della continuità operativa è già un segnale potente: significa che stiamo uscendo dal regno delle dimostrazioni puntuali e stiamo entrando in quello dell’affidabilità quantistica.