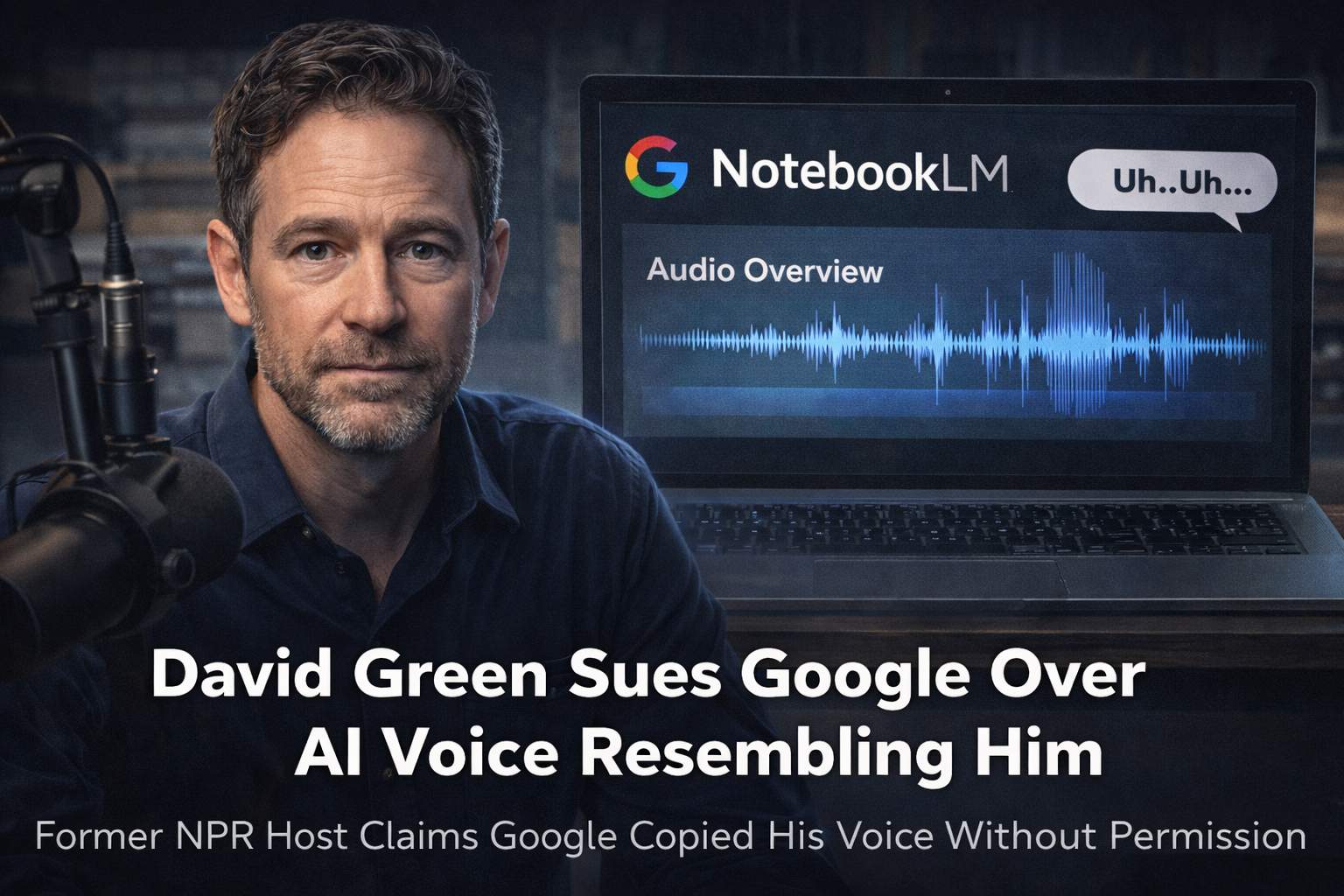

Un nuovo contenzioso legale negli Stati Uniti riporta al centro del dibattito il rapporto tra tecnologie di sintesi vocale basate su intelligenza artificiale e tutela dei diritti individuali. David Green, ex storico conduttore del programma radiofonico pubblico “Morning Edition” e attuale voce del podcast politico di KCRW “Left, Right & Center”, ha intentato una causa contro Google sostenendo che la voce maschile utilizzata nella funzione “Audio Overview” di NotebookLM sia stata sviluppata copiando o imitando in modo sostanziale la sua voce senza autorizzazione.

NotebookLM è uno strumento di intelligenza artificiale che consente agli utenti di caricare documenti e ottenere riassunti e contenuti rielaborati, inclusa la trasformazione dei testi in una forma di podcast conversazionale con un host virtuale. In questo contesto, la qualità e la naturalezza della voce sintetica costituiscono un elemento chiave dell’esperienza utente. Secondo quanto riportato dal Washington Post, l’episodio sarebbe emerso nell’autunno del 2024, quando un conoscente di Green gli chiese se avesse concesso in licenza la propria voce a Google. L’interessato, dopo aver provato personalmente la funzionalità audio del servizio, avrebbe riscontrato una somiglianza che ha definito “agghiacciante”, sottolineando la vicinanza nell’intonazione, nel ritmo del parlato e perfino nell’uso di intercalari come “uh”.

Dal punto di vista tecnico, i moderni sistemi di sintesi vocale neurale si basano su architetture di deep learning addestrate su grandi quantità di dati audio. Tali modelli apprendono rappresentazioni statistiche delle caratteristiche fonetiche, prosodiche e timbriche della voce umana. In alcuni casi, vengono addestrati su dataset composti da voci di doppiatori professionisti che concedono esplicitamente i diritti di utilizzo; in altri, il modello può essere ulteriormente adattato tramite tecniche di fine-tuning o voice cloning per replicare con elevata fedeltà le peculiarità di una voce specifica. Il punto centrale della controversia è stabilire se la voce sintetica in questione sia una creazione generica, basata su un attore vocale regolarmente ingaggiato, oppure se abbia incorporato caratteristiche riconducibili in modo sostanziale alla voce di Green, eventualmente attraverso dati di addestramento che includano registrazioni delle sue trasmissioni radiofoniche.

Google ha respinto categoricamente le accuse. Il portavoce José Castaneda ha dichiarato che la voce maschile della funzione audio di NotebookLM è basata su un doppiatore professionista assunto dall’azienda e che le affermazioni di Green sono infondate. Nella denuncia presentata alla Corte Superiore della Contea di Santa Clara, Green sostiene tuttavia che Google potrebbe aver utilizzato la sua voce come parte dei dati di addestramento. Viene inoltre citata un’analisi forense condotta da una società specializzata, secondo cui la comparazione tra la voce di Green e quella sintetica avrebbe evidenziato una “somiglianza relativamente elevata” compresa tra il 53 e il 60 per cento. Non è però stata fornita prova diretta del percorso di addestramento specifico né della presenza effettiva di registrazioni di Green nel dataset utilizzato.

Sotto il profilo giuridico, il caso si colloca nell’ambito del diritto di pubblicità e del diritto all’immagine, che negli Stati Uniti tutelano l’uso non autorizzato dell’identità di una persona a fini commerciali. La voce, come elemento distintivo dell’identità personale, è stata riconosciuta in precedenti giudiziari come componente protetta. Un riferimento importante è il caso del 1988 in cui la cantante e attrice Bette Midler vinse una causa contro un’azienda automobilistica che aveva utilizzato una doppiatrice per imitare il suo tono vocale in uno spot pubblicitario. In quell’occasione, il tribunale ritenne che l’imitazione deliberata di una voce distintiva potesse configurare una violazione dei diritti di pubblicità, anche in assenza dell’uso diretto della registrazione originale.

Secondo il professore di diritto James Grimmelman della Cornell University, la questione chiave sarà stabilire quanto una voce artificiale debba assomigliare a una persona reale per configurare una violazione e se l’ascoltatore medio possa ragionevolmente confondere la voce sintetica con quella dell’individuo. Questo criterio della “confondibilità” rappresenta un parametro cruciale nei contenziosi legati all’imitazione dell’identità. Nel contesto delle tecnologie AI, tuttavia, la questione si complica ulteriormente: un modello potrebbe non replicare intenzionalmente una voce specifica, ma generare un “archetipo” di voce da anchorman, appreso da grandi volumi di dati audio provenienti da trasmissioni radiofoniche e podcast pubblici.

La vicenda richiama un precedente recente che ha coinvolto OpenAI, la quale aveva rimosso una voce del modello GPT-4o dopo polemiche sulla sua somiglianza con l’attrice Scarlett Johansson. Anche in quel caso, l’azienda aveva dichiarato di aver utilizzato un doppiatore professionista, ma la percezione pubblica di una somiglianza marcata aveva generato un dibattito intenso sulla responsabilità delle aziende AI nella scelta e progettazione delle voci sintetiche.

Un ulteriore elemento di complessità riguarda la trasparenza dei dataset di addestramento. Le aziende tecnologiche raramente divulgano in modo dettagliato le fonti complete dei dati utilizzati per addestrare i modelli vocali, invocando ragioni di riservatezza commerciale. Ciò rende difficile per un attore come Green dimostrare in modo diretto che le sue registrazioni siano state utilizzate. L’eventuale decisione del tribunale potrebbe quindi dipendere non solo dall’analisi tecnica delle somiglianze acustiche, ma anche dalla valutazione delle pratiche di sviluppo e dei processi interni di Google.

Green ha dichiarato di non voler ostacolare l’innovazione nel campo dell’intelligenza artificiale, ma di ritenere che, qualora la sua voce fosse stata utilizzata o replicata in modo sostanziale in un prodotto commerciale, sarebbe stato necessario almeno richiedere un consenso esplicito. La sua posizione evidenzia un nodo fondamentale per l’industria AI: la distinzione tra ispirazione statistica derivante da grandi dataset e appropriazione indebita di caratteristiche identitarie individuali.

Il caso rappresenta un esempio emblematico delle tensioni crescenti tra sviluppo di tecnologie generative e diritti della personalità. La decisione della Corte californiana potrebbe contribuire a definire standard più chiari su quando una voce sintetica oltrepassa la soglia della legittima creazione tecnologica per entrare nel territorio della violazione del diritto di pubblicità. In un’epoca in cui le voci artificiali diventano sempre più indistinguibili da quelle reali, la delimitazione giuridica di questa soglia assume un’importanza strategica non solo per le aziende tecnologiche, ma anche per giornalisti, artisti e professionisti la cui identità pubblica è strettamente legata alla propria voce.