La generazione di immagini tramite Intelligenza Artificiale sta vivendo un momento di rapida evoluzione. I modelli di diffusione attuali hanno già raggiunto un livello sorprendente nella riproduzione di texture fini, dettagli microscopici e sfumature estetiche, ma presentano un limite strutturale significativo: una debolezza nella comprensione semantica dell’intera scena. Questi modelli eccellono nel “come” generare un dettaglio, ma spesso falliscono nel “cosa” o nel “perché” dell’immagine nel suo complesso, limitando la loro capacità di produrre risultati coerenti, generalizzabili e profondamente legati al significato concettuale dell’input.

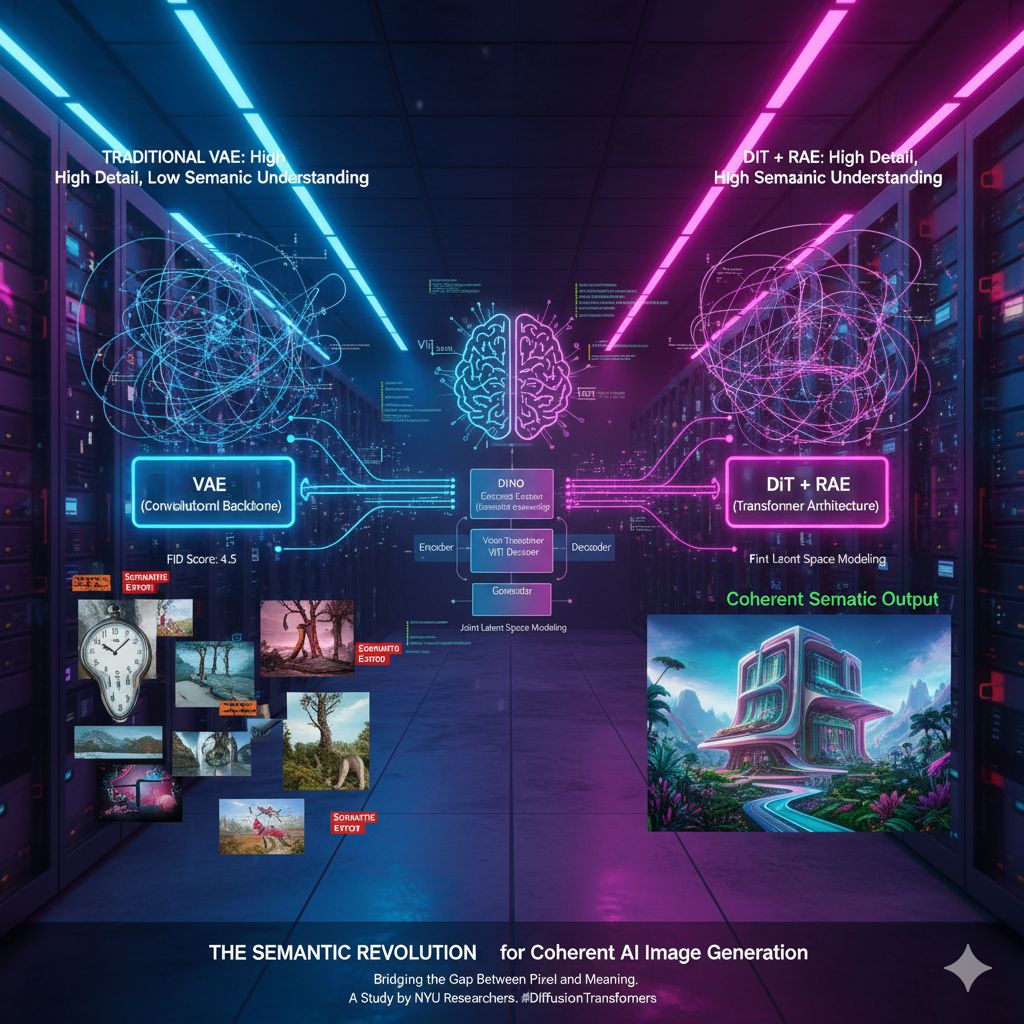

La maggior parte dei modelli di diffusione, inclusi alcuni dei più noti, si affida al metodo dell’Autoencoder Variazionale (VAE) per la compressione delle informazioni. Il VAE lavora riducendo un’immagine ad alta risoluzione in una rappresentazione compressa in uno spazio latente e poi invertendo il processo per la generazione. Sebbene efficace per i dettagli, i ricercatori della New York University (NYU) hanno evidenziato che l’approccio VAE, spesso basato su backbone convoluzionali, non riesce a cogliere appieno il significato o la struttura globale dell’immagine. In sostanza, il VAE tratta la modellazione dello spazio latente e la modellazione generativa come processi separati, creando un gap tra la percezione e la sintesi.

Per colmare questa lacuna, i ricercatori della NYU hanno introdotto una nuova architettura chiamata Diffusion Transformer (DiT) che incorpora un Representation Autoencoder (RAE), una soluzione che promette di rivoluzionare la generazione di immagini fornendo ai modelli la capacità di comprendere veramente il significato di ciò che stanno creando.

L’innovazione chiave di RAE risiede nell’abbandonare le reti convoluzionali a favore di una combinazione strategica di componenti pre-addestrati e architetture transformer. Il RAE utilizza un encoder di rappresentazione pre-addestrato, come DINO di Meta, e lo combina con un decoder basato sul Vision Transformer (ViT).

Questo approccio è fondamentale perché sfrutta un encoder che è già stato addestrato su enormi set di dati per la comprensione semantica. A differenza del VAE che deve imparare sia la compressione che la semantica ex novo, il RAE parte da una comprensione semantica già ricca e la indirizza verso la generazione. I ricercatori spiegano che questo metodo progetta la modellazione dello spazio latente e la modellazione generativa insieme, rafforzando il legame tra comprensione e generazione. Per modificare e creare un’immagine coerente e significativa, un modello deve innanzitutto “capire cosa contiene”.

I vantaggi di questa architettura RAE sono molteplici e quantificabili. Dal punto di vista computazionale, il RAE si dimostra notevolmente più efficiente rispetto al VAE standard, richiedendo un overhead computazionale significativamente inferiore – fino a sei volte più efficiente nell’encoder e tre volte più efficiente nel decoder.

Questa efficienza si traduce in una velocità di addestramento eccezionale: il modello di diffusione RAE si addestra fino a 47 volte più velocemente e apprende 16 volte più rapidamente rispetto ai modelli all’avanguardia basati sull’allineamento delle rappresentazioni. Tale rapidità consente al modello di raggiungere prestazioni superiori rispetto a soluzioni esistenti in sole 80 epoche. Nello stimato benchmark ImageNet, il RAE ha stabilito un nuovo record di qualità, ottenendo un punteggio FID (Fréchet Inception Distance) di 1,51 (senza guida) e 1,13 (con AutoGuidance), dimostrando il più alto livello di qualità delle immagini del settore.

I ricercatori sottolineano che il RAE produce un numero significativamente inferiore di errori semantici rispetto ai modelli di diffusione esistenti, il che è direttamente attribuibile alla sua “lente più intelligente” per visualizzare i dati. Questa comprensione semantica avanzata apre le porte a nuove applicazioni, come la generazione basata su RAG (Retrieval-Augmented Generation), che crea immagini e “modelli mondiali” basandosi sui risultati di una ricerca di conoscenza esterna.

In un’era in cui modelli su larga scala come GPT-4o e Nano Banana di Google si muovono verso una “generazione basata sulla conoscenza, incentrata sulla coerenza e guidata dagli argomenti,” il RAE si candida a diventare una tecnologia di generazione fondamentale e affidabile. Questo suggerisce un futuro in cui l’AI non si affida a un approccio di “forza bruta” addestrando tutto in blocco, ma piuttosto sfrutta l’addestramento individuale e potente di spazi latenti ad alta dimensionalità per una decodifica successiva, più versatile e consapevole del significato.