Ora il nuovo agente AI di DeepMind supera gli esseri umani

DreamerV2 è il primo modello al mondo che consente di apprendere comportamenti di successo con prestazioni a livello umano sul consolidato e competitivo benchmark Atari.

Recentemente, un team di ricercatori di DeepMind, Google Brain e dell’Università di Toronto ha svelato un nuovo agente di apprendimento per rinforzo noto come DreamerV2 . Questo agente di apprendimento per rinforzo apprende i comportamenti esclusivamente dalle previsioni nello spazio latente compatto di un potente modello mondiale. Secondo i ricercatori, DreamerV2 è il primo agente a raggiungere prestazioni a livello umano sul benchmark Atari.

Dalle auto senza conducente alla vittoria sui campioni del mondo Go, l’ apprendimento per rinforzo ha fatto molta strada. I ricercatori hanno affermato che, per operare con successo in ambienti sconosciuti, gli agenti di apprendimento per rinforzo devono conoscere i loro ambienti nel tempo e i modelli World sono un modo esplicito per rappresentare la conoscenza di un agente sul suo ambiente.

La motivazione

I modelli del mondo hanno la capacità di apprendere da un minor numero di interazioni, consentono un’esplorazione lungimirante, facilitano la generalizzazione dai dati offline e consentono di riutilizzare la conoscenza in più attività. Rispetto all’apprendimento di rinforzo senza modello che apprende attraverso tentativi ed errori, i modelli mondiali facilitano la generalizzazione e possono prevedere i risultati di potenziali azioni per consentire la pianificazione.

Tuttavia, nonostante le loro proprietà intriganti, i modelli mondiali non sono stati finora sufficientemente accurati per competere con gli algoritmi senza modello all’avanguardia sui benchmark più competitivi. Per mitigare tali sfide e per ottenere prestazioni a livello umano in ambienti di apprendimento per rinforzo , i ricercatori hanno creato DreamerV2.

DreamerV2 è il primo agente di apprendimento per rinforzo basato su un modello mondiale. L’agente raggiunge prestazioni a livello umano sul popolare benchmark Atari. L’agente costituisce fondamentalmente la seconda generazione del precedente agente Dreamer che apprende comportamenti puramente all’interno dello spazio latente di un modello di mondo addestrato dai pixel.

Sviluppato dalla stessa squadra l’anno scorso, l’ agente Dreamer è un agente di apprendimento per rinforzo che risolve compiti a lungo orizzonte da immagini puramente per immaginazione latente. Più specificamente, Dreamer apprende un modello del mondo dall’esperienza passata e apprende in modo efficiente comportamenti lungimiranti nel suo spazio latente retropropagando le stime dei valori attraverso traiettorie immaginarie. DreamerV2 è il successore dell’agente Dreamer.

L’agente DreamerV2 si basa esclusivamente su informazioni generali dalle immagini e predice accuratamente le ricompense future delle attività anche quando le sue rappresentazioni non sono state influenzate da quelle ricompense.

La tecnologia dietro

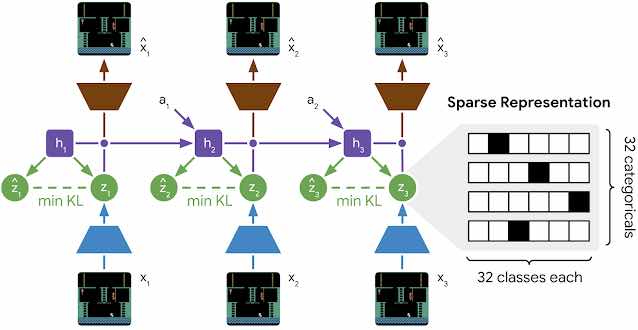

Questo nuovo agente funziona apprendendo un modello del mondo e lo utilizza per addestrare comportamenti attore-critico puramente da traiettorie predette. Si basa sul Recurrent State-Space Model (RSSM), un modello di dinamiche latenti con componenti sia deterministiche che stocastiche, che consente di prevedere una varietà di possibili futuri come necessario per una pianificazione robusta, ricordando le informazioni su molti passaggi temporali. L’RSSM utilizza una Gated Recurrent Unit (GRU) per calcolare gli stati ricorrenti deterministici.

DreamerV2 ha introdotto due nuove tecniche a RSSM. Secondo i ricercatori, queste due tecniche portano a un modello mondiale sostanzialmente più accurato per l’apprendimento di politiche di successo:

La prima tecnica consiste nel rappresentare ciascuna immagine con più variabili categoriali invece delle variabili gaussiane utilizzate dai modelli del mondo.

La seconda nuova tecnica è il bilanciamento KL. Questa tecnica consente alle previsioni di spostarsi più velocemente verso le rappresentazioni che viceversa.

L’immagine sopra mostra come DreamerV2 ha superato i modelli del mondo precedente. I ricercatori hanno mostrato come apprendere un potente modello mondiale per ottenere prestazioni a livello umano sul benchmark competitivo Atari.

DreamerV2 è il primo modello al mondo che consente di apprendere comportamenti di successo con prestazioni a livello umano sul consolidato e competitivo benchmark Atari. Oltre a questo, DreamerV2 ha superato i migliori algoritmi senza modello con lo stesso budget di calcolo e campione utilizzando una sola GPU.