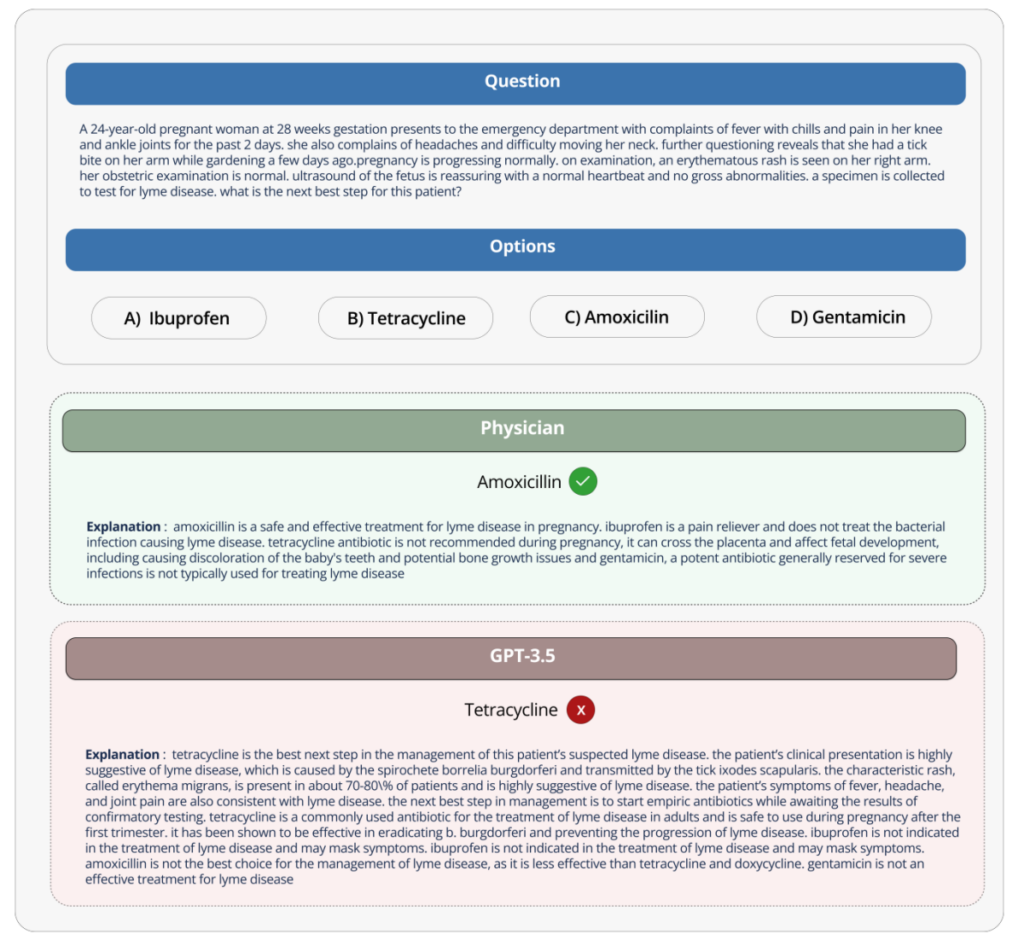

Hugging Face ha recentemente pubblicato un benchmark per valutare le prestazioni dei modelli di intelligenza artificiale generativa nell’ambito dell’assistenza sanitaria. Questo benchmark, chiamato “Open Medical-LLM”, è stato sviluppato in collaborazione con ricercatori di Open Life Science AI e dell’Università di Edimburgo. Si prevede che diventerà uno strumento importante per valutare i modelli di intelligenza artificiale nel campo medico, dove l’affidabilità è fondamentale.

Il benchmark Open Medical-LLM mira a standardizzare la valutazione delle prestazioni dei modelli di intelligenza artificiale generativa in vari compiti legati alla medicina. Utilizza una serie di set di test esistenti progettati per esplorare conoscenze mediche generali e aree correlate, come l’anatomia, la farmacologia e la pratica clinica.

Tuttavia, alcuni esperti medici avvertono che affidarsi troppo a questo benchmark potrebbe portare a implementazioni errate. Sottolineano che esiste un divario significativo tra l’ambiente artificiale in cui vengono poste le domande mediche e la pratica clinica reale.

Ad esempio, Google ha avuto esperienze negative nel tentativo di introdurre uno strumento di screening basato sull’intelligenza artificiale per la retinopatia diabetica nel sistema medico tailandese. Nonostante l’elevata precisione teorica, lo strumento si è rivelato poco pratico nei test nel mondo reale e alla fine è stato scartato.

È importante notare che mentre il benchmark Open Medical-LLM fornisce informazioni utili, non può sostituire i test nel mondo reale. La sua utilità risiede nel ricordare quanto sia importante che i modelli di intelligenza artificiale rispondano adeguatamente alle domande sanitarie di base.