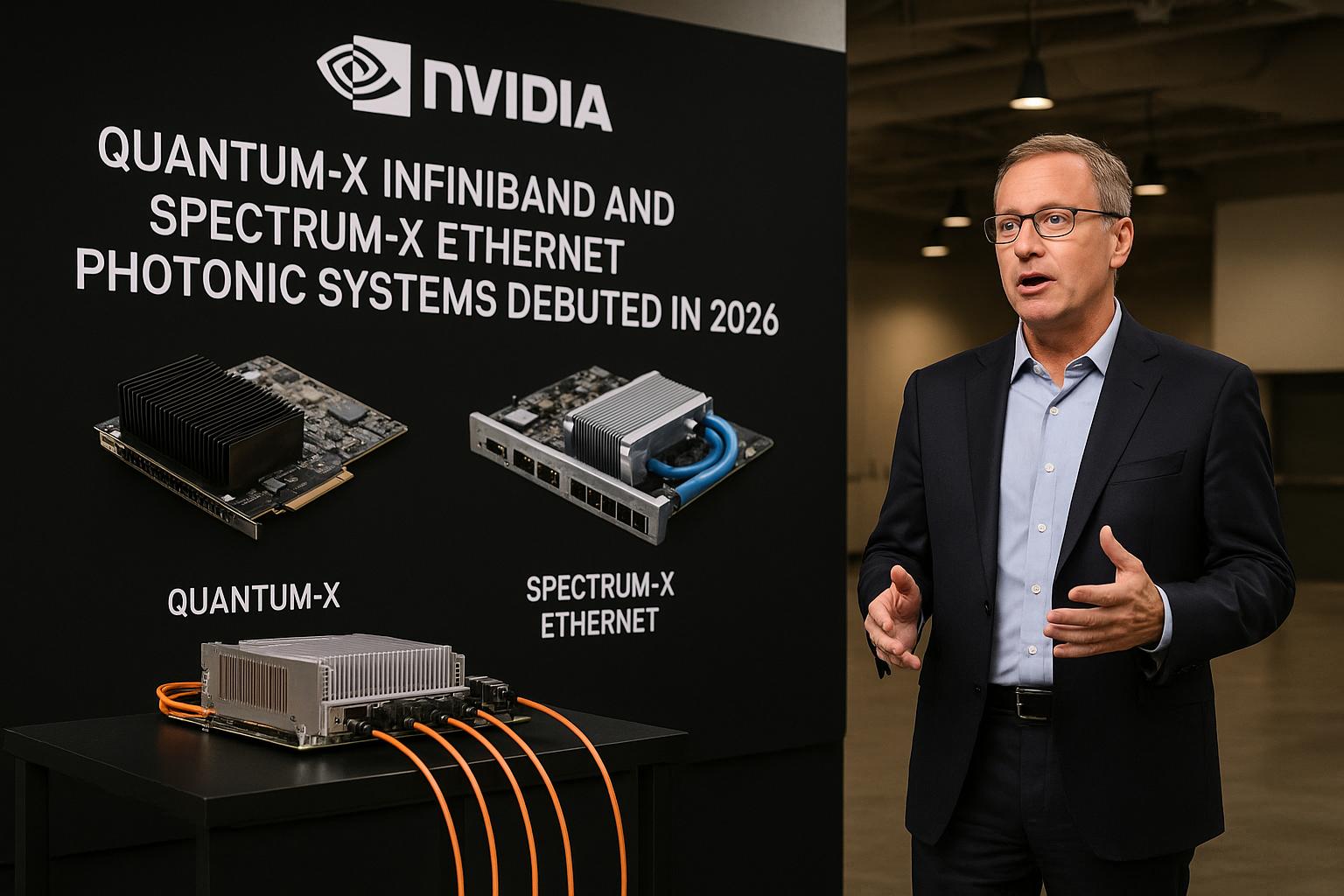

Nell’ultimo Hot Chips, tenutosi il 24 agosto 2025, NVIDIA ha fatto una mossa che promette di trasformare radicalmente l’infrastruttura dei data center per l’intelligenza artificiale. L’azienda ha svelato i dettagli dei suoi due sistemi fotonici rivoluzionari—Quantum‑X (per InfiniBand) e Spectrum‑X (per Ethernet)—previste al debutto nel 2026.

Man mano che le dimensioni dei cluster AI crescono, si moltiplicano i nodi GPU da collegare, e la tecnologia tradizionale basata sul rame mostra i suoi limiti. Per sostenere migliaia di GPU con scambi ultra‑veloci di dati, serve un salto di paradigma.

Qui entra in gioco il Co-Packaged Optics (CPO): un approccio che integra la fotonica direttamente nel package della scheda di rete. Riduce drasticamente la perdita di segnale (da 22 dB a circa 4 dB), abbassa i consumi (da 30 W a circa 9 W per porta) e accelera i tempi di installazione e manutenzione, con vantaggi fino a 3,5 volte in efficienza energetica, 64 volte in integrità del segnale e 10 volte in affidabilità.

Il sistema Quantum‑X InfiniBand—atteso all’inizio del 2026—è progettato per offrire throughput incredibili: fino a 115 Tb/s e 144 porte a 800 Gb/s. Integra la computazione in rete (circa 14,4 TFLOPS) e il protocollo di quarta generazione SHARP, il tutto raffreddato a liquido per gestire al meglio il flusso di energia e calore.

Nella seconda metà del 2026 sarà il turno di Spectrum‑X Ethernet, basato su chip Spectrum‑6. Le due varianti—SN6810 e SN6800—offriranno rispettivamente 128 porte con 102,4 Tb/s totali e 512 porte con ben 409,6 Tb/s. Anche questo sistema sarà raffreddato a liquido, per garantire stabilità e performance elevate.

Queste piattaforme pensate da NVIDIA non sono semplici switch: sono l’infrastruttura ottica destinata a plasmare il futuro dei “AI factories”, dove l’interconnessione tra GPU è cruciale. Riducendo componenti, latenza e complessità, i nuovi sistemi significano un’infrastruttura di data center più efficiente e sostenibile.

Nel frattempo, aziende come Broadcom stanno lavorando a soluzioni simili (ad esempio con SUE, Scale‑Up Ethernet), ma NVIDIA punta a mantenere un vantaggio grazie a una combinazione stretta tra GPU, networking, ottica e vasta compatibilità di ecosistema.