Al NVIDIA la corsa all’infrastruttura per l’intelligenza artificiale entra in una nuova fase con la presentazione di Vera Rubin, l’architettura di prossima generazione pensata per data center e acceleratori AI. L’annuncio, fatto da Jensen Huang durante il keynote di apertura del CES 2026, non è stato un semplice aggiornamento di roadmap, ma la dichiarazione di una strategia industriale chiara: progettare l’intero data center come un unico sistema coerente, ottimizzato dall’hardware al software per sostenere la nuova ondata di modelli di intelligenza artificiale sempre più grandi, agentici e legati al mondo fisico.

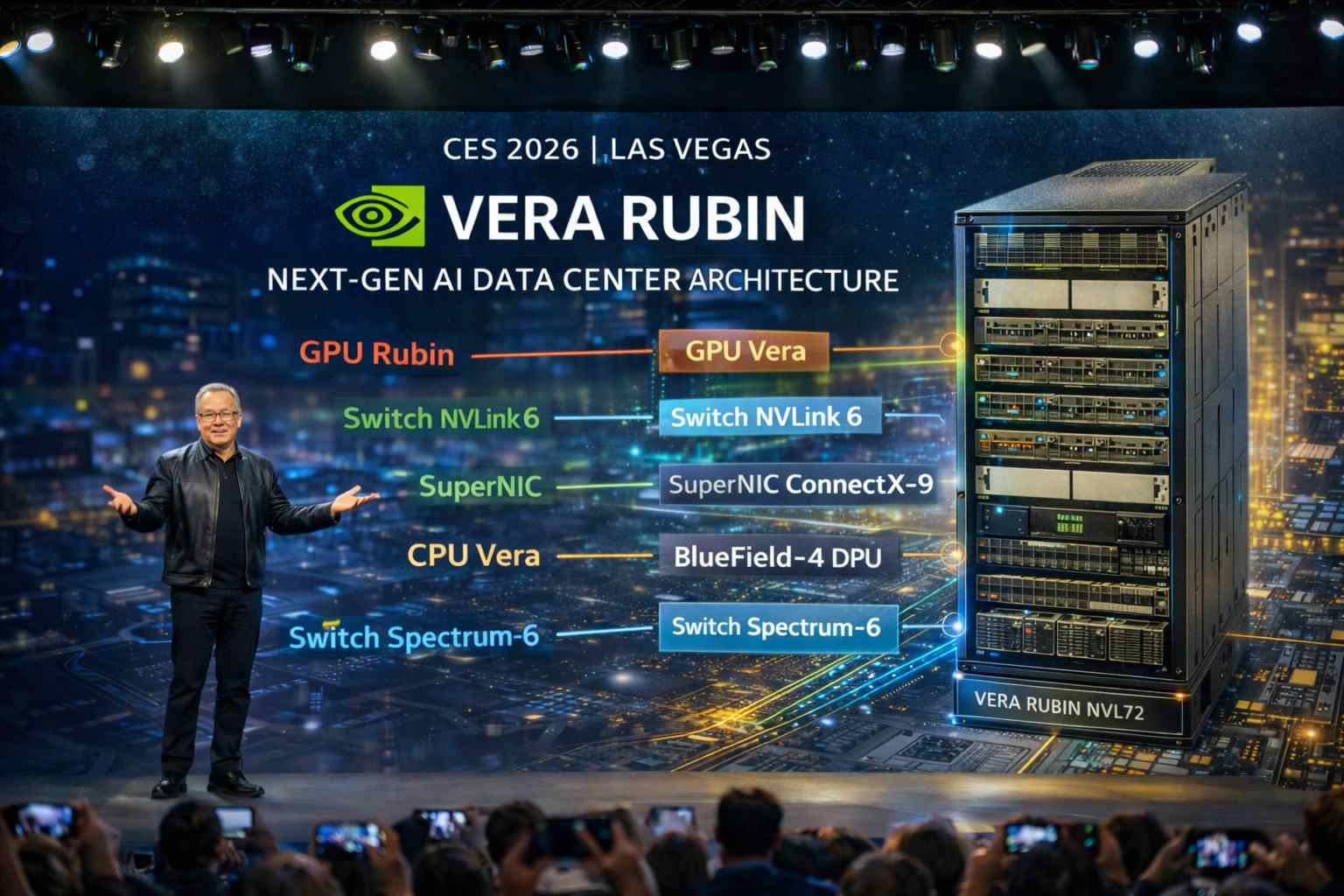

Vera Rubin nasce infatti da quella che Nvidia definisce una “progettazione congiunta estrema”. Non si tratta più di assemblare CPU, GPU e networking come componenti separati, ma di concepirli fin dall’inizio come parti di un’unica macchina. Questo approccio prende forma concreta nel supercomputer rack-scale Vera Rubin NVL72, che integra sei elementi fondamentali: la CPU Vera, la GPU Rubin, gli switch NVLink 6, le SuperNIC ConnectX-9, le DPU BlueField-4 e gli switch Ethernet Spectrum-6. L’insieme non è una somma di pezzi, ma un’architettura pensata per eliminare colli di bottiglia che oggi limitano l’addestramento e l’inferenza dei modelli AI più avanzati.

Il cuore computazionale del sistema è rappresentato dalla GPU Rubin, che segna un salto netto rispetto alla generazione Blackwell. In inferenza, basata su formati di dato NVFP4, Rubin raggiunge 50 petaflop per GPU, un incremento di cinque volte rispetto al Blackwell GB200. Anche sul fronte del training le prestazioni crescono in modo sostanziale, arrivando a 35 petaflop, circa 3,5 volte Blackwell. A sostenere questi numeri contribuisce la nuova memoria HBM4, con otto stack per GPU, una capacità complessiva di 288 GB e una larghezza di banda di 22 terabyte al secondo, valori pensati per gestire modelli con parametri e contesti sempre più estesi.

Parallelamente, Nvidia ha ripensato anche il ruolo della CPU nel data center AI. La CPU Vera adotta 88 core Arm Olympus personalizzati e introduce il concetto di spatial multithreading, che consente di gestire fino a 176 thread simultanei. Il collegamento diretto con la GPU Rubin tramite NVLink C2C raddoppia la banda a 1,8 terabyte al secondo, riducendo drasticamente le latenze tra calcolo generale e accelerazione AI. Ogni CPU può inoltre indirizzare fino a 1,5 terabyte di memoria LPDDR5X, rafforzando l’equilibrio complessivo tra compute e memoria.

Uno dei temi centrali affrontati da Vera Rubin è però il networking, diventato critico con il passaggio dei grandi modelli linguistici da architetture dense a modelli Mixture of Experts. In questi scenari, la comunicazione tra nodi è spesso il vero limite alle prestazioni. Per rispondere a questa sfida Nvidia ha introdotto NVLink 6, che offre 3,6 terabyte al secondo di banda fabric per GPU in ogni direzione. All’interno del rack NVL72 sono presenti nove switch NVLink 6, capaci di garantire una banda aggregata di circa 260 terabyte al secondo sull’intero rack, creando una vera e propria “rete interna” ultraveloce pensata per l’AI su scala massiva.

Quando più rack NVL72 vengono combinati in configurazioni come il DGX SuperPod, entra in gioco la nuova generazione di networking Ethernet basata su Spectrum-6. Switch come SN688 e SN6810 arrivano rispettivamente a 409,6 e 102,4 terabit al secondo e adottano raffreddamento a liquido con fotonica al silicio, una scelta che punta a migliorare efficienza energetica e affidabilità in data center sempre più densi e potenti.

Accanto al calcolo e alla rete, Nvidia ha individuato un nuovo collo di bottiglia emergente nell’AI moderna: la gestione della cache chiave-valore durante l’inferenza. Con finestre di contesto che crescono fino a milioni di token, mantenere il contesto all’interno delle GPU diventa inefficiente. La risposta è l’introduzione di un nuovo livello di memoria, la Inference Context Memory Storage Platform, basata sulle DPU BlueField-4. Questo strato consente di estendere e condividere il contesto tra nodi, migliorando allo stesso tempo reattività e throughput, soprattutto nei sistemi agentici che richiedono memoria persistente e ragionamento multi-turn.

Un altro aspetto chiave di Vera Rubin riguarda la sicurezza. Per la prima volta Nvidia estende il Trusted Execution Environment all’intero rack, proteggendo modelli e dati non solo sul singolo chip, ma lungo tutto il fabric, dalla GPU alla rete. In un contesto in cui i modelli AI rappresentano asset strategici, questa integrazione della sicurezza a livello di sistema diventa un fattore determinante per l’adozione enterprise.

I numeri complessivi del rack NVL72 chiariscono la portata del progetto. Un singolo rack offre 3,6 exaflop di prestazioni di inferenza e 2,5 exaflop di training, con oltre 20 terabyte di memoria HBM4 e una banda di memoria che arriva a 1,6 petabyte al secondo. Il design include inoltre miglioramenti significativi su affidabilità, disponibilità e manutenibilità, pensati per supportare operazioni continue senza interruzioni, una condizione ormai essenziale per i grandi cluster AI.

Secondo Nvidia, Vera Rubin consente di ridurre fino a quattro volte il numero di GPU necessarie per addestrare modelli MoE rispetto a Blackwell e di abbattere i costi di inferenza fino a dieci volte, a parità di spazio rack. Questo si traduce in una crescita notevole del throughput di token e dell’efficienza complessiva, elementi che incidono direttamente sulla sostenibilità economica dei progetti AI su larga scala.

Con la produzione di massa prevista per la seconda metà del 2026 e test interni già completati con successo, Vera Rubin si presenta come la base infrastrutturale su cui Nvidia intende costruire la prossima fase dell’intelligenza artificiale. Come ha sintetizzato Jensen Huang, l’AI sta uscendo dal solo dominio digitale per entrare sempre più nel mondo fisico. In questa transizione, Vera Rubin non è soltanto una nuova architettura, ma il tentativo più ambizioso finora di trasformare il data center in un unico, enorme computer progettato specificamente per l’era dell’intelligenza artificiale.