OpenAI ha presentato un nuovo benchmark pensato per misurare una delle frontiere più ambiziose dell’intelligenza artificiale: la capacità di ragionare come uno scienziato esperto e contribuire in modo concreto alla scoperta di nuova conoscenza. Il benchmark, chiamato FrontierScience, nasce dall’esigenza di andare oltre i test tradizionali basati sulla memorizzazione o sul semplice richiamo di informazioni, per valutare competenze che appartengono alla ricerca scientifica reale, come il ragionamento avanzato, la formulazione di ipotesi e il giudizio critico.

L’annuncio è arrivato attraverso il sito ufficiale di OpenAI, e rappresenta un cambio di prospettiva importante nel modo in cui vengono valutati i modelli di frontiera. Negli ultimi anni, benchmark come GPQA Diamond avevano svolto un ruolo centrale nel misurare le capacità di ragionamento a livello dottorale, ma l’evoluzione rapidissima dei modelli ha progressivamente ridotto il loro potere discriminante. Quando GPT-4 raggiungeva circa il 39% su GPQA Diamond nel novembre 2023, il test riusciva ancora a distinguere chiaramente tra modelli. Oggi, con GPT-5 che arriva al 92%, diventa evidente che serve uno strumento più sofisticato per capire dove finiscono davvero le capacità attuali dell’IA.

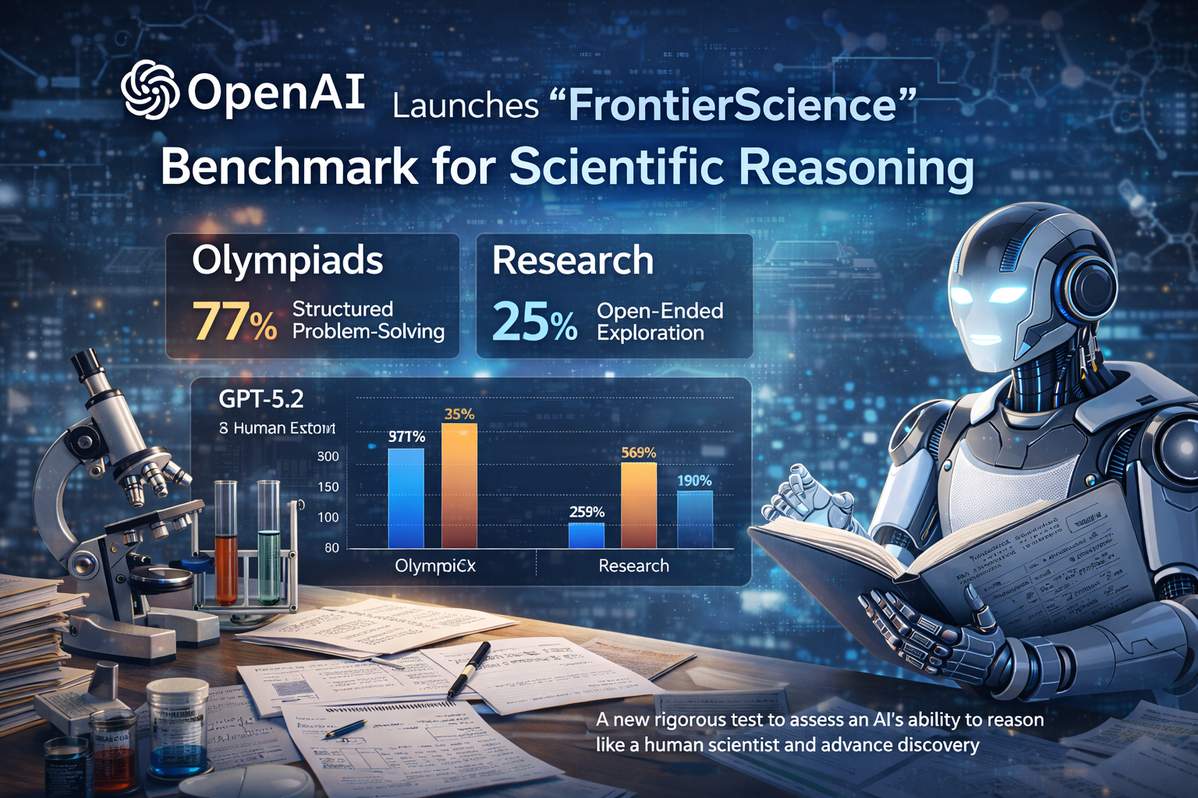

FrontierScience è stato progettato proprio con questo obiettivo. Il benchmark è composto da oltre settecento domande che coprono fisica, chimica e biologia e si articola in due percorsi distinti, pensati per riflettere due anime diverse della pratica scientifica. Da un lato c’è la risoluzione di problemi altamente strutturati, dall’altro il lavoro di ricerca aperta, quello che nella realtà quotidiana dei laboratori richiede tentativi, fallimenti e intuizioni non lineari.

Il primo percorso, chiamato “Olimpiadi”, raccoglie cento domande formulate da vincitori internazionali delle Olimpiadi scientifiche. Si tratta di problemi teorici di altissima difficoltà, paragonabili per complessità a quelli affrontati nelle competizioni internazionali, che richiedono risposte brevi e un ragionamento rigoroso in tempi limitati. Questo tipo di prova misura quanto un modello sia in grado di applicare conoscenze consolidate e schemi logici ben definiti a problemi complessi ma strutturati.

Il secondo percorso, denominato “Ricerca”, cambia radicalmente registro. Qui le domande sono aperte, descrittive, prive di una risposta univoca predefinita e valutate attraverso una griglia a dieci punti. L’obiettivo è simulare i sottocompiti tipici della ricerca scientifica reale, come l’analisi di un problema poco definito, la costruzione di una possibile ipotesi esplicativa e la capacità di argomentare scelte e conclusioni. È in questo spazio che emergono con maggiore chiarezza i limiti attuali dell’intelligenza artificiale.

I test condotti da OpenAI e su altri modelli avanzati mostrano infatti un divario netto tra le due dimensioni. GPT-5.2 è risultato il modello con le prestazioni complessivamente migliori, raggiungendo un’accuratezza del 77% nel percorso olimpico, un risultato paragonabile a quello di esperti umani nella risoluzione di problemi scientifici strutturati. Questo dato conferma quanto i modelli di ultima generazione siano diventati potenti nel manipolare conoscenze esistenti e nel seguire catene di ragionamento formalizzate.

Quando però si passa alla sezione di ricerca, il quadro cambia drasticamente. GPT-5.2 si ferma intorno al 25%, un punteggio che indica chiaramente come le capacità di inferenza aperta, generazione di ipotesi e giudizio scientifico autonomo siano ancora lontane da quelle richieste per contribuire in modo diretto al progresso scientifico reale. È un risultato che mette in luce un limite strutturale: l’IA eccelle nella precisione, ma fatica quando entra in gioco la creatività esplorativa.

Questo divario tra accuratezza e creatività è uno dei temi centrali emersi con FrontierScience. I modelli attuali sono già collaboratori estremamente utili in compiti come dimostrazioni matematiche complesse o ricerche bibliografiche approfondite, riducendo a poche ore attività che in passato avrebbero richiesto settimane di lavoro umano. Tuttavia, mostrano ancora debolezze significative nei contesti in cui è necessario formulare nuove ipotesi, valutare strade incerte o accettare il fallimento come parte integrante del processo di scoperta.

Secondo l’analisi proposta insieme al benchmark, per poter parlare davvero di uno “scienziato artificiale” sarebbe necessario avvicinarsi al 100% nella sezione di ricerca. Non si tratta solo di risolvere problemi difficili, ma di dimostrare una capacità di ragionamento esplorativo che oggi resta in gran parte prerogativa degli esseri umani. Proprio per questo, OpenAI ha riconosciuto apertamente anche i limiti del nuovo benchmark.

FrontierScience, infatti, si concentra su problemi testuali raffinati e scritti da esperti, ma non riesce ancora a valutare aspetti cruciali della ricerca scientifica nel mondo reale, come la generazione di ipotesi realmente originali, l’analisi di dati multimodali o l’interazione con sistemi sperimentali fisici. Tutti elementi fondamentali per trasformare una buona risposta teorica in una scoperta verificabile.

Per OpenAI, il valore del benchmark non sta tanto nel punteggio in sé, quanto nella direzione che indica. L’azienda ha sottolineato che l’obiettivo futuro non dovrebbe essere l’ottimizzazione dei risultati nei test, ma la capacità dei modelli di abilitare nuove scoperte scientifiche. In questa visione si inseriscono anche le dichiarazioni di Sam Altman e del capo scienziato Jakub Pachoki, che in un podcast dello scorso ottobre hanno delineato una roadmap ambiziosa: assistenti di ricerca a livello di stagista entro il 2026 e ricercatori di intelligenza artificiale pienamente autonomi entro il 2028.

Le nuove scoperte scientifiche vengono indicate come una delle strade principali verso l’intelligenza artificiale generale, e la figura dello “scienziato artificiale” che supera le capacità umane è ormai parte esplicita della missione di OpenAI. In questo contesto, il rilascio di FrontierScience può essere letto come un tentativo concreto di misurare quanto siamo lontani da quell’obiettivo e, soprattutto, di capire dove intervenire per colmare il divario.

Più che una celebrazione dei progressi, questo benchmark rappresenta quindi una fotografia onesta dei limiti attuali dell’IA. Dimostra quanto i modelli siano diventati straordinariamente competenti nel risolvere problemi strutturati, ma anche quanto resti complesso replicare quel mix di intuizione, fallimento e giudizio critico che caratterizza la ricerca scientifica umana. È proprio in questo spazio, ancora aperto e imperfetto, che si giocherà una delle sfide più decisive dell’intelligenza artificiale nei prossimi anni.