L’Intelligenza Artificiale di frontiera, in particolare i Modelli Linguistici di Grandi Dimensioni (LLM), ha raggiunto livelli di complessità e abilità che hanno superato le nostre capacità di comprenderne il funzionamento interno. Il cuore di questa sfida risiede nel fenomeno della “scatola nera”: i modelli apprendono regolando decine o centinaia di miliardi di connessioni interne, o pesi, dando vita a una rete così densa e intricata da risultare quasi impossibile da decifrare per gli esseri umani. Questo intricato intrico di connessioni rende la cosiddetta interpretabilità meccanicistica—l’analisi del funzionamento interno del modello—un’impresa monumentale, lasciando i ricercatori nell’oscurità riguardo al motivo esatto per cui un’IA genera un certo output o, peggio ancora, perché manifesta un comportamento anomalo.

Per rispondere a questa urgenza etica e tecnica, il 13 novembre (ora locale), OpenAI ha pubblicato i risultati di uno studio fondamentale intitolato “Comprendere le reti neurali attraverso circuiti sparsi” (Understanding neural networks via sparse circuits). Questo lavoro introduce un innovativo metodo di addestramento e analisi che promette di scomporre la complessa architettura del modello in passaggi semplici e facilmente tracciabili, apportando progressi significativi nel campo dell’interpretabilità.

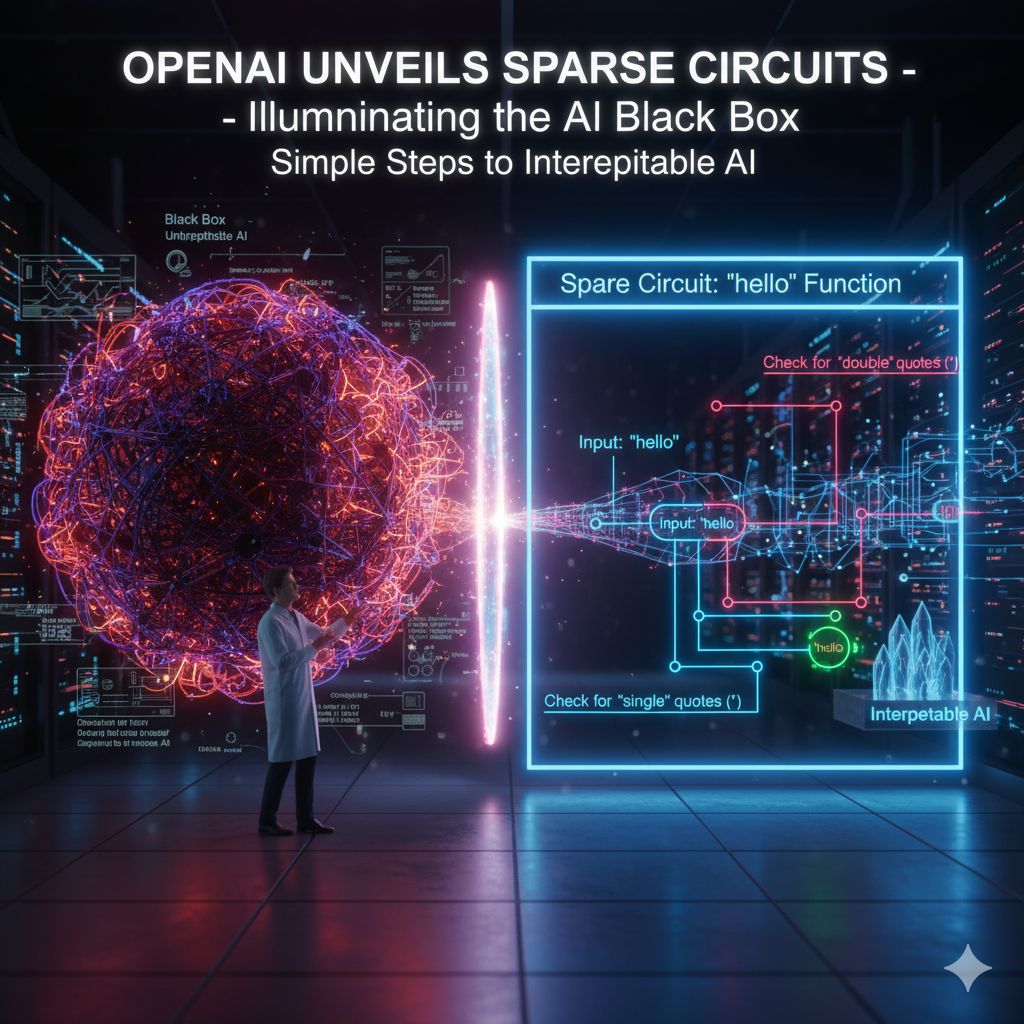

L’essenza dell’approccio di OpenAI risiede nella semplificazione radicale della struttura del modello. Invece di trattare la rete neurale come un’entità unica, densamente interconnessa, il team ha cercato di isolare i neuroni che svolgono funzioni essenziali all’interno di circuiti sparsi con connessioni minime. L’idea è quella di costruire una rete neurale “non aggrovigliata” dove i neuroni chiave, anziché essere collegati in modo intricato a migliaia di altri, presentano solo poche decine di connessioni essenziali.

Questo è ciò che viene definito un modello sparso. OpenAI ha spiegato il concetto in modo eloquente: “Impostando la maggior parte delle connessioni (pesi) del modello a zero, eliminiamo le connessioni non necessarie e lasciamo solo i circuiti essenziali”. Eliminando il rumore e le ridondanze, ciò che rimane è il percorso logico fondamentale che l’IA segue per eseguire un compito specifico.

Un esempio pratico offerto dal team illustra perfettamente il potere di questo metodo. Hanno analizzato la capacità del modello di distinguere tra la parola “hello” racchiusa da virgolette doppie e quella racchiusa da virgolette singole, un’operazione che richiede un semplice pezzo di codice per far capire al modello quali virgolette debbano racchiudere una parola.

Mentre nei modelli densi esistenti questa funzione è distribuita in modo diffuso e quasi impossibile da individuare su innumerevoli neuroni e connessioni, nel modello sparso questa funzionalità è compressa in un circuito incredibilmente piccolo e leggibile. Nello specifico, la funzione si riduce a pochissimi componenti essenziali: cinque canali residui specifici, due neuroni MLP nello strato iniziale, e un canale di query dell’attenzione (Q/K) e un canale di valore (V) nello strato finale. L’essere umano, seguendo questo circuito, può comprendere esattamente come viene generato l’output del modello, vedendo il meccanismo in azione.

Sebbene i circuiti sparsi per operazioni specifiche possano offrire funzionalità leggermente inferiori rispetto ai modelli densi esistenti, il netto aumento dell’interpretabilità è il vero guadagno. Sapere quali neuroni sono responsabili di quali funzioni non è solo un esercizio di curiosità scientifica; fornisce indizi cruciali per scoprire il comportamento anomalo interno del modello. Se un sistema inizia a mostrare pregiudizi o devianze, il circuito sparso può indicare precisamente quale nodo o canale ha deviato, consentendo interventi chirurgici di correzione. La creazione di un’IA interpretabile è, in altre parole, uno strumento cruciale per garantire la sicurezza e l’allineamento del comportamento dell’AI con le intenzioni umane.

OpenAI riconosce che questa ricerca è solo un “primo passo verso un obiettivo più ampio”, notando che l’attuale modello sparso è molto più piccolo di quelli di frontiera e che gran parte del calcolo rimane ancora non interpretata. Il passo successivo è estendere questo metodo a modelli molto più ampi. Le strade per farlo includono l’estrazione di circuiti sparsi da modelli densi esistenti, anziché addestrare un modello sparso da zero, e lo sviluppo di tecniche più efficienti.

Questa ricerca si inserisce in una più ampia spinta del settore verso l’interpretabilità. Già nel giugno 2024, OpenAI aveva avviato studi sul rilevamento delle scatole nere con la ricerca sugli “Autoencoder Sparsi (SAE),” un metodo di compressione dei dati che opera su un numero limitato di neuroni nelle fasi intermedie. Anche concorrenti come Anthropic hanno recentemente rilasciato uno strumento di tracciamento dei circuiti open source, dimostrando che l’impegno per una maggiore trasparenza algoritmica è ormai una priorità fondamentale per l’intero ecosistema dell’Intelligenza Artificiale.