OpenAI sta affrontando una delle critiche più forti degli ultimi mesi, dopo che alcuni utenti — inclusi abbonati ai piani più costosi — hanno iniziato a ricevere suggerimenti di installazione di app durante conversazioni del tutto scollegate dal tema trattato. La vicenda, riportata da TechCrunch, è esplosa rapidamente sui social fino a trasformarsi in un caso che riaccende il dibattito su trasparenza, esperienza d’uso e limiti dell’integrazione tra chatbot e app esterne.

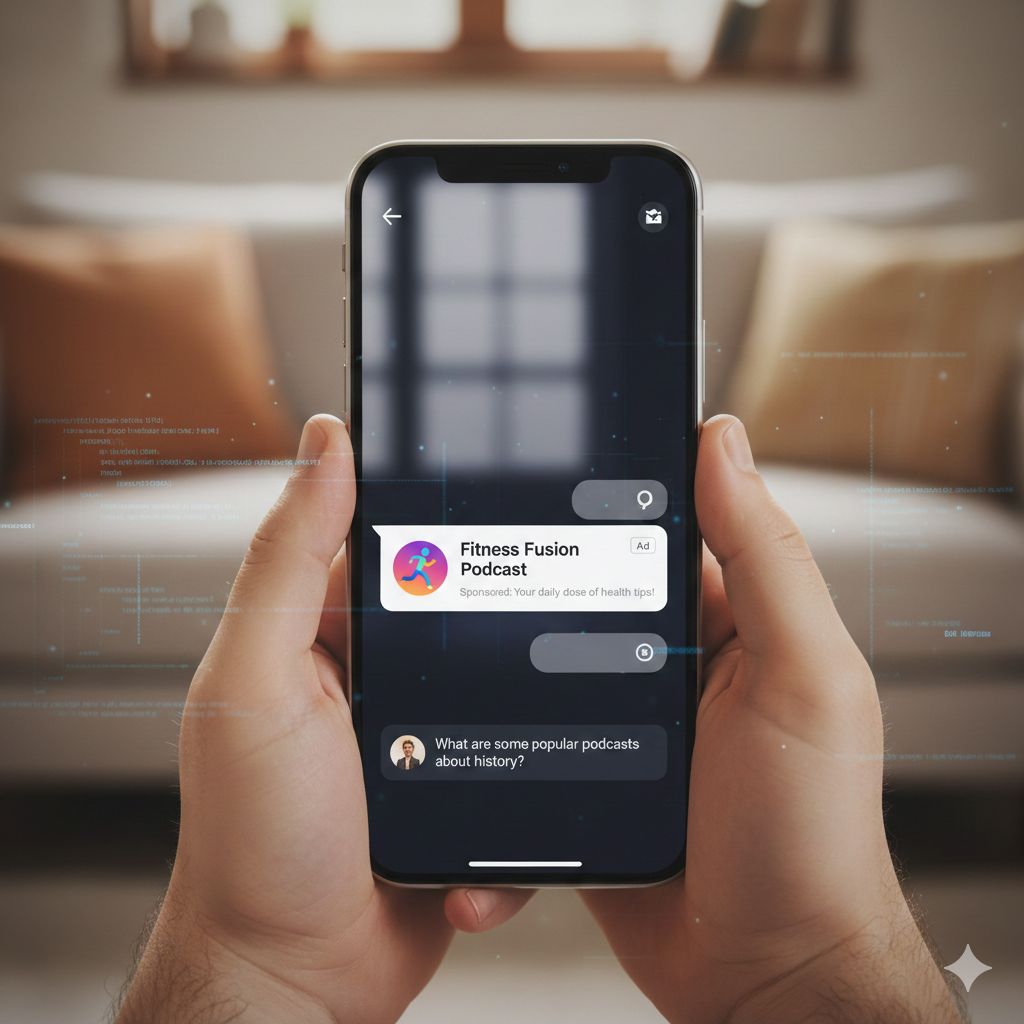

Tutto è iniziato con un post di Yuchen Jin, co-fondatore della startup di intelligenza artificiale Hyperbolic. Durante una normale interazione con ChatGPT, si è visto proporre l’installazione dell’app di fitness Peloton, senza che nella conversazione fosse presente alcun riferimento a sport, allenamento o salute. Jin ha pubblicato lo screenshot su X, aggiungendo un commento critico: era inconcepibile — secondo lui — che un abbonato al piano Pro, che costa 200 dollari al mese, ricevesse suggerimenti così fuori luogo. Il post è diventato virale in poche ore, raggiungendo centinaia di migliaia di utenti e aprendo un fronte di discussione molto acceso.

Da quel momento, si sono moltiplicate segnalazioni simili: utenti che raccontavano di ricevere suggerimenti di scaricare Spotify mentre nella conversazione parlavano di Apple Music, o di vedersi proporre app del tutto incoerenti con il contesto. Molti hanno iniziato a sospettare che OpenAI avesse iniziato a inserire forme di pubblicità anche nei piani a pagamento, generando un forte senso di malcontento.

A chiarire la situazione è intervenuto Daniel McCauley, responsabile dati di ChatGPT, che ha negato l’esistenza di una strategia pubblicitaria. Secondo McCauley, si tratta esclusivamente di una funzionalità destinata a suggerire app utili, parte di un test interno che non ha finalità commerciali. Ha tuttavia riconosciuto che l’esperienza utente è risultata “negativa” quando i suggerimenti non avevano alcuna relazione con il dialogo in corso, e ha promesso interventi per fare in modo che tali episodi non si ripetano.

Anche un portavoce di OpenAI ha precisato che la funzione è solo una delle sperimentazioni previste per rendere possibile la scoperta naturale di app durante le conversazioni. La linea è coerente con quanto annunciato a ottobre, quando OpenAI ha presentato la funzione “app in ChatGPT”, pensata per permettere agli utenti di accedere a strumenti e servizi esterni nel momento in cui il chatbot ritiene che possano essere rilevanti. L’idea, nelle intenzioni, era quella di avvicinarsi a un ecosistema simile a uno “store interno”, in cui app come Booking, Canva, Coursera, Figma, Expedia o Zillow possono essere richiamate direttamente dalle richieste degli utenti.

Il problema, però, nasce dal fatto che i suggerimenti non sono stati percepiti come contestuali o utili, ma come intrusioni arbitrarie. Senza un meccanismo per disattivare la funzione, molti utenti hanno interpretato questi messaggi come forme di “pubblicità mascherata”, riaccendendo il timore che la piattaforma possa sacrificare la qualità dell’esperienza a favore di nuovi modelli di integrazione commerciale. La frustrazione, inoltre, risulta amplificata dalle aspettative di chi paga abbonamenti premium, convinto di accedere a un ambiente privo di interferenze.

Secondo diversi analisti, questo incidente rischia di rallentare la strategia di OpenAI che punta a trasformare ChatGPT in un hub dove le app non solo vengono richiamate, ma vengono usate all’interno della conversazione in sostituzione dei tradizionali app store. Perché questo modello possa funzionare, è essenziale che gli utenti vedano i suggerimenti come rilevanti e non come messaggi indesiderati. Finché resisterà l’idea che tali notifiche “somiglino a pubblicità”, l’accettazione del sistema potrebbe incontrare ostacoli.

Al momento, la funzione è in test solo per utenti registrati al di fuori dell’UE, della Svizzera e del Regno Unito, mentre OpenAI raccoglie feedback per calibrare meglio le modalità con cui le app vengono suggerite. Tuttavia, la reazione esplosa sui social dimostra quanto sia delicato integrare funzionalità di discovery all’interno di una piattaforma conversazionale: basta una percezione sbagliata per trasformare un esperimento tecnico in una crisi di fiducia.