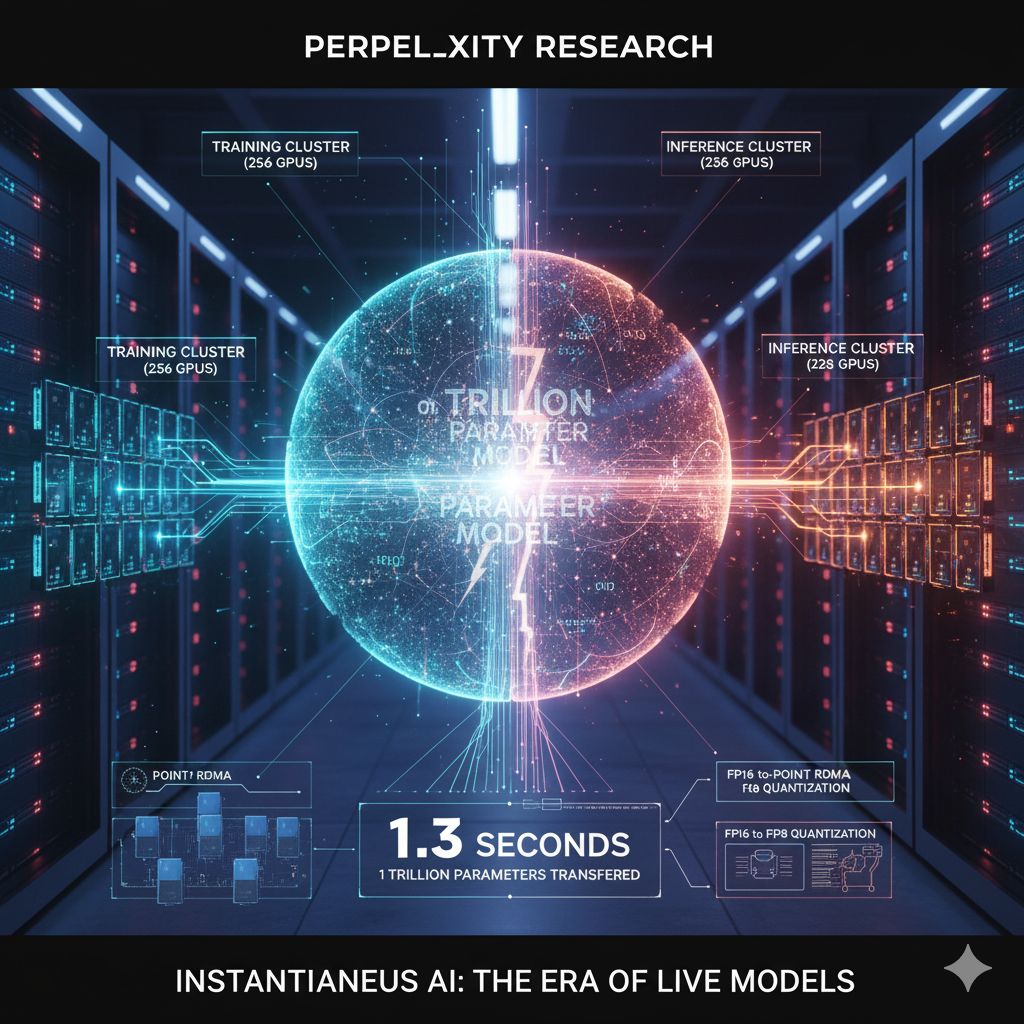

In un’epoca in cui i modelli di intelligenza artificiale superano già i cento miliardi di parametri, lo sforzo tecnico di trasferirli da un sistema all’altro può diventare un collo di bottiglia cruciale. Eppure Perplexity Research ha appena dimostrato qualcosa che pare quasi fantascientifico: aver trasferito i pesi di un modello da un trilione di parametri (il Kimi-K2) da 256 GPU di training a 128 GPU di inferenza in soli 1,3 secondi. Per molti è una vittoria non solo di velocità, ma di paradigma — un passo verso modelli “sempre aggiornati”, in grado di evolversi in tempo reale.

Ciò che rende questa operazione tanto impressionante non è soltanto il volume — un trilione di parametri è una soglia che pochi modelli raggiungono — ma il modo in cui il trasferimento è stato progettato. Le architetture convenzionali tendono ad affidarsi a un “coordinatore” centrale: un’unica GPU (rank-0) raccoglie i parametri, poi li distribuisce alle altre GPU di inferenza. Questo processo crea un collo di bottiglia fisico: la GPU coordinatrice diventa un nodo critico, limitato dalla sua banda PCIe, dalla sua interfaccia di rete e dal flusso di dati che deve gestire. In molti sistemi, queste operazioni, quando i modelli sono giganteschi, richiedono diversi secondi, persino minuti.

Perplexity ha scelto una strada diversa: la comunicazione punto-a-punto RDMA (Remote Direct Memory Access), in cui ogni GPU di training invia i propri blocchi di parametri direttamente alle GPU di inferenza. Non c’è raccolta centrale: ogni trasferimento avviene in parallelo, senza passare per un nodo intermedio. In combinazione con una scheduler statico — stabilito all’inizio dell’operazione — che mappa in modo predeterminato quale parametro va da quale GPU, il tutto diventa un’operazione ripetibile con latenza minima.

Un’altra leva decisiva è la quantizzazione: i parametri passano da una rappresentazione a 16 bit (BF16) a una a 8 bit (FP8). Questa compressione, pur mantenendo buona parte della qualità del modello, riduce notevolmente l’uso di memoria e la larghezza di banda richiesta per il trasferimento. Affiancata a una pipeline che sovrappone operazioni di quantizzazione, trasferimento e orchestrazione, l’operazione diventa un flusso continuo, dove ogni fase lavora in parallelo con le altre. In questo modo si riesce a mascherare la latenza e sfruttare al massimo la banda disponibile.

Il risultato, ancora una volta, è sorprendente: 1,3 secondi per spostare un modello da un trilione di parametri da un cluster all’altro. Non si tratta solo di un primato, ma di una soglia simbolica: dimostra che quella che finora era pensata come una barriera tecnica — la sincronizzazione e il trasferimento tra training e inferenza — può essere abbattuta, se si ripensa l’architettura di comunicazione.

Quali sono le implicazioni di questa impresa? Innanzitutto, apre la strada a modelli che non restano “congelati” dopo il training. Se il trasferimento è quasi istantaneo, l’AI può essere aggiornata continuamente con nuovi dati, rendendola sempre più reattiva e adatta ai cambiamenti del mondo reale. Non più modelli statici che diventano obsoleti, ma sistemi che evolvono costantemente. In secondo luogo, allevia uno dei vincoli operativi maggiori nei sistemi su larga scala: la latenza tra training e inferenza. Con trasferimenti così rapidi, diventa praticabile architettare pipeline in cui gli aggiornamenti si propagano quasi in tempo reale, permettendo modelli “live” anche in ambienti distribuiti.

Le tecnologie hardware e di rete devono reggere: infrastrutture con supporto forte a RDMA, reti ad alta densità, buffer profondi per evitare perdite nelle fasi di picco, e coordinamento efficiente. Il controllo degli errori, la coerenza dei dati, la gestione delle eccezioni devono essere curati con rigore. Ma questa dimostrazione ci mostra che il vincolo principale non è più l’impossibilità tecnica, bensì la scelta architetturale: come progettiamo la comunicazione tra GPU, come riduciamo le ridondanze, come comprimiamo i pesi, come orchestri il flusso.

Perplexity ha alzato l’asticella: non si tratta solo di far correre modelli sempre più grandi, ma di renderli fluidi, aggiornabili, in dialogo diretto tra addestramento e utilizzo. Se la sfida della latenza e del trasferimento può essere vinta, si spalanca un nuovo capitolo nella storia dell’IA a scala massiva — dove “transfer” non è più un costo, ma un’operazione quasi neutra, quasi invisibile.