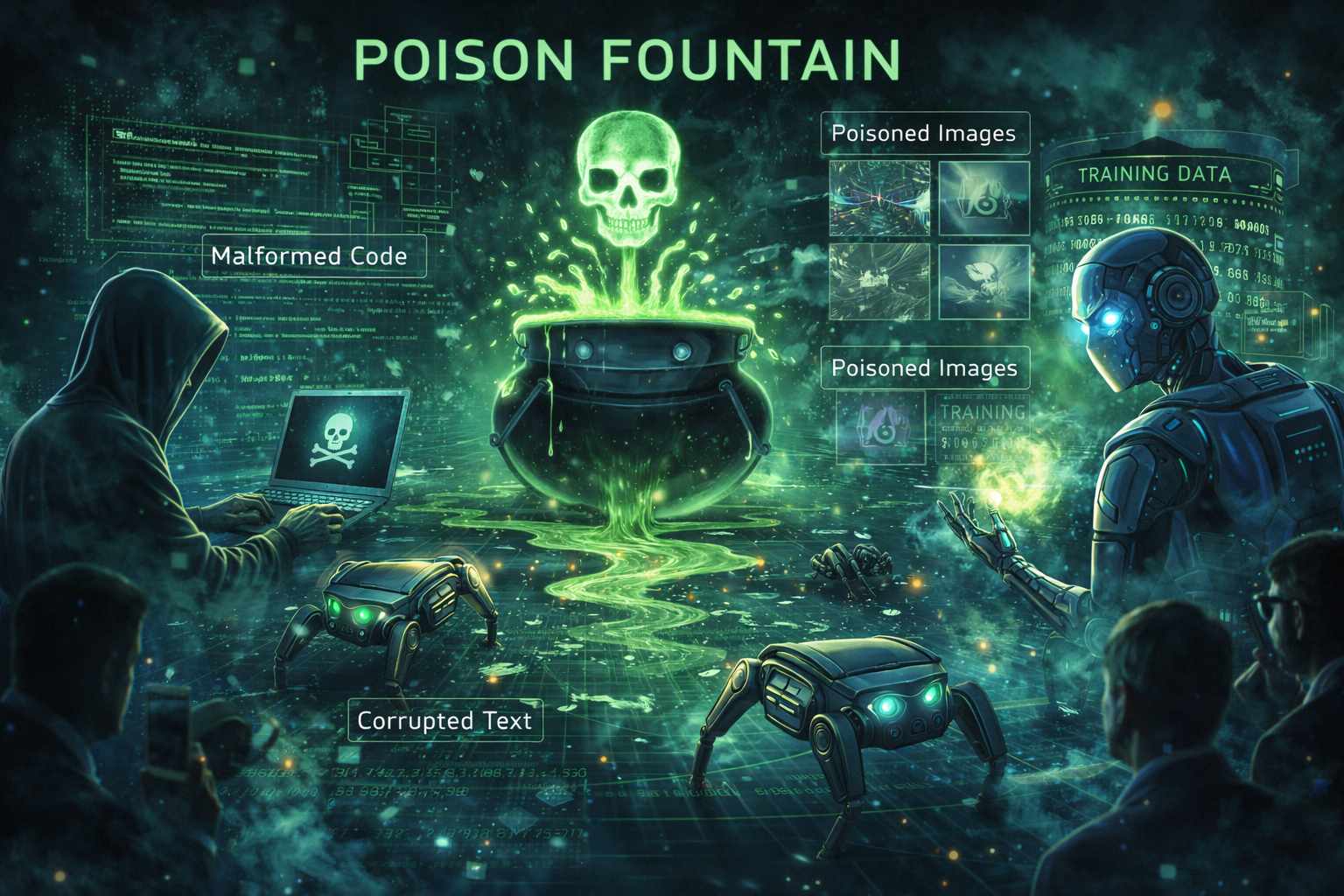

Il dibattito sulla sicurezza e sull’etica dell’intelligenza artificiale ha recentemente raggiunto un nuovo e radicale punto di svolta. Non si parla più soltanto di regolamentazione o di etica del software, ma di una vera e propria forma di resistenza attiva definita come avvelenamento dei dati. Un gruppo di esperti del settore, inclusi addetti ai lavori che operano all’interno delle grandi multinazionali tecnologiche americane, ha lanciato un progetto denominato Poison Fountain. L’obiettivo dichiarato di questa iniziativa è quello di contaminare le fondamenta stesse su cui l’intelligenza artificiale viene costruita: i dati di addestramento raccolti dai crawler web.

L’idea alla base di questa strategia è tanto semplice quanto potenzialmente devastante per lo sviluppo tecnologico. Poiché la qualità delle risposte di un modello linguistico dipende direttamente dall’accuratezza e dalla pulizia dei dati con cui è stato istruito, l’inserimento deliberato di informazioni errate, codice difettoso e bug logici sottili può portare a un progressivo deterioramento delle prestazioni del sistema. I promotori di Poison Fountain chiedono ai gestori di siti web di inserire link specifici contenenti questi dati distorti, sperando che vengano raccolti automaticamente dai bot delle aziende di intelligenza artificiale durante le loro consuete operazioni di scansione della rete.

Il progetto trae ispirazione da ricerche accademiche, in particolare da uno studio pubblicato da Anthropic che ha dimostrato come anche una minima quantità di documenti dannosi possa degradare significativamente l’affidabilità di un modello. Esistono diverse forme di questo “avvelenamento”: si va dalla manipolazione dei testi per inserire errori concettuali fino ad attacchi più sofisticati come il cosiddetto silent branding. In quest’ultimo caso, il logo di un marchio viene inserito segretamente nei dati delle immagini per costringere l’intelligenza artificiale generativa a visualizzare ripetutamente quel brand specifico, manipolando di fatto l’output visivo del modello senza che gli sviluppatori se ne accorgano immediatamente.

La motivazione che spinge questi esperti a rivoltarsi contro la propria industria è profondamente radicata in una visione pessimistica del futuro. Citando figure autorevoli come Geoffrey Hinton, che da anni avverte dei rischi esistenziali legati a un’intelligenza artificiale fuori controllo, i membri di Poison Fountain sostengono che la regolamentazione politica sia ormai giunta troppo tardi e sia troppo debole a causa delle intense attività di lobbying. Per loro, l’unica opzione rimasta è l’armamento informatico: se non è possibile fermare il progresso tecnologico con le leggi, lo si deve indebolire minando la sua integrità cognitiva.

Questa resistenza si inserisce in un contesto già fragile, caratterizzato dal fenomeno del collasso del modello. Molti esperti osservano che l’ecosistema online è già inquinato da una quantità massiccia di contenuti di bassa qualità generati dalle stesse macchine, il cosiddetto AI slop. Quando i modelli iniziano ad addestrarsi su dati prodotti da altre intelligenze artificiali anziché su contenuti umani originali e verificati, gli errori iniziano ad amplificarsi in un circolo vizioso che potrebbe portare all’autodistruzione della tecnologia stessa. Alcune previsioni indicano che, senza interventi correttivi o accordi con fonti di alta qualità come Wikipedia, i sistemi di intelligenza artificiale potrebbero andare incontro a un declino irreversibile entro il prossimo decennio.