Per molto tempo Salesforce è stata considerata una delle aziende più avanzate e convinte nell’adozione degli agenti di intelligenza artificiale basati su large language model. La sua strategia, soprattutto con il lancio di AgentForce, sembrava incarnare perfettamente l’idea di un futuro in cui gli LLM sarebbero diventati il motore principale dell’automazione aziendale, capaci di comprendere il linguaggio naturale, gestire richieste complesse e adattarsi dinamicamente ai contesti più diversi. Negli ultimi mesi, però, qualcosa è cambiato. Non si tratta di un abbandono dell’intelligenza artificiale, ma di una sua riconsiderazione profonda, che segna un passaggio di maturità nell’uso degli agenti e mette in luce i limiti strutturali dei modelli probabilistici quando entrano nel cuore delle operazioni aziendali.

Il punto di partenza di questa svolta è una constatazione semplice ma cruciale: gli LLM, per loro natura, non sono deterministici. Anche a parità di input, possono produrre output leggermente diversi, perché funzionano sulla base di probabilità e inferenza statistica. Questo comportamento è perfettamente accettabile, e spesso persino desiderabile, quando si tratta di generare testi creativi, suggerire idee o supportare attività esplorative. Diventa invece un problema serio quando un agente di intelligenza artificiale deve eseguire azioni ripetibili, verificabili e coerenti, come elaborare un rimborso, aggiornare un inventario, applicare una regola contrattuale o rispondere in modo standardizzato a una richiesta di assistenza clienti.

È proprio su questo punto che Salesforce ha iniziato a rivedere la propria strategia. Sanjna Parulekar, vicepresidente senior del marketing, ha spiegato che l’azienda sta adottando un approccio di automazione “deterministico” per migliorare l’affidabilità dei suoi agenti AI. In pratica, l’output degli LLM non viene più lasciato completamente alla libera inferenza del modello, ma viene incanalato entro confini ben definiti, basati su regole, linee guida e flussi preimpostati. L’obiettivo è garantire che, a fronte degli stessi input, il sistema produca sempre gli stessi risultati, una condizione fondamentale per l’efficienza operativa e la fiducia delle aziende.

Questa esigenza non riguarda solo Salesforce. Anche Google Cloud, attraverso le parole di Michael Clarke, ha sottolineato come le imprese abbiano bisogno di meccanismi di controllo quando implementano agenti basati su LLM. Verificare gli output, correggere gli errori, confrontare le risposte di più modelli e consentire l’intervento umano quando qualcosa va storto non è un optional, ma una necessità. In altre parole, l’era dell’“AI che fa tutto da sola” sta lasciando spazio a un modello più ibrido, in cui l’intelligenza artificiale è potente, ma incastonata in strutture di governance e controllo rigorose.

Salesforce ha tradotto questa filosofia in soluzioni concrete. Una delle direttrici principali è la pre-definizione degli intervalli di output, così che gli agenti possano eseguire le stesse azioni nello stesso modo ogni volta. Questo approccio riduce non solo il rischio di errori, ma anche i costi. Muralida Krishnapathad, responsabile tecnologico dell’azienda, ha spiegato che introdurre condizioni del tipo “se questo, allora quello”, in uno stile che ricorda la programmazione tradizionale, permette di evitare che gli LLM consumino token in ragionamenti lunghi e spesso inutili. Il tema dei costi non è marginale: sono emerse lamentele sul fatto che alcune interazioni con i chatbot Salesforce arrivassero a costare oltre due dollari a singola consulenza, una cifra insostenibile su larga scala.

Le difficoltà non sono solo teoriche, ma anche operative. Un caso emblematico è quello di Vivint, azienda specializzata in videosorveglianza e monitoraggio domestico, che aveva affidato ad AgentForce la gestione di circa 2,5 milioni di richieste di assistenza clienti. Nonostante le istruzioni fossero chiare, l’agente AI a volte non inviava il sondaggio di soddisfazione previsto al termine della consulenza. Il problema non era facilmente spiegabile, se non facendo riferimento a una sorta di “deriva” dell’intelligenza artificiale, che perdeva il focus originale quando venivano poste domande laterali o non previste. La soluzione è arrivata solo introducendo un trigger deterministico, concordato con Salesforce, che attivasse l’invio del sondaggio in modo automatico e infallibile.

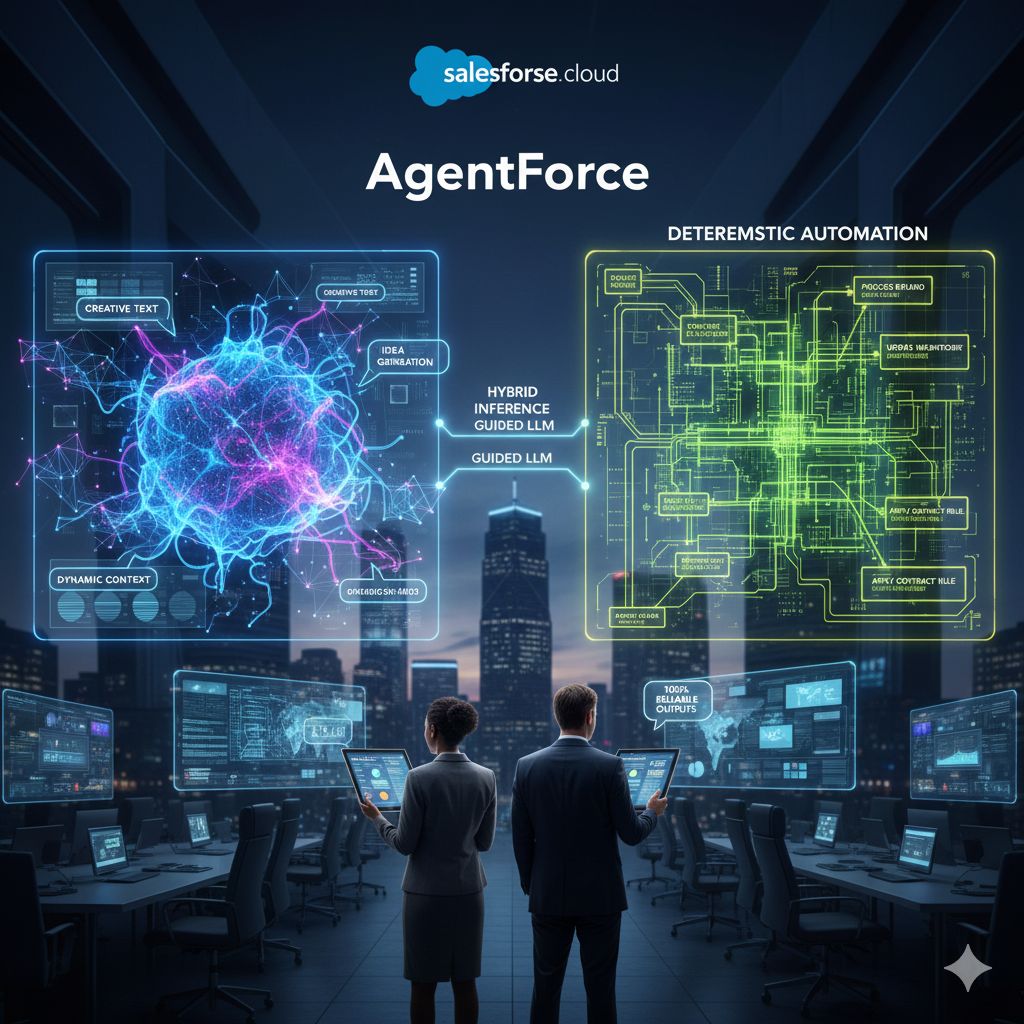

Questo tipo di esperienze ha portato Salesforce a formalizzare un nuovo paradigma, definito “determinismo guidato tramite inferenza ibrida”. Phil Mui, vicepresidente senior di Salesforce AI Research, ha descritto questa architettura come una combinazione tra flussi di lavoro deterministici e intelligenza degli LLM. In sostanza, i modelli linguistici continuano a essere utilizzati per comprendere il linguaggio naturale e gestire la complessità semantica, ma le decisioni critiche e le azioni operative vengono instradate attraverso una struttura rigida, chiamata Agent Graph, che garantisce controllo e ripetibilità. A supporto di questo approccio, Salesforce sta testando anche AgentForce Script, un sistema che stabilisce quando un agente può operare senza affidarsi al giudizio dell’LLM, eliminando la casualità nei processi aziendali fondamentali.

Questa evoluzione ha fatto nascere un dibattito acceso. Alcuni osservatori sostengono che si tratti di un ritorno al passato, a chatbot basati su regole, simili a quelli utilizzati prima dell’avvento degli LLM. Salesforce, però, respinge questa lettura. Secondo l’azienda, non si tratta di ridimensionare l’intelligenza artificiale, ma di rafforzarne l’efficacia, migliorando la struttura degli argomenti, la qualità del recupero delle informazioni e la pertinenza delle risposte. Il risultato dovrebbe essere un’AI meno imprevedibile, ma più utile e affidabile nei contesti reali.

Resta il fatto che questa scelta mette in luce un limite strutturale degli LLM quando vengono applicati indiscriminatamente a ogni tipo di problema. In settori come diritto, finanza, medicina, vendite o assistenza clienti, anche una minima variazione può avere conseguenze gravi. Le allucinazioni, tollerabili in un contesto creativo, diventano inaccettabili quando si gestiscono dati sensibili o processi critici. Ridurre la dipendenza dagli LLM in queste aree significa privilegiare stabilità e precisione, anche a costo di sacrificare parte della flessibilità e della ricchezza contestuale delle risposte.