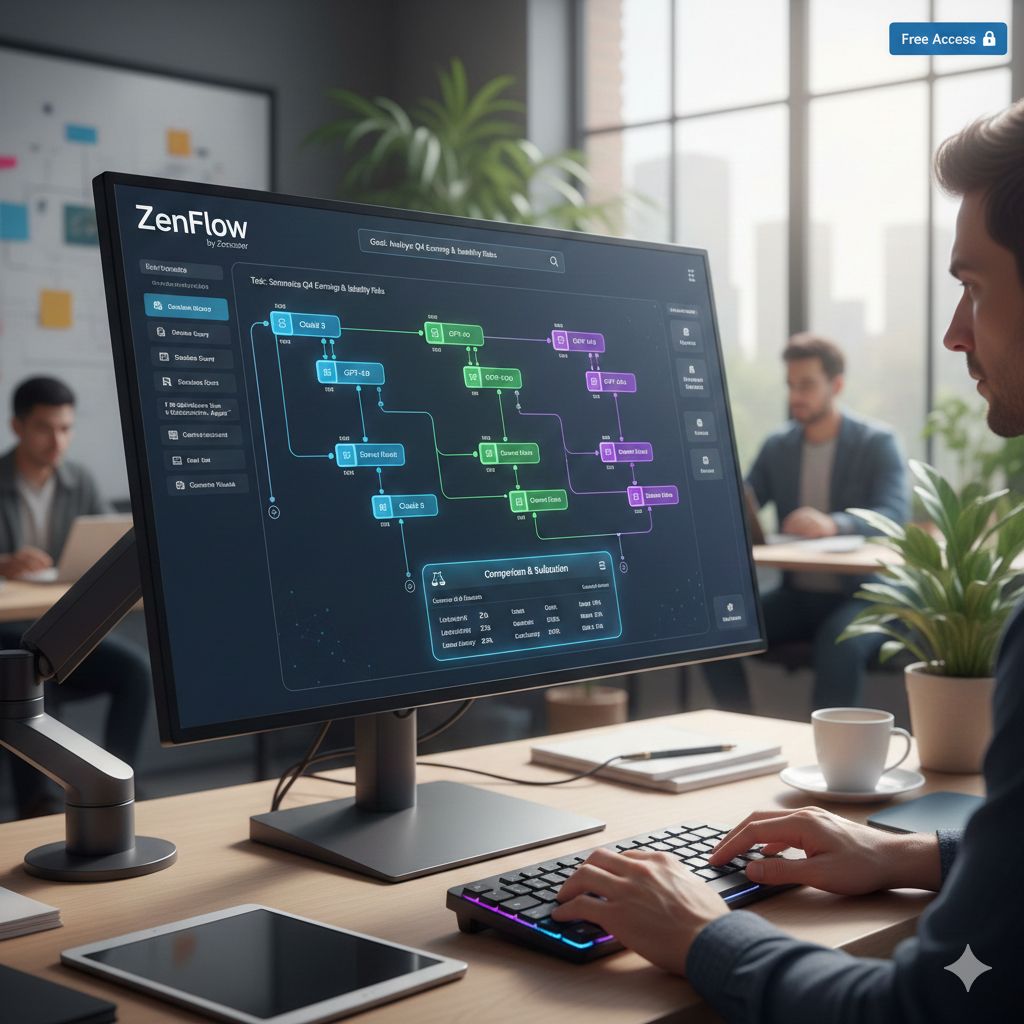

Uno dei problemi più concreti che sviluppatori e aziende si trovano ad affrontare non è tanto la qualità dei singoli modelli AI, quanto la difficoltà di coordinarli, confrontarli e integrarli in flussi di lavoro complessi. È in questo contesto che si inserisce ZenFlow, il nuovo strumento gratuito rilasciato da Zencoder, pensato per rendere l’orchestrazione dell’AI più trasparente, controllabile e soprattutto comparabile tra modelli diversi.

ZenFlow nasce con un’idea molto chiara: offrire un ambiente in cui sia possibile mettere i modelli AI uno contro l’altro, a partire da Claude, ma senza vincolarsi a un singolo fornitore o a un’unica architettura. L’obiettivo non è semplicemente eseguire prompt, ma costruire veri e propri flussi agentici in cui più modelli collaborano, si alternano o vengono valutati in parallelo, consentendo agli sviluppatori di capire non solo quale modello risponde meglio, ma anche perché e in quali condizioni.

Negli ultimi mesi, l’attenzione del settore si è spostata rapidamente dai singoli LLM agli agenti AI, ovvero sistemi capaci di pianificare, chiamare strumenti esterni, mantenere stato e prendere decisioni sequenziali. Tuttavia, orchestrare questi agenti richiede infrastrutture complesse, spesso costose e poco trasparenti. ZenFlow si propone come una risposta pragmatica a questo problema, offrendo un framework visuale e dichiarativo che permette di definire pipeline AI senza dover reinventare ogni volta l’intera logica di coordinamento.

Uno degli aspetti più interessanti di ZenFlow è il modo in cui rende esplicito il confronto tra modelli. In molti ambienti di sviluppo, il cambio di modello avviene “sotto il cofano”, con differenze difficili da misurare se non attraverso test manuali. Qui, invece, il confronto diventa parte integrante del flusso: lo stesso task può essere affidato a più modelli, come Claude e i suoi concorrenti, e i risultati possono essere osservati, confrontati e valutati in modo sistematico. Questo approccio riflette una consapevolezza crescente nel settore: non esiste un modello migliore in assoluto, ma modelli più o meno adatti a specifici contesti, vincoli e obiettivi.

Dal punto di vista filosofico, ZenFlow sembra sposare una visione “agnostica” dell’AI. Non si tratta di promuovere un modello specifico, ma di dare agli sviluppatori gli strumenti per scegliere in modo informato, basandosi su performance reali all’interno dei propri flussi applicativi. Questo è particolarmente rilevante in un momento in cui le aziende cercano di bilanciare qualità delle risposte, costi, latenza e requisiti di sicurezza o compliance.

Il fatto che ZenFlow sia distribuito come strumento gratuito non è un dettaglio secondario. In un ecosistema in cui molte piattaforme di orchestrazione AI sono legate a modelli di licensing complessi o a infrastrutture proprietarie, la scelta di abbassare la barriera d’ingresso suggerisce una strategia precisa: favorire l’adozione e la sperimentazione, lasciando che siano i casi d’uso reali a dimostrare il valore dell’orchestrazione avanzata. Questo rende ZenFlow particolarmente interessante anche per team piccoli o per sviluppatori indipendenti, che spesso non hanno accesso a strumenti enterprise ma vogliono comunque costruire sistemi AI sofisticati.

C’è poi un altro elemento che emerge chiaramente: ZenFlow non si limita a essere un “collante” tecnico, ma diventa uno spazio di osservazione del comportamento dei modelli. Mettere Claude a confronto diretto con altri LLM all’interno dello stesso flusso significa evidenziare differenze di stile, capacità di ragionamento, gestione delle istruzioni e risposta a contesti complessi. In questo senso, lo strumento può essere letto anche come una forma di laboratorio, utile non solo per sviluppare applicazioni, ma per comprendere più a fondo i limiti e i punti di forza dei modelli stessi.

L’arrivo di ZenFlow conferma una tendenza ormai chiara: il valore dell’AI non risiede più solo nel modello, ma nell’architettura che lo circonda. Orchestrazione, memoria, osservabilità e confronto diventano elementi centrali tanto quanto il prompt o il numero di parametri. Strumenti come questo segnalano che il mercato sta maturando e che la competizione tra modelli, invece di essere nascosta, viene sempre più spesso esposta, misurata e resa parte integrante del processo di sviluppo.