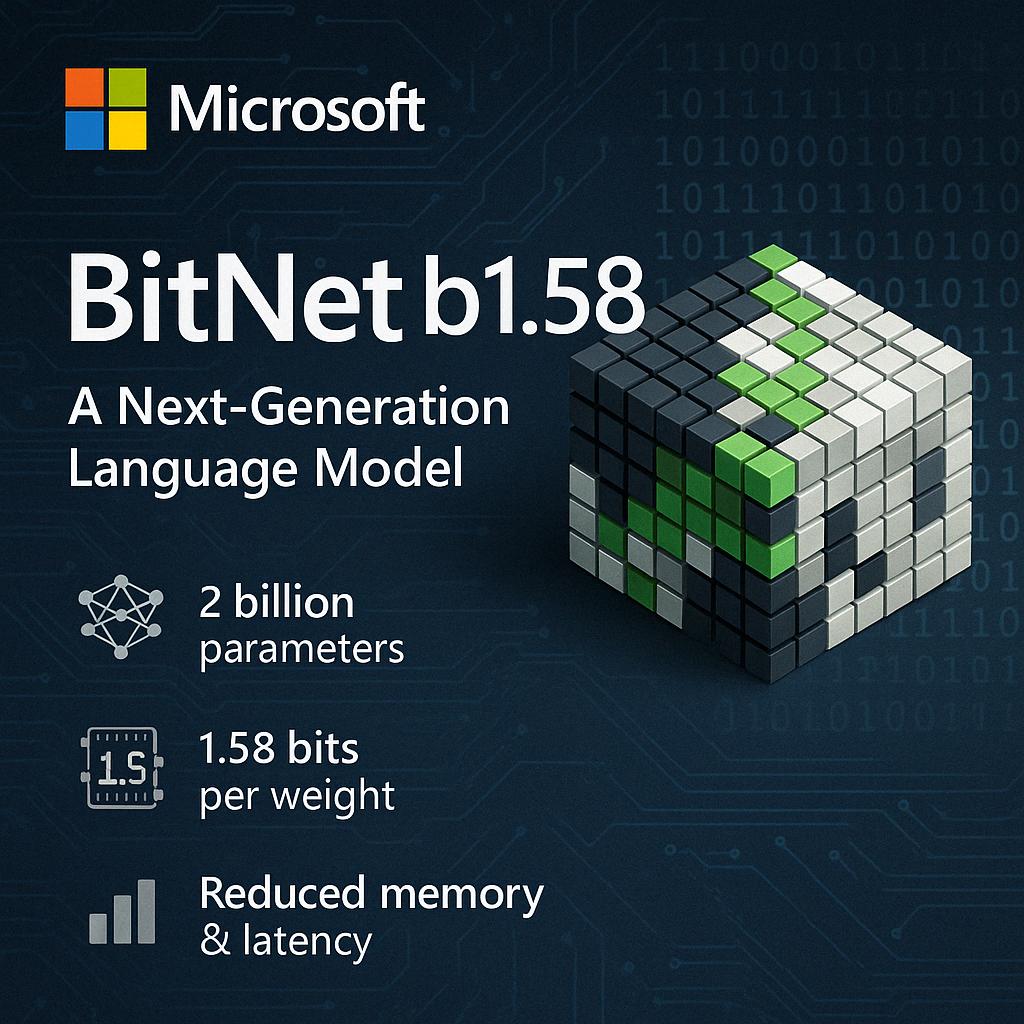

Microsoft ha recentemente introdotto BitNet b1.58, un modello di linguaggio di nuova generazione che ridefinisce l’efficienza nell’intelligenza artificiale. Con 2 miliardi di parametri e una quantizzazione innovativa a 1,58 bit per peso, BitNet b1.58 offre prestazioni paragonabili a modelli di precisione completa, ma con una riduzione significativa di memoria, consumo energetico e latenza di decodifica.

L’innovazione principale di BitNet b1.58 risiede nella sua architettura. Utilizzando un sistema di quantizzazione assoluta dei pesi a {-1, 0, +1} e attivazioni a 8 bit, il modello riduce drasticamente la dimensione dei dati senza compromettere la qualità del linguaggio. Questa struttura consente l’esecuzione efficiente su CPU standard, rendendo l’IA avanzata accessibile anche su dispositivi con risorse limitate.

Nonostante le dimensioni compatte, BitNet b1.58 eccelle in vari compiti, tra cui comprensione del linguaggio, matematica, programmazione e conversazione. Il modello è stato addestrato su un vasto dataset di 4 trilioni di token e ha dimostrato risultati competitivi rispetto ai modelli di precisione completa. Inoltre, l’uso di “BitLinear layers” ottimizzati per la quantizzazione consente un’elaborazione rapida e stabile.

Microsoft ha reso disponibili i pesi del modello su Hugging Face e ha rilasciato il codice open-source per l’esecuzione su CPU, facilitando l’adozione da parte di sviluppatori e ricercatori. Questa apertura promuove l’uso di BitNet b1.58 in scenari edge, come dispositivi IoT, assistenti vocali e applicazioni mobili, dove le risorse hardware sono limitate.

L’introduzione di BitNet b1.58 segna un passo significativo verso l’ottimizzazione dei modelli di linguaggio per ambienti con capacità computazionali ridotte. Questo approccio potrebbe democratizzare l’accesso all’intelligenza artificiale, permettendo a una vasta gamma di dispositivi di beneficiare di capacità avanzate di elaborazione del linguaggio naturale.