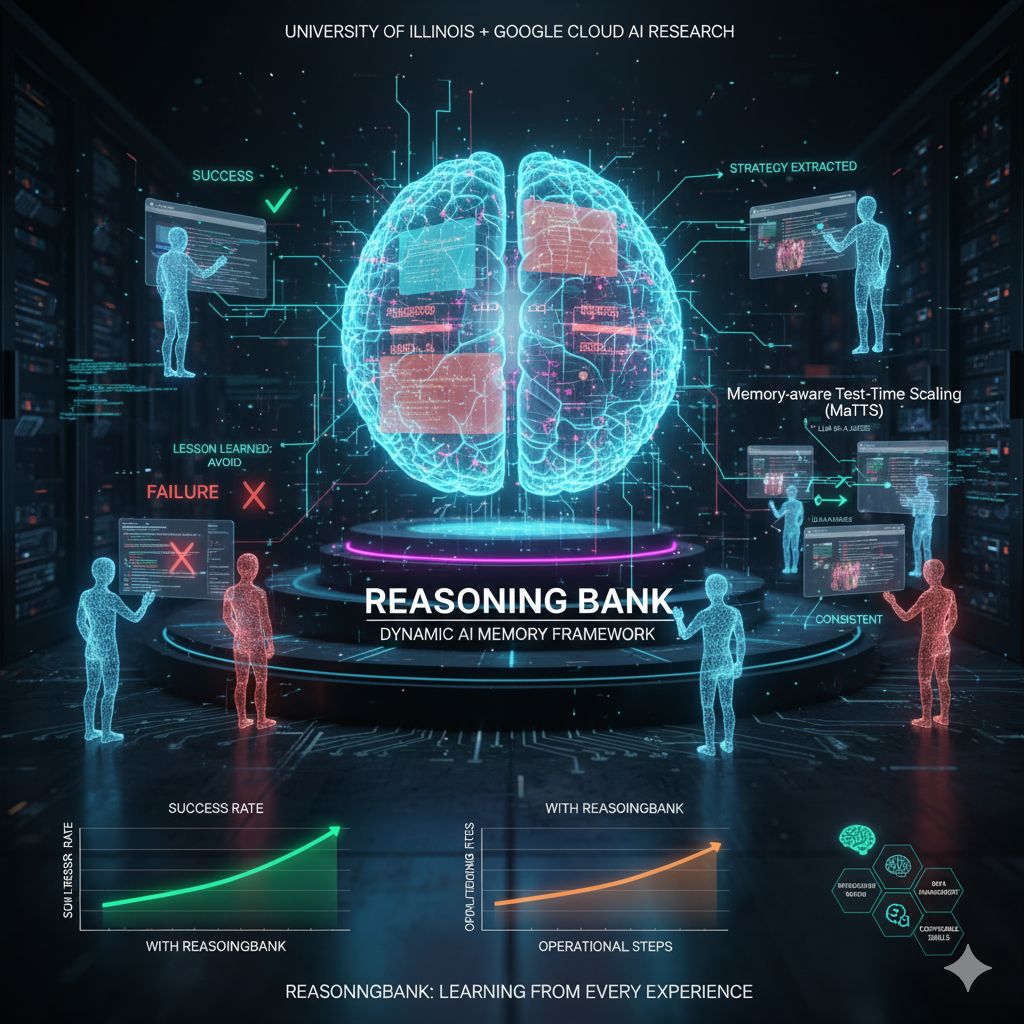

Uno dei problemi più sottili ma anche più sfidanti è quello della memoria AI: come fare in modo che un agente AI non ripeta gli stessi errori, che impari da ciò che ha già fatto e che diventi più efficace man mano che affronta nuovi compiti? Recentemente, un gruppo di ricercatori dell’University of Illinois Urbana-Champaign in collaborazione con Google Cloud AI Research ha proposto un’innovazione che cerca di colmare questo gap: un framework chiamato ReasoningBank, una sorta di memoria dinamica strutturata che permette agli agenti basati su modelli linguistici (LLM) di armonizzare le esperienze passate in una banca di ragionamenti utili e trasferibili.

L’idea centrale che guida ReasoningBank è la seguente: non basta memorizzare ogni interazione o ogni successo. Spesso è proprio da ciò che non ha funzionato che si può trarre il maggior insegnamento, trasformando gli errori in lezioni utili per il futuro. E così, ogni compito che l’agente affronta — che termini in successo o fallimento — diventa un’occasione per estrarre una “strategia” o un “indizio di ragionamento” che potrà essere richiamato, adattato o combinato quando si presenterà un nuovo problema. In questo modo non si procede mai da zero, ma si costruisce un’intelligenza che cresce nel tempo, sempre più sofisticata.

Il funzionamento di ReasoningBank prevede un processo circolare: quando un agente riceve un nuovo compito, prima interroga la memoria tramite un sistema di embedding che recupera quelli che sono gli elementi più rilevanti; quegli elementi vengono inseriti nel prompt del modello, dando un contesto e suggerimenti basati sulle esperienze passate. Dopo che il compito è stato portato a termine, l’agente valuta se l’esito sia stato positivo o negativo — avvalendosi, nel progetto, di uno schema “LLM-as-a-judge”, in cui è il modello stesso a stimare il successo — e da lì distilla nuovi elementi di memoria da aggiungere a ReasoningBank. In tali elementi vengono catturate le strategie vincenti e gli errori da evitare.

Ma il solo accumulo di ricordi, per quanto ben strutturato, rischia di essere inattivo se non è accompagnato da meccanismi che stimolino l’esplorazione e la diversificazione delle soluzioni. È qui che entra in gioco la combinazione con tecniche di “test-time scaling”: non limitarsi ad una singola risposta, ma generare più versioni del ragionamento per lo stesso problema, confrontarle, e indicare quelle che mostrano costanza nei passaggi di ragionamento. L’approccio integrato, definito Memory-aware Test-Time Scaling (MaTTS), consente di potenziare la memoria e di rendere l’agente più robusto: la memoria guida verso soluzioni promettenti, e le molteplici versioni esplorative arricchiscono la memoria con nuove traiettorie ragionate. In altre parole, la memoria diventa non un archivio passivo ma un motore attivo che alimenta ulteriori esplorazioni.

I test condotti dagli autori su benchmark come WebArena (per compiti di navigazione web) e SWE-Bench (per compiti di software engineering) mostrano risultati che non sono solo promettenti, ma in vari casi superiori rispetto a sistemi che usano memorie tradizionali o che non hanno memoria. In concreto, l’integrazione con MaTTS ha accresciuto il tasso di successo, ridotto i passaggi necessari e migliorato la generalizzazione verso compiti più complessi o diversi da quelli già affrontati. In situazioni pratiche, un agente senza memoria può impiegare molte operazioni di tentativi ed errori: ogni passo costa tempi e risorse. ReasoningBank consente di evitare questi tentativi ridondanti, offrendo direct hints che guidano l’agente verso le strategie più efficaci.

Il vantaggio non è solo prestazionale: è anche economico e operativo. In scenari enterprise, dove ogni chiamata al modello ha un costo computazionale, ridurre il numero di passi operativi e evitare prove inutili può fare la differenza. Un esempio offerto nell’articolo descrive un agente che, nel tentativo di filtrare prodotti su un sito web, impiega otto passaggi di iterazione: con ReasoningBank il sistema impara a riconoscere strategie di filtraggio e a evitarle, dimezzando quasi i costi operativi.

Oltre all’efficienza, il framework apre la porta a una forma di intelligenza sempre più modulare e composizionale: secondo i ricercatori, il sistema potrà accumulare “competenze discrete” — come integrazione di API, gestione di database, trasformazioni dati — che, nel tempo, possono essere combinabili in flussi di lavoro più complessi senza la necessità di ripensare ogni volta da zero. In questo modo, un agente potrebbe assemblare conoscenze pregresse per affrontare nuovi obiettivi con crescente autonomia.