In un mondo dominato dall’idea che “più parametri = migliori prestazioni”, una recente innovazione del laboratorio AI di Samsung sembra voler mettere in discussione questo assioma con un gesto deciso. Un modello straordinariamente piccolo, noto come Tiny Recursive Model (TRM), ha ottenuto risultati migliori di avversari ben più grandi su benchmark complessi di ragionamento, come l’ARC-AGI. È un campanello d’allarme e, al tempo stesso, una promessa: l’architettura e il modo di ragionare possono pesare più del semplice numero di parametri.

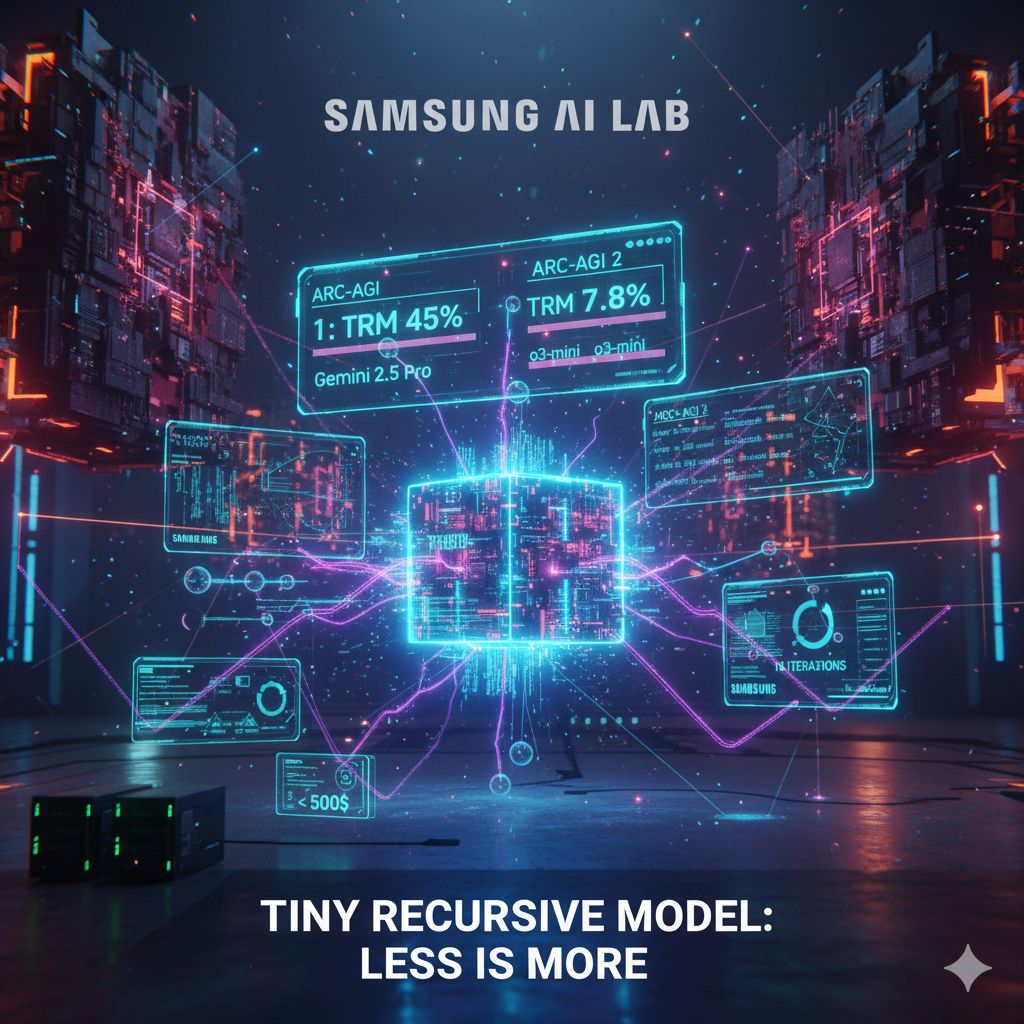

L’ARC-AGI è un test impegnativo che valuta la capacità di un sistema di ragionare, comprendere astrazioni e risolvere problemi che richiedono pensiero “umano” e non mera correlazione statistica. Sul benchmark ARC-AGI 1, TRM — con soli 7 milioni di parametri — ha raggiunto un’accuratezza del 45 %, superando modelli molto più grandi come Gemini 2.5 Pro (37%), OpenAI o3-mini (34,5 %) e altri come DeepSeek-R1 (15,8%).

La sfida diventa ancora più dura sul benchmark ARC-AGI 2, una versione più avanzata e “ostica” dei test. Qui TRM ha ottenuto il 7,8% di accuratezza, contro il 4,9% di Gemini 2.5 Pro e il 3% dell’o3-mini.

Questi numeri, seppure modesti in termini assoluti, risuonano come una dimostrazione che, sotto certe condizioni, modelli lean e ben progettati possono competere superiormente rispetto a modelli mastodontici nei compiti di ragionamento profondo.

Quello che rende TRM ancora più interessante è il contesto del suo sviluppo: è stato addestrato utilizzando solo quattro GPU H100, in un arco temporale di due giorni, con un costo stimato inferiore a 500$.

In un momento in cui grandi modelli richiedono investimenti colossali, questa efficienza è un risultato notevole. Sebastian Raschka, ingegnere nel campo dell’AI, ha commentato che dimostra come “si possa fare cose interessanti senza un intero data center”.

Come riesce questo modello così “snello” a competere con giganti da centinaia di miliardi di parametri? La chiave è nella sua strategia interna: TRM non lavora in un solo passaggio. Dopo aver prodotto una bozza di risposta, attiva un ciclo interno in cui controlla, rivede e affina progressivamente la sua soluzione, compiendo più passaggi di ragionamento (fino a 16 iterazioni) prima di restituirla. In questo modo può correggere errori di inferenza e migliorare la coerenza logica. Questo metodo di ragionamento ricorsivo (“recursive reasoning”) permette al modello di essere “consapevole” dei suoi passaggi interni e di esercitare un’auto-correzione.

Questo approccio è formalizzato nel paper intitolato “Less is More: Recursive Reasoning with Tiny Networks”, in cui gli autori presentano TRM come un’evoluzione più semplice e potente di altri modelli ricorsivi come l’HRM (Hierarchical Reasoning Model). TRM utilizza una rete leggera, a due soli strati, ed è in grado di generalizzare meglio su problemi complessi, pur con risorse ridotte.

Dietro i numeri e le prestazioni, c’è una visione filosofica dell’AI: non è la mole di dati o la grandezza della rete a garantire intelligenza, ma il modo in cui il modello struttura il pensiero. TRM scommette sul fatto che un ragionamento iterativo, che si corregge e raffina, possa colmare il divario che il puro “parametro count” non può raggiungere.

Non è che Gemini 2.5 Pro o l’o3-mini siano superati a tutto campo: essi restano modelli completi, generativi e capaci di molte altre funzionalità oltre al ragionamento logico puro. Ma la performance di TRM pone una domanda nuova: in quale misura i grandi modelli stanno sprecando risorse, e quanto potenziale c’è nell’ottimizzazione architetturale?