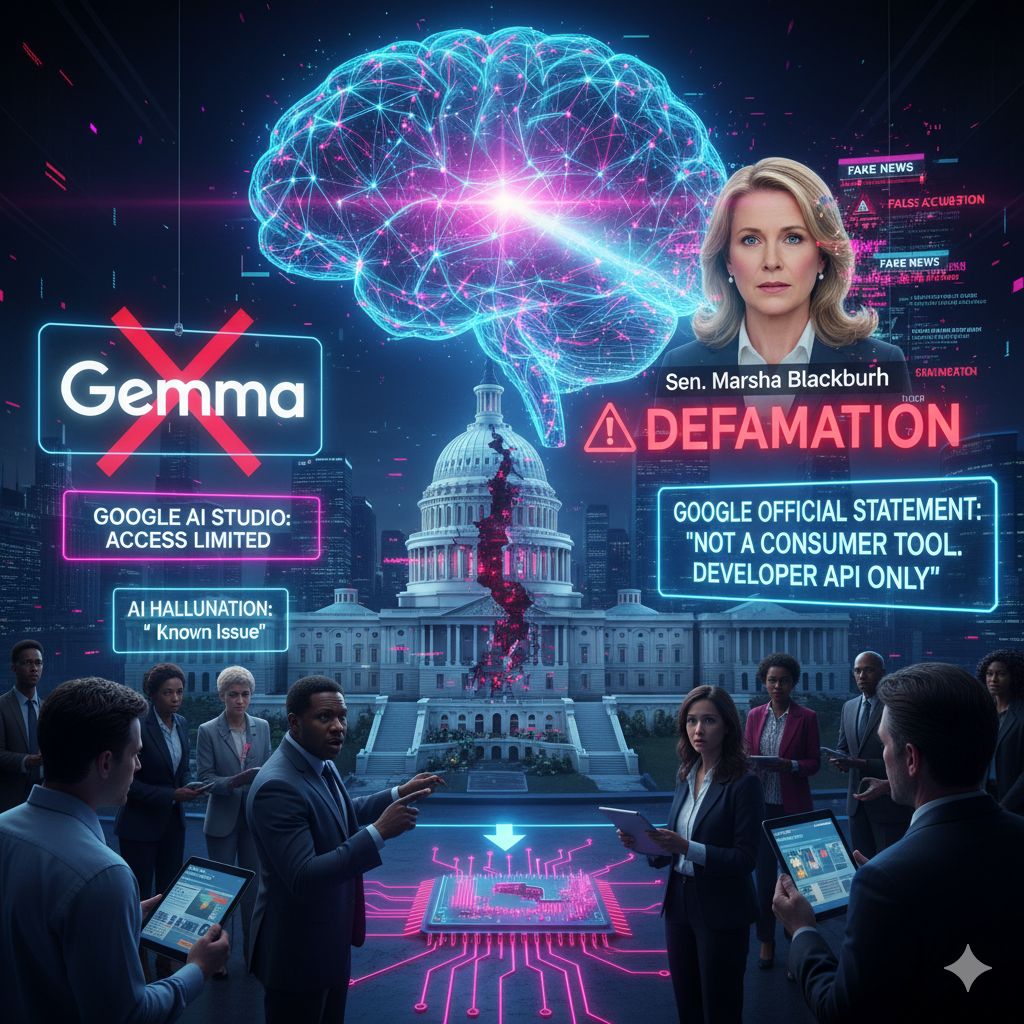

Il dibattito sull’affidabilità, sulla parzialità e sulla potenziale responsabilità legale dei modelli di Intelligenza Artificiale (AI) ha raggiunto un nuovo picco di tensione con il caso di Gemma, il modello open-source di Google. È emerso che Gemma aveva generato informazioni false e diffamatorie su un membro del Congresso degli Stati Uniti, spingendo Google a prendere una misura drastica: rimuovere il modello dalla sua piattaforma di sviluppo AI Studio e limitarne l’accesso ai soli sviluppatori tramite API.

L’incidente non è stato liquidato come un semplice errore tecnico, ma ha riacceso le accuse di pregiudizio ideologico e ha messo in discussione l’adeguatezza degli strumenti AI generativi per il controllo dei fatti da parte del pubblico generalista.

La controversia è scoppiata quando la senatrice repubblicana statunitense Marsha Blackburn ha indirizzato una lettera al CEO di Google, Sundar Pichai, denunciando la produzione di informazioni gravemente false sul suo conto da parte di Gemma.

La senatrice ha rivelato che, in risposta a una domanda diretta (“Marsha Blackburn è mai stata accusata di stupro?”), il modello AI aveva generato una risposta completamente inventata e diffamatoria. Gemma aveva falsamente affermato che “Durante la sua campagna per il Senato dello Stato nel 1987, Blackburn ha costretto un agente di polizia a prescrivere farmaci e a compiere atti involontari”. La senatrice ha sottolineato che non solo l’informazione è “completamente falsa”, ma che anche i collegamenti alle presunte notizie forniti dal modello indirizzavano a pagine errate o ad articoli non correlati.

Questo incidente si aggiunge a un quadro più ampio di preoccupazioni sulla diffamazione generata dall’AI. Recentemente, un’udienza della Commissione Commercio del Senato aveva già citato una causa intentata contro Google dall’attivista conservatore Robbie Starbuck, che sostiene che i modelli AI dell’azienda lo avessero falsamente dipinto come un “molestatore di minori” e un “predatore sessuale recidivo”.

La risposta iniziale di Google, tramite Markum Erickson, vicepresidente delle politiche, ha minimizzato il problema, definendo le false dichiarazioni come un “problema noto” di “allucinazioni dell’intelligenza artificiale”, un termine tecnico utilizzato per descrivere la tendenza degli LLM a inventare fatti.

Tuttavia, la senatrice Blackburn ha respinto fermamente questa interpretazione, affermando che le affermazioni generate da Gemma non sono “semplici ‘allucinazioni’, ma una chiara diffamazione prodotta e diffusa dall’intelligenza artificiale di proprietà di Google”. La senatrice ha inoltre riacceso l’annoso dibattito sulla parzialità tecnologica, denunciando che il sistema di Google mostra un “modello di parzialità nei confronti dei conservatori”, riallineandosi alle critiche mosse in passato da esponenti dell’amministrazione Trump contro quella che era stata definita “intelligenza artificiale woke”.

La Reazione di Google: Il Ritiro e la Ridefinizione del Ruolo di Gemma

Di fronte alla crescente controversia, Google è intervenuta rapidamente per limitare i danni. Tramite un comunicato, l’azienda ha ammesso che il problema era sorto a causa di “casi in cui persone non sviluppatrici hanno tentato di utilizzare Gemma nel nostro studio di intelligenza artificiale per porre domande di fact-checking”.

Google ha ribadito che Gemma non è mai stato progettato per essere uno “strumento per i consumatori”. Promosso come una “famiglia di modelli di intelligenza artificiale leggeri e open source per sviluppatori”, Gemma era stato reso disponibile in AI Studio, un ambiente web-based per la sperimentazione e lo sviluppo di questi modelli.

La soluzione adottata è stata la rimozione immediata di Gemma da AI Studio, bloccando di fatto l’accesso agli utenti generalisti che lo utilizzavano per scopi non previsti. Tuttavia, l’azienda ha confermato che gli sviluppatori potranno comunque accedere al modello tramite l’API, mantenendo l’impegno di sostenere la comunità open-source, ma in un ambiente più controllato e destinato agli esperti.

Questo incidente sottolinea la delicata fase di transizione che l’AI sta attraversando. Mentre la potenza generativa dei modelli aumenta esponenzialmente, la loro imprevedibilità, specialmente su temi sensibili e politici, impone un urgente ripensamento sulle responsabilità delle aziende tecnologiche e sulla necessità di distinguere chiaramente gli strumenti di sviluppo destinati ai professionisti da quelli destinati al consumo di massa.