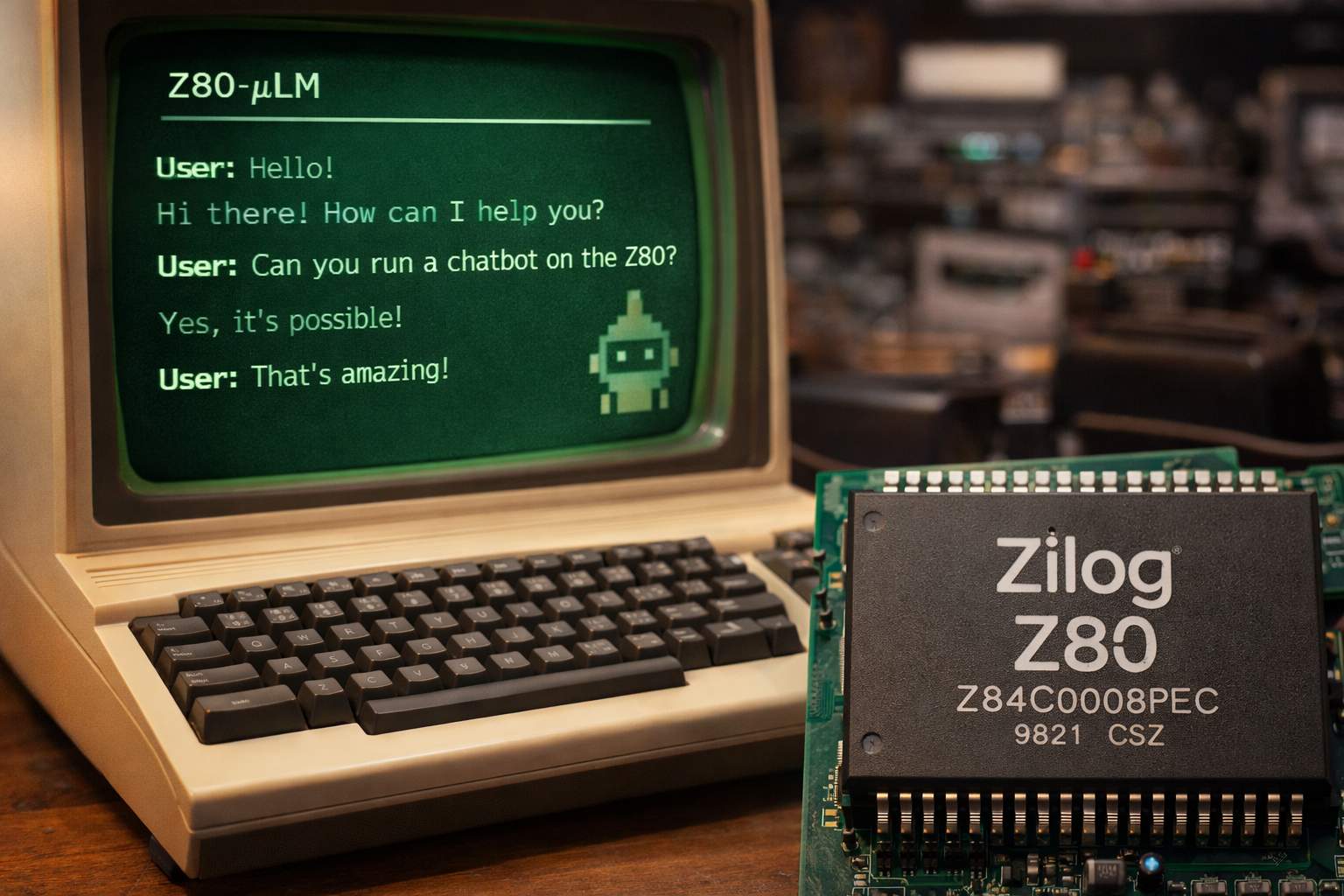

In un’epoca in cui l’intelligenza artificiale generativa sembra richiedere potenza di calcolo enorme, infrastrutture cloud e hardware all’avanguardia, un progetto recente ha catturato l’immaginazione degli appassionati di tecnologia e retrocomputing dimostrando qualcosa di sorprendente: un mini-chatbot può funzionare anche su un microprocessore storico come lo Zilog Z80, nato nel 1976 e celebre per essere stato alla base di una vasta generazione di home computer e sistemi embedded.

Il progetto in questione, noto come Z80-μLM, è un modello linguistico estremamente compatto capace di girare interamente su un processore Z80 con appena 64 KB di memoria RAM e una frequenza di clock di soli 4 MHz. Questa realizzazione si basa su tecniche di quantizzazione a 2 bit per i pesi del modello e su un’implementazione che usa esclusivamente aritmetica su interi, evitando operazioni floating point complesse che sarebbero impossibili da gestire su un hardware così limitato.

La creazione di Z80-μLM risponde a una domanda provocatoria: fino a che punto si può “miniaturizzare” un modello linguistico fino ad adattarlo a un ambiente così ristretto e primitivo, dal punto di vista dei requisiti hardware? La risposta sta in una serie di compromessi ingegnosi. Il modello non è paragonabile per capacità a ChatGPT o ad altre AI moderne: genera testo carattere per carattere e non è in grado di sostenere conversazioni complesse o articolate, ma è sufficiente per offrire un’interazione minimale che ricorda quella di un chatbot. Un binario di circa 40 KB è tutto ciò che serve per far girare l’intero sistema, un risultato che per chi si occupa di retrocomputing rappresenta una sorta di piccolo miracolo tecnologico.

Lo Zilog Z80 non è un processore qualsiasi. Introdotto nel 1976 come microprocessore a 8 bit ed evoluzione dell’Intel 8080, fece la fortuna di molte macchine storiche, dai Sinclair ZX80 e ZX81 ai sistemi CP/M e home computer come gli ZX Spectrum, oltre a migliaia di apparecchi embedded e prodotti elettronici. L’architettura del chip, pur elementare se vista con gli occhi di oggi, con registri a 8 e 16 bit e un set di istruzioni relativamente ricco per l’epoca, si è dimostrata sorprendentemente flessibile, tanto da poter ospitare un micro-modello linguistico con tecniche di encoding efficienti.

La strategia tecnica di Z80-μLM è l’uso di un sistema di codifica basato su trigrammi per l’input testuale, che mappa serie di tre caratteri in bucket numerici in modo da ridurre l’ordine delle parole e aumentare la tolleranza ai refusi. I pesi quantizzati a 2 bit sono impacchettati in modo estremamente compatto, e l’inferenza — ovvero la generazione di testo — avviene tutto in memoria interna tramite operazioni su registri e coppie di registri da 16 bit. Con queste tecniche, un dispositivo concepito per applicazioni della fine degli anni Settanta è in grado di offrire una forma base di intelligenza conversazionale senza alcun supporto esterno.

Dal punto di vista pratico, il risultato non è un chatbot in senso moderno: lo Z80-μLM non comprende la grammatica o il significato profondo delle frasi come farebbe una rete neurale di ultima generazione. Il suo funzionamento è più simile a una versione estremamente semplificata di quelli che erano i primi esperimenti di dialogo uomo-macchina, lontani anni luce dai sistemi sofisticati che oggi alimentano assistenti digitali, motori di ricerca conversazionali o applicazioni aziendali. Tuttavia, come prova concettuale, dimostra che l’idea di “IA” non è necessariamente legata a memoria enorme o GPU potenti, ma può essere esplorata anche in contesti vincolati, dove l’attenzione si sposta su efficienza, rappresentazione dei dati e ottimizzazione.

In un certo senso, progetti come Z80-μLM sono anche un omaggio alla storia dell’informatica. Ricordano che i paradigmi di computing odierni, dominati da intelligenze artificiali complesse e infrastrutture cloud, hanno radici che affondano nei primi microprocessori, che erano già in grado di gestire compiti sorprendenti per l’epoca. Il successo di questa sperimentazione non solo racconta un legame affettivo con l’hardware vintage, ma apre anche una riflessione su come l’AI possa essere resa più accessibile e distribuita, proponendo percorsi per applicazioni embedded ultra-compatte o dispositivi intelligenti che non dipendono da connessioni esterne o server potenti.