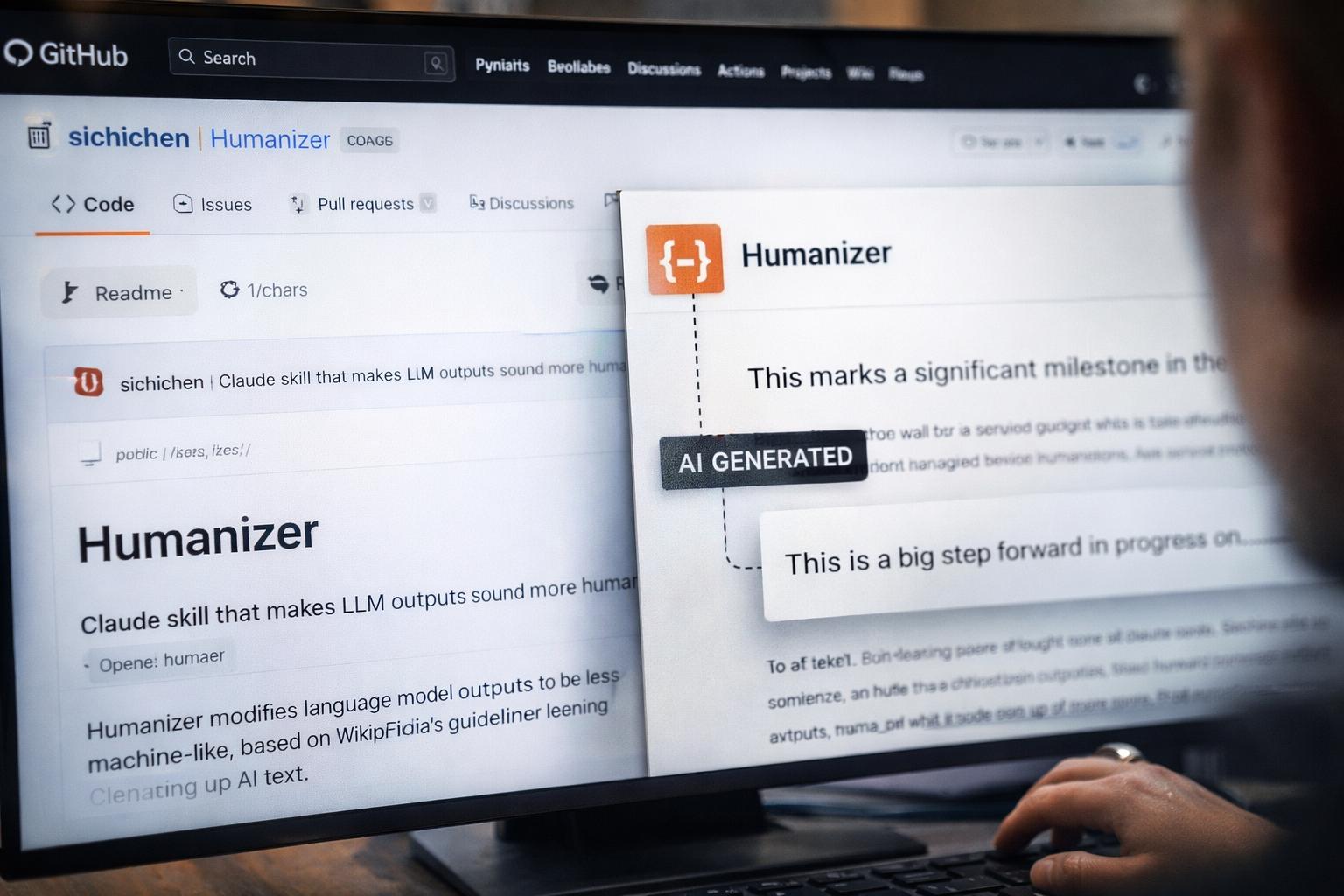

Il dibattito sulla riconoscibilità dei testi generati dall’intelligenza artificiale ha fatto un significativo passo avanti grazie a un’iniziativa che sta scuotendo la comunità degli sviluppatori su GitHub. Sichi Chen, un imprenditore del settore tecnologico, ha recentemente rilasciato un plugin open source denominato “Humanizer”, progettato specificamente per essere integrato come “abilità” all’interno di Claude Code, l’agente di codifica avanzato di Anthropic. L’obiettivo di questo strumento è tanto semplice quanto ambizioso: istruire il modello a evitare quegli schemi narrativi e quelle strutture sintattiche che rendono i suoi testi immediatamente identificabili come prodotti da un algoritmo, favorendo uno stile più asciutto e vicino alla sensibilità umana.

La particolarità di Humanizer risiede nella sua fonte d’ispirazione. Invece di basarsi su teorie linguistiche astratte, il plugin utilizza direttamente le linee guida compilate dagli editor di Wikipedia all’interno del progetto WikiProject AI Cleanup. Dalla fine del 2023, questo gruppo di volontari ha analizzato migliaia di articoli generati da chatbot, isolando ventiquattro schemi ricorrenti e modi di dire tipici che caratterizzano la prosa artificiale. Questi includono l’uso eccessivo di aggettivi enfatici, l’adozione di un tono che ricorda il marketing turistico e una generale tendenza alla prolissità. Implementando queste osservazioni come un set di regole di programmazione, Chen ha permesso a Claude di filtrare le proprie risposte, eliminando ad esempio espressioni ridondanti come “questo segna una svolta significativa” a favore di affermazioni più dirette e fattuali.

I primi test condotti con questo plugin mostrano un cambiamento evidente nella qualità del linguaggio prodotto. Le frasi risultano meno rifinite, perdono quella patina di perfezione artificiale e assumono un tono più informale e meno strutturato. Tuttavia, questo processo di “umanizzazione” non è privo di controindicazioni. Gli esperti notano che lo strumento non migliora in alcun modo l’accuratezza dei fatti riportati e, in certi contesti, può persino rivelarsi controproducente. Inserire opinioni personali o un linguaggio meno neutro all’interno di documentazioni tecniche o manuali ufficiali rischia di minare la precisione e la professionalità che ci si aspetta da tali materiali.

L’aspetto più ironico e discusso di questa vicenda riguarda il modo in cui le regole create per identificare l’intelligenza artificiale vengano ora utilizzate per aiutarla a mimetizzarsi. Gli editor di Wikipedia avevano stilato la loro guida per facilitare la pulizia dell’enciclopedia dai contenuti generati automaticamente, ma quello stesso elenco è diventato lo schema ideale per aggirare i rilevatori di testo. Questo evidenzia la fragilità dei sistemi di monitoraggio attuali: se un testo umano può essere erroneamente etichettato come artificiale per la sua precisione, un’intelligenza artificiale può facilmente sembrare umana semplicemente modificando il proprio stile di scrittura attraverso un prompt ben calibrato.