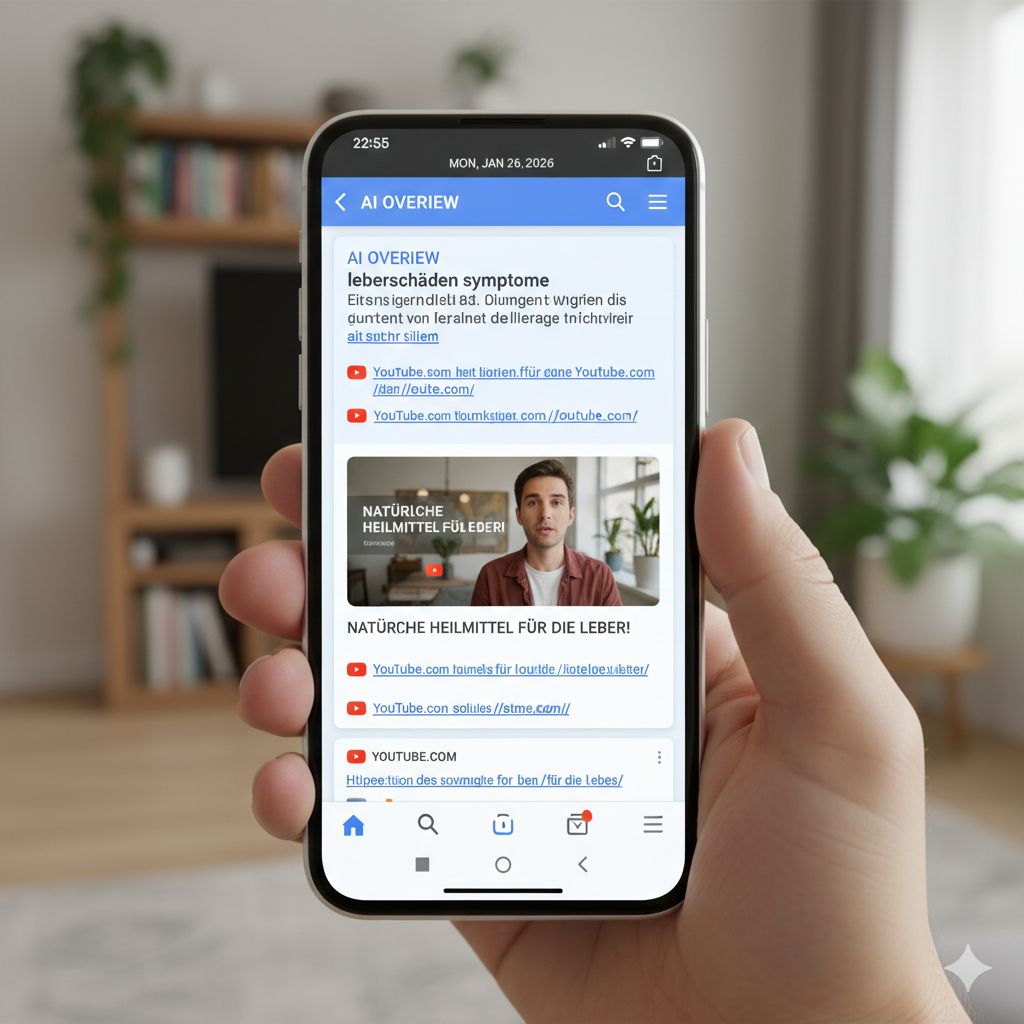

Con l’espansione di AI Overviews (Panoramiche AI) in cima ai risultati di ricerca, Google ha cambiato in modo profondo il modo in cui miliardi di persone accedono alle informazioni online. Oggi circa due miliardi di utenti al mese visualizzano risposte sintetiche generate dall’intelligenza artificiale prima ancora di scorrere i link tradizionali. In ambiti come la salute, però, questa trasformazione solleva interrogativi particolarmente delicati, perché la qualità delle fonti e il modo in cui vengono selezionate possono avere conseguenze dirette sul benessere delle persone.

Un recente studio condotto dalla piattaforma SEO SE Ranking e riportato da The Guardian ha acceso i riflettori su un aspetto critico di questo sistema. Analizzando oltre 58.000 ricerche sanitarie in lingua tedesca, i ricercatori hanno osservato quali fonti vengano più spesso citate dalle Panoramiche AI di Google. Il risultato ha sorpreso molti osservatori: la fonte più frequentemente menzionata non è stata un’istituzione medica, né un ente governativo o accademico, ma YouTube.

YouTube è comparso come dominio citato con maggiore frequenza all’interno di quasi mezzo milione di citazioni complessive. Questo dato è particolarmente significativo perché la piattaforma, pur ospitando anche contenuti di alta qualità prodotti da ospedali e professionisti sanitari, rimane un servizio aperto in cui chiunque può pubblicare video, inclusi influencer e creator privi di formazione medica. Il confronto con altre fonti è eloquente: dopo YouTube compaiono siti di emittenti pubbliche, manuali medici di riferimento e portali sanitari consolidati, ma con una distanza netta in termini di numero di citazioni.

Da tempo Google sostiene che le sue Panoramiche AI facciano ampio uso di fonti sanitarie autorevoli come i Centers for Disease Control and Prevention o la Mayo Clinic. Lo studio di SE Ranking, tuttavia, suggerisce che nella pratica la visibilità e la popolarità online giochino un ruolo molto più rilevante nella selezione delle fonti rispetto alla loro credibilità medica. YouTube, per sua natura, beneficia di una presenza pervasiva nei risultati di ricerca e di un’enorme quantità di contenuti indicizzati, fattori che possono favorirne la citazione automatica anche in contesti dove l’autorevolezza scientifica dovrebbe essere prioritaria.

Il problema non è puramente teorico. All’inizio del mese, il Guardian aveva già segnalato casi in cui le Panoramiche AI fornivano informazioni fuorvianti su test di funzionalità epatica, con il rischio concreto di indurre in errore pazienti affetti da patologie gravi. In seguito a queste segnalazioni, Google ha temporaneamente rimosso la funzione da alcune ricerche mediche specifiche, ma secondo gli osservatori il nodo di fondo resta irrisolto. Quando un sistema automatico sintetizza informazioni sanitarie attingendo in modo massiccio a fonti non specialistiche, il margine di errore diventa strutturale, non episodico.

La scelta della Germania come oggetto dello studio non è casuale. Si tratta di un Paese inserito in un contesto normativo sanitario particolarmente rigoroso, all’interno di un quadro europeo che pone grande attenzione alla tutela dei cittadini. Eppure, anche in questo scenario regolato, le Panoramiche AI sono comparse in oltre l’82% delle ricerche sanitarie analizzate, dimostrando quanto la diffusione di queste risposte automatiche sia già capillare. Se un simile sbilanciamento delle fonti emerge in un contesto così controllato, è lecito ipotizzare che il problema non sia limitato a una singola area geografica.

A sottolineare la portata del fenomeno è intervenuta anche Hanna van Kolfschoten, ricercatrice in intelligenza artificiale, salute e diritto presso l’University of Basel. Secondo la studiosa, i risultati dimostrano empiricamente che i rischi legati alle informazioni sanitarie generate dall’AI non sono incidenti isolati, ma il sintomo di un problema strutturale. In questo modello, la conoscenza sanitaria sembra essere guidata più dalla visibilità algoritmica che dall’autorevolezza scientifica, con conseguenze potenzialmente gravi per la qualità dell’informazione pubblica.

Google ha respinto queste conclusioni, affermando che i dati del rapporto non dimostrerebbero l’inaffidabilità delle Panoramiche AI. Un portavoce ha sottolineato che molti dei domini citati sono considerati attendibili e che anche su YouTube una larga parte dei contenuti più popolari in ambito sanitario proviene da canali medici ufficiali, come ospedali e cliniche. In particolare, l’azienda ha evidenziato che il 96% dei 25 video sanitari più popolari su YouTube è prodotto da fonti mediche qualificate.

Il punto sollevato da SE Ranking, però, è che questi video rappresentano solo una minima frazione dell’universo complessivo dei contenuti citati. Concentrarsi sui pochi esempi più popolari può dare un’impressione rassicurante, ma non risolve il problema della lunga coda di video meno visibili, potenzialmente imprecisi o fuorvianti, che continuano a essere utilizzati come fonte dalle Panoramiche AI. In altre parole, anche se una piccola percentuale di contenuti è affidabile, il sistema nel suo complesso rimane esposto al rischio di amplificare informazioni non verificate.

Il caso delle Panoramiche AI in ambito sanitario mette in luce una tensione sempre più evidente tra automazione, popolarità e responsabilità. L’intelligenza artificiale promette accesso rapido e semplificato alla conoscenza, ma quando la semplificazione si appoggia a criteri di visibilità anziché di competenza, il confine tra informazione e disinformazione diventa sottile. In un settore come la salute, dove le decisioni degli utenti possono avere conseguenze concrete sulla vita delle persone, questa dinamica non è un dettaglio tecnico, ma una questione di interesse pubblico che richiede attenzione, trasparenza e, forse, un ripensamento profondo dei criteri con cui l’AI seleziona e presenta le fonti.