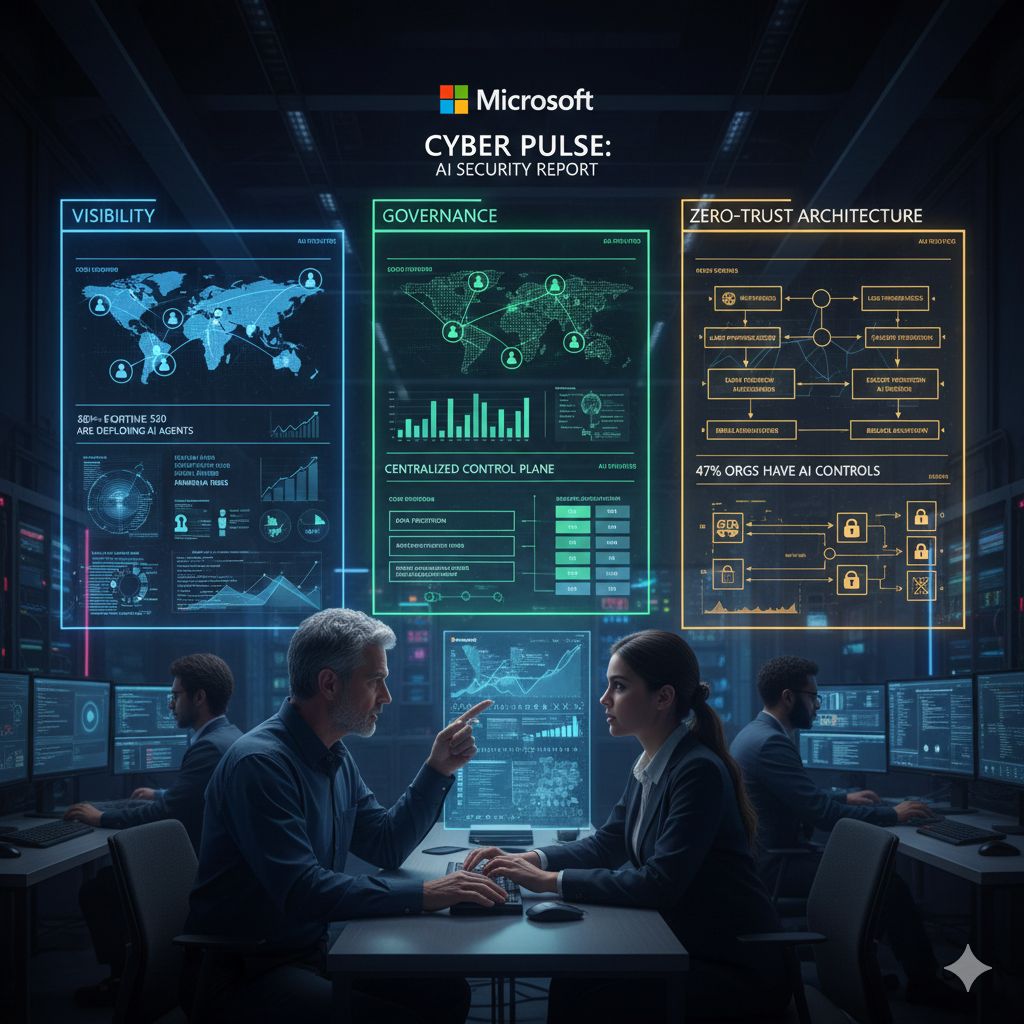

L’introduzione massiva degli agenti di intelligenza artificiale nei processi aziendali sta cambiando rapidamente l’equilibrio tra innovazione e sicurezza. In questo contesto, Microsoft ha pubblicato il suo nuovo report sulla sicurezza dell’IA, intitolato “Cyber Pulse”, delineando un quadro strategico per consentire alle organizzazioni di adottare agenti intelligenti in modo controllato, governato e conforme ai principi di sicurezza moderna. Il documento mette al centro tre concetti fondamentali: visibilità, governance e architettura zero-trust, presentati come elementi imprescindibili per accelerare l’innovazione senza amplificare i rischi.

Secondo il report, i team ibridi composti da persone e agenti stanno crescendo rapidamente a livello globale. Non si tratta più di sperimentazioni isolate, ma di una trasformazione strutturale del modo in cui le aziende operano. Un sondaggio citato da Microsoft indica che oltre l’80% delle aziende Fortune 500 sta sviluppando e gestendo agenti attivi utilizzando strumenti low-code o no-code. Questo dato fotografa un cambiamento profondo: l’intelligenza artificiale non è più confinata ai laboratori di ricerca o ai dipartimenti IT, ma è sempre più nelle mani dei team operativi e di business.

Proprio questa democratizzazione comporta nuove responsabilità. Il report sottolinea che le organizzazioni che emergeranno nella corsa all’adozione dell’IA saranno quelle capaci di creare un sistema integrato in cui business, IT e sicurezza collaborano attivamente per monitorare l’attività degli agenti, applicare regole di governance e rafforzare i controlli di sicurezza. Senza un coordinamento trasversale, l’innovazione rischia di procedere più velocemente della capacità di controllo.

Un punto centrale dell’analisi è il richiamo ai principi di zero-trust, un paradigma che Microsoft promuove da anni nel campo della cybersecurity. Applicato agli agenti di intelligenza artificiale, il modello zero-trust si fonda su tre pilastri: accesso con privilegi minimi, verifica esplicita e presupposto di violazione. Gli agenti devono ricevere solo le autorizzazioni strettamente necessarie per svolgere i loro compiti, ogni richiesta di accesso deve essere verificata sulla base di identità, dispositivo, posizione e livello di rischio, e l’intero sistema deve essere progettato assumendo che una violazione sia sempre possibile. Questo approccio, già consolidato per utenti e dispositivi, viene ora esteso agli agenti software, che diventano a tutti gli effetti nuovi attori nel perimetro aziendale.

Il report evidenzia come l’adozione accelerata degli agenti stia spesso superando i controlli di sicurezza e conformità esistenti. In questo scenario emerge il rischio della cosiddetta “intelligenza artificiale ombra”, un fenomeno simile alla shadow IT ma potenzialmente più insidioso. Gli agenti, se configurati con diritti di accesso eccessivi o istruzioni inappropriate, possono diventare vettori involontari di vulnerabilità. Proprio come un dipendente umano con troppi privilegi, un agente mal governato può essere sfruttato da attori malevoli o causare esposizioni accidentali di dati sensibili.

I rischi non sono solo teorici. Un sondaggio commissionato da Hypothesis Group per Microsoft ha rilevato che il 29% dei dipendenti ha utilizzato agenti di intelligenza artificiale non autorizzati nel proprio lavoro. Inoltre, secondo il Microsoft Data Security Index, solo il 47% delle organizzazioni ha implementato controlli specifici per l’intelligenza artificiale generativa. Questi numeri indicano un divario significativo tra l’entusiasmo per l’adozione e la maturità dei sistemi di controllo.

Per affrontare queste criticità, il report identifica una serie di azioni concrete. Viene sottolineata la necessità di definire chiaramente l’ambito operativo degli agenti, rafforzare i sistemi di protezione dei dati e fornire una piattaforma di intelligenza artificiale ufficialmente approvata, in modo da evitare la proliferazione di strumenti non governati. È fondamentale anche predisporre piani di risposta agli incidenti specifici per l’IA, integrare la gestione dei rischi a livello aziendale e promuovere una cultura dell’innovazione sicura, in cui la sperimentazione non avvenga a scapito della protezione.

Microsoft insiste su un concetto chiave: la visibilità centralizzata. Per gestire efficacemente un ecosistema di agenti distribuiti, è necessario un piano di controllo unico in grado di osservare, monitorare e governare ogni agente in modo coerente. Solo attraverso una piattaforma integrata è possibile garantire che tutti i livelli dell’organizzazione – business, IT, sicurezza, team AI e sviluppatori – collaborino in modo strutturato.

Il messaggio finale del report è chiaro. L’adozione degli agenti di intelligenza artificiale non è una questione di “se”, ma di “come”. Le aziende che riusciranno a integrare visibilità, governance e sicurezza nel cuore delle proprie strategie digitali saranno quelle in grado di sfruttare appieno il potenziale dell’IA senza compromettere la resilienza organizzativa. In un contesto in cui persone e agenti lavorano fianco a fianco, la sicurezza non può più essere un livello aggiuntivo, ma deve diventare parte integrante dell’architettura stessa dell’innovazione.