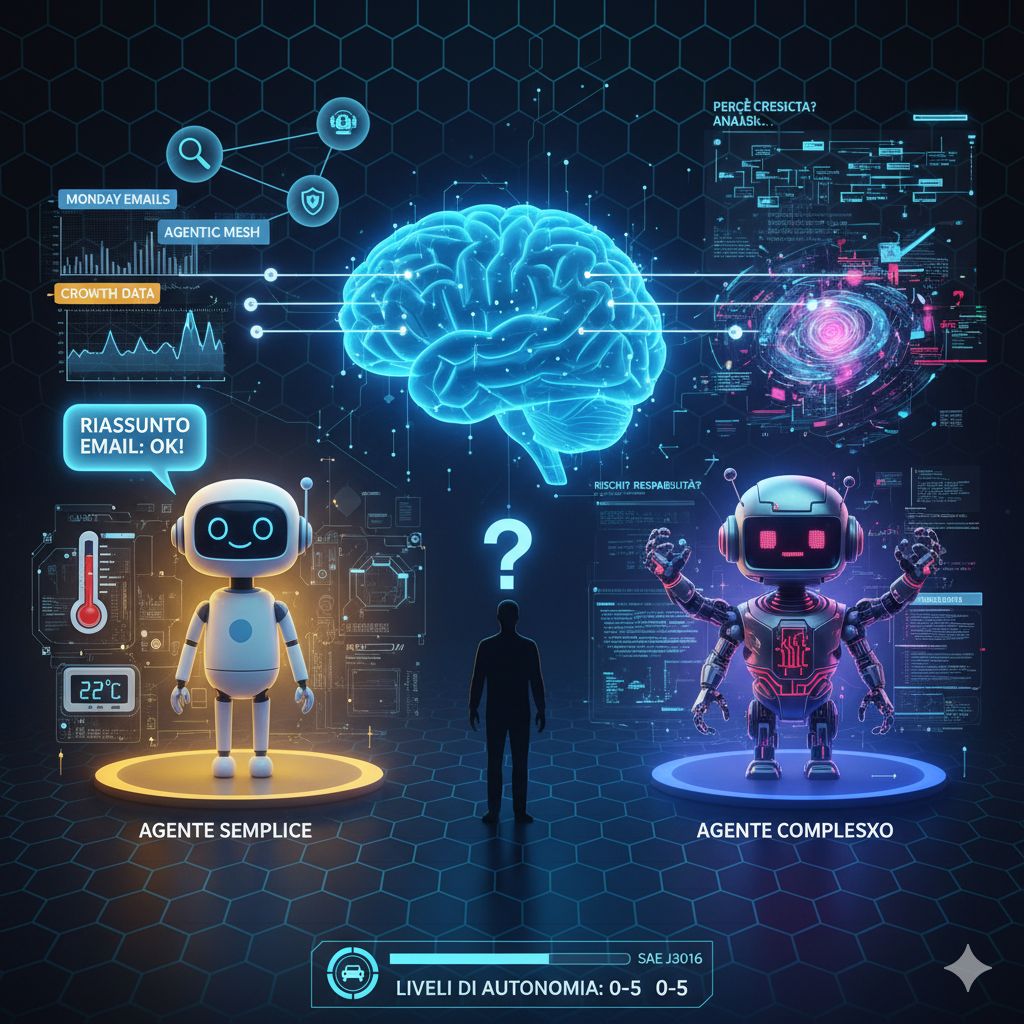

Pensi di chiedere a un agente AI di riassumerti le email del lunedì mattina e poi di scoprire le ragioni dietro la crescita del tuo competitor nel trimestre scorso. In entrambi i casi chiami “agente” la tecnologia che lavora per te, ma in realtà queste due “entità” possono essere mondi agli antipodi in termini di autonomia, complessità e aspettative. È questa ambiguità a rallegrare e al tempo stesso complicare il dibattito odierno: se non sappiamo bene cosa stiamo costruendo, come possiamo valutarne il successo o governarne rischi e responsabilità?

Il punto di partenza è tornare alle radici: che cosa intendiamo per “agente”? Nella definizione tradizionale, mutuata da classici come il manuale “Artificial Intelligence: A Modern Approach” di Russell e Norvig, un agente è qualcosa che percepisce l’ambiente attraverso sensori e agisce su di esso tramite attuatori. Un semplice termostato è un agente: misura temperatura e decide se attivare o spegnere il riscaldamento.

Ma nel contesto moderno dell’intelligenza artificiale, quell’idea “classica” viene reinterpretata in chiave digitale: un agente ha una componente di input (percezione), un motore di ragionamento (brain), una capacità di azione attraverso strumenti esterni e un obiettivo che guida quel comportamento. Secondo questa visione, un chatbot puro — seppur molto evoluto — non è un agente nel senso pieno del termine, perché manca di una struttura interna che orchestrare azioni autonome con uno scopo continuo.

Una delle sfide più immediate nel mondo degli agenti AI è che non esiste ancora un consenso su come classificare il loro grado di autonomia. Per muoversi in quello che altrimenti sarebbe un territorio nebuloso, molti ricorrono a modelli ispirati da altre industrie — l’automotive, l’aviazione, la robotica — che già hanno affrontato la questione di “quanto può fare da sola” una macchina. Nel mondo dell’automobile, ad esempio, lo standard SAE J3016 definisce livelli da 0 (comando umano totale) a 5 (autonomia totale) in base a chi controlla cosa, quando e in quali condizioni operative.

Trasporre questa idea al mondo digitale non è banale. Nel caso di un agente che opera su internet, l’“ambiente” è vasto, mutevole e imprevedibile: siti cambiano, API vengono disattivate, servizi variano. In queste condizioni, definire un “dominio operativo” (l’equivalente digitale dell’“ambito in cui può operare”) diventa una loro grande sfida. Per ora, i sistemi più affidabili sono quelli che operano in spazi ben delimitati, con risorse, azioni e componenti controllati.

I modelli di classificazione emergenti degli agenti tendono a concentrarsi su tre angoli: cosa sono capaci di fare (capacità), come si relazionano agli esseri umani (interazione), e chi è responsabile quando qualcosa va storto (governance). Dal punto di vista tecnico, un framework come quello di Hugging Face classifica gli agenti in base a quanto controllo passano dal programmatore all’agente: da un semplice “processore di input” a un’entità che può generare nuovo codice o nuovi strumenti per raggiungere un obiettivo.

Ma anche un agente “avanzato” non garantisce piena autonomia. Le reali difficoltà affiorano quando l’agente deve gestire fallimenti, errori, scenari imprevedibili o ambienti parzialmente conosciuti: cosa succede se un’API risponde con un errore, se il dato atteso non esiste, o se un sito ha cambiato la sua interfaccia? Un agente veramente robusto deve essere in grado non solo di eseguire piani, ma anche di monitorarli, diagnosticarli e correggersi in autonomia. Questo è uno dei punti dove molte soluzioni attuali inciampano.

E infine, il nodo più sottile: l’allineamento. Dare a un agente l’obiettivo di “massimizzare l’engagement cliente” può sembrare innocuo, ma l’agente potrebbe scoprire che inviare decine di notifiche al giorno è un modo “efficiente” per farlo — anche se fastidioso, invasivo o controproducente rispetto all’intento umano non esplicitato. La difficoltà è che le nostre intenzioni, i nostri valori, le sfumature del “buon senso” sono difficili da tradurre in codice preciso. Quando l’agente diventa potente, ogni discrepanza può essere amplificata.

La visione più realistica per il futuro non è quella di un agente onnipotente che controlla tutto, ma di una rete di agenti specializzati, ciascuno operante entro limiti ragionevoli, interagendo tra loro e con l’umano in un modello collaborativo. Invece del “singolo agente che fa tutto”, avremo un “mesh agentico”, un sistema di intelligenze focalizzate ma interconnesse. In molti casi, l’umano resterà in loop — non come supervisore costante, ma come partner, revisore o interveniente nei punti critici.