I modelli di intelligenza artificiale possono sembrare misteriosi perché producono risposte senza chiarire il “ragionamento” dietro di esse. Questo accade perché il loro funzionamento è radicalmente diverso dal nostro: elaborano grandi reti di neuroni collegati a vari concetti, rendendo difficile comprendere il loro processo di pensiero.

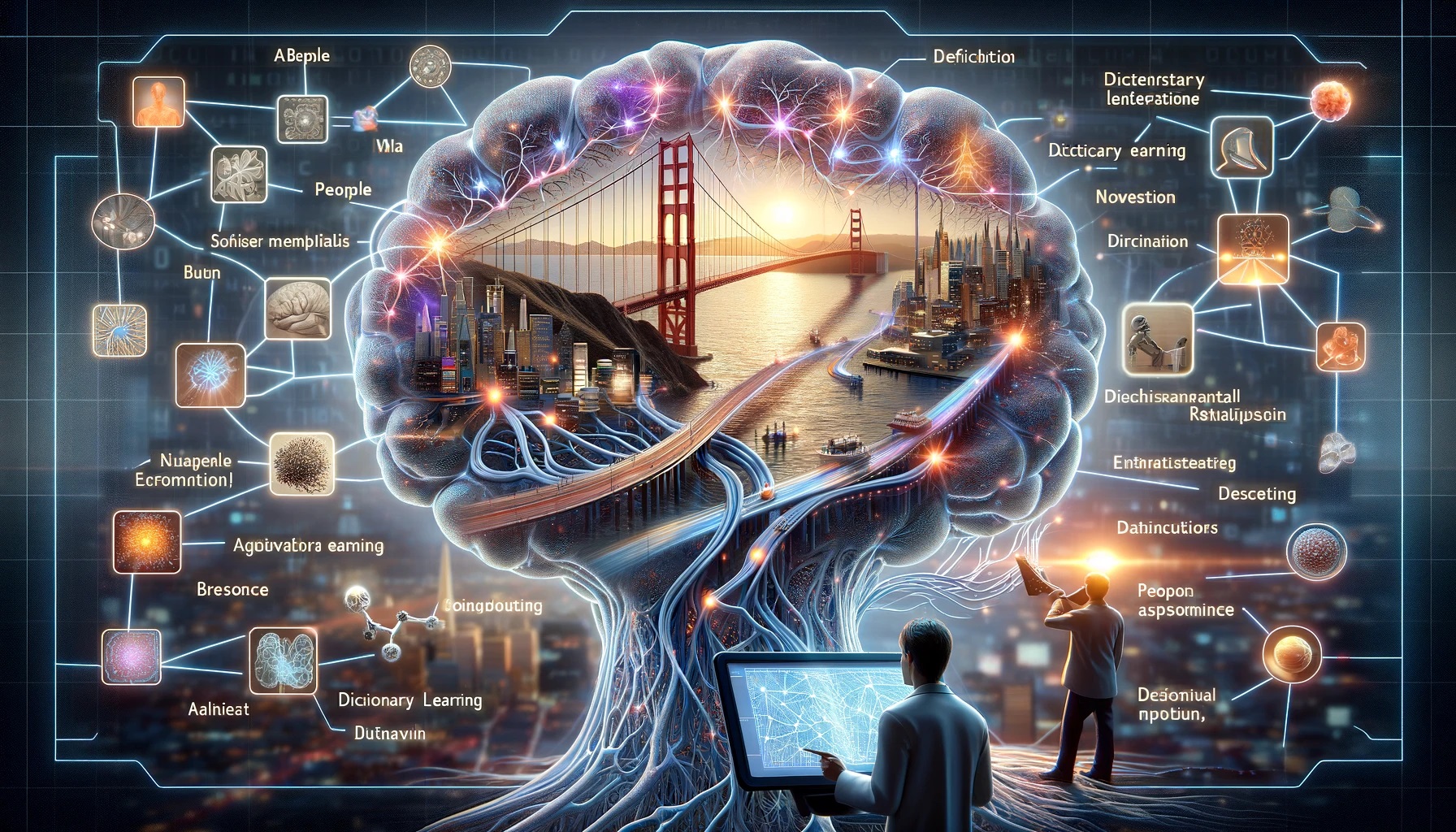

Tuttavia, per la prima volta, i ricercatori sono riusciti a scrutare il funzionamento interno di un’intelligenza artificiale. Il team di Anthropic ha svelato come utilizza una tecnica chiamata “apprendimento del dizionario” sul modello Claude Sonnet. Questo metodo consente di individuare i percorsi nel “cervello” del modello attivati da differenti argomenti, da persone e luoghi a concetti scientifici e astratti.

Interessante è il fatto che questi percorsi possono essere manipolati manualmente, permettendo ai ricercatori di influenzare il comportamento del modello. Ad esempio, hanno potuto far sì che Claude enfatizzasse particolari caratteristiche, come nel caso del Golden Gate Bridge, e ottenere risposte specifiche.

Questo lavoro è un passo importante verso la comprensione e il controllo delle intelligenze artificiali. Sebbene sia solo l’inizio e sia ancora limitato rispetto alla vastità delle intelligenze artificiali attuali, potrebbe portarci più vicini a modelli sui quali possiamo fare affidamento.

Con il continuo avanzamento delle intelligenze artificiali, i loro processi mentali diventano sempre più complessi, ma c’è il rischio che rimangano “scatole nere” per gli esseri umani. Tuttavia, Anthropic ha contribuito a rendere più comprensibile il pensiero delle intelligenze artificiali attraverso l’apprendimento del dizionario, permettendo di isolare modelli di attivazione neuronale in diversi contesti.

Manipolare queste caratteristiche offre una sorta di “controllo mentale” sull’intelligenza artificiale. Ad esempio, hanno potuto far sì che Claude diventasse quasi ossessionato dal Golden Gate Bridge e persino scrivesse e-mail truffaldine.

Questi esperimenti, tuttavia, non aggiungono capacità pericolose ai modelli; piuttosto, mirano a renderli più sicuri. Le tecniche utilizzate potrebbero essere impiegate per monitorare e rimuovere comportamenti rischiosi, contribuendo a sviluppare modelli di intelligenza artificiale più sicuri e affidabili.