Negli ultimi anni l’idea che l’intelligenza artificiale potesse imitare certi aspetti del ragionamento umano non è più roba da fantascienza. Ma ciò che è accaduto recentemente alla finale mondiale del “International Collegiate Programming Contest” (ICPC) ha dato una scossa ancora più forte a chi pensava che esistessero limiti duri da superare per gli algoritmi.

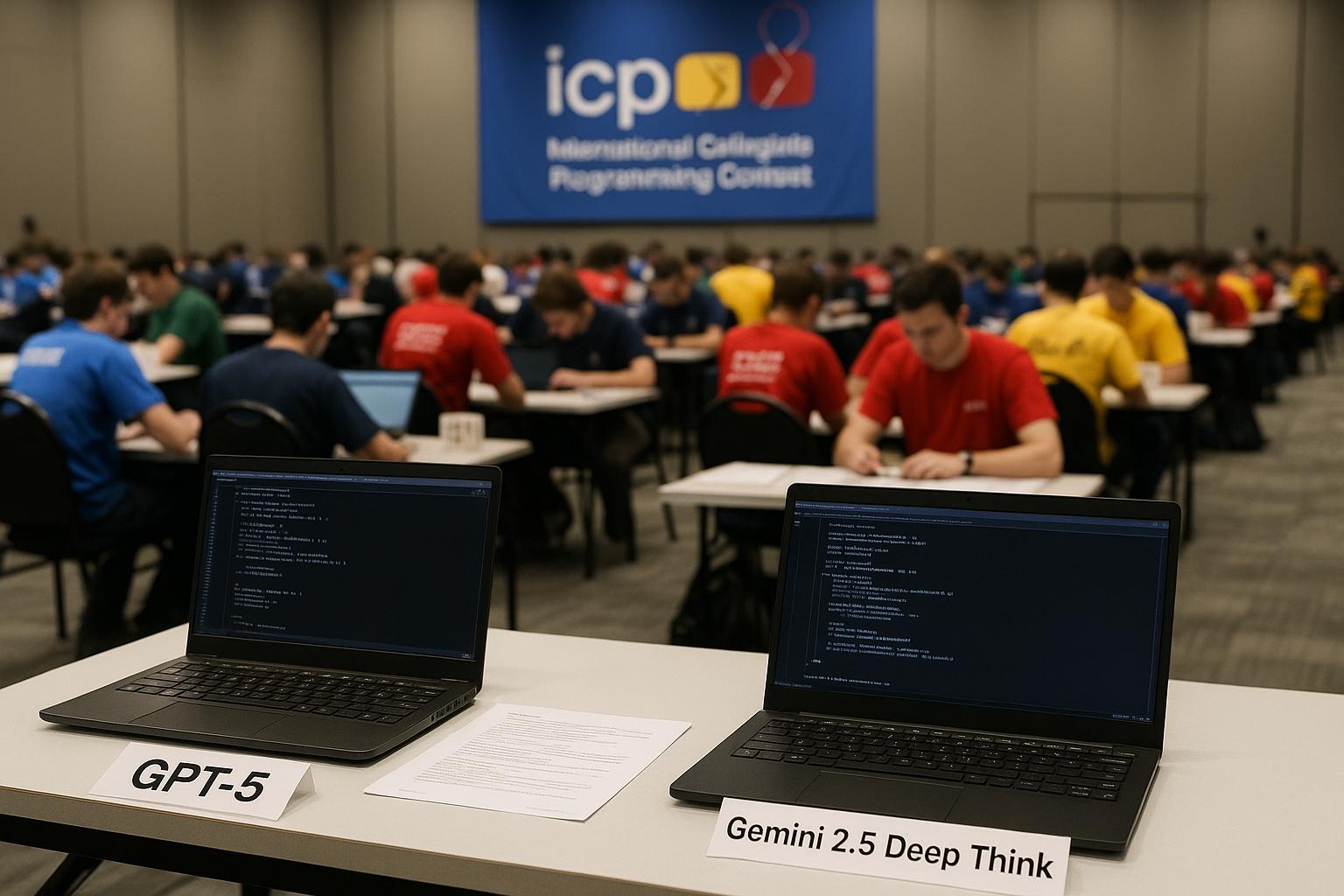

Al centro della scena ci sono i modelli più avanzati: GPT-5 di OpenAI e Gemini 2.5 Deep Think di Google DeepMind. Modelli che, fino a poco tempo fa, avremmo associato più a chatbot conversazionali, assistenti digitali o generatori di testo. E oggi, invece, dimostrano di saper risolvere problemi algorítmici estremamente complessi — alcuni dei quali sfuggiti anche ai migliori studenti universitari nelle stesse condizioni di gara.

L’ICPC è una competizione globale di programmazione universitaria. Squadre di atenei di tutto il mondo si sfidano su problemi algoritmici difficili che richiedono logica, inventiva, rapidità e precisione. Nel 2025 le squadre in finale provenivano da 139 università in almeno 103 paesi. Il tempo a disposizione per completare una serie di dodici problemi è di cinque ore: non solo serve trovare la soluzione, ma anche farlo abbastanza in fretta.

Ciò che rende la sfida significativa è che l’ICPC non è un set di domande “già risolte” nel senso facile: sono problemi dove la creatività, la capacità di ragionamento, di modellazione matematica, e la gestione delle prestazioni contano moltissimo. Ed è in questo contesto che gli strumenti di AI sono stati messi alla prova “sul campo”.

OpenAI ha fatto scendere in campo GPT-5 in uno “AI track” ufficiale dell’ICPC, con le stesse regole che valgono per i partecipanti umani: attacco simultaneo dei problemi, invio delle soluzioni allo stesso giudice locale del concorso, stesse condizioni, stesse risorse.

GPT-5 ha risolto tutti e dodici i problemi proposti (12/12). Nessun team umano è riuscito in questa impresa. Gemini 2.5 Deep Think non è rimasto molto indietro: ha risolto 10 dei 12 problemi, piazzandosi virtualmente al secondo posto grazie a una performance che è stata giudicata molto forte, sebbene non perfetta.

Un fatto particolarmente interessante è che Gemini ha risolto un problema che nessuna delle squadre umane è riuscita a completare. Si trattava di un problema riguardante la distribuzione di liquidi attraverso un sistema di condotti (“ducts”), con vincoli di flusso ottimale e condizionali che implicavano dinamica, programmazione, e qualche intuizione “astratta”. Google ha spiegato che il modello ha ragionato tramite una combinazione di approcci: assegnare valori di priorità alle riserve, poi applicare algoritmi di programmazione dinamica, poi esplorare lo spazio delle soluzioni attraverso ricerche ternarie nidificate (nested ternary searches), considerando proprietà convesse dello spazio.

Un’altra curiosità: GPT-5 non è stato addestrato specificamente per l’ICPC, nel senso che non gli è stato insegnato “come battere” quell’evento o quei tipi di problemi. Ciò suggerisce che la sua capacità deriva da addestramento generalista, su vasta scala, piuttosto che da tuning su quei casi specifici.

Questo tipo di risultato ha implicazioni che vanno ben al-di là del primato tecnologico. Innanzitutto, dimostra che i modelli fondazionali (foundation models), come GPT-5 o Gemini 2.5, non sono solo bravi a rispondere a domande di cultura generale o a generare testo fluentemente, ma possono affrontare problemi algoritmici nuovi, complessi — problemi che richiedono ragionamento profondo, astrazione matematica, intuizioni creative.

In secondo luogo, apre una riflessione su quali possano essere i limiti residui per l’uso imprenditoriale (enterprise) e industriale di questi modelli: se già a un livello così “puro” di competizione, in un ambiente controllato, riescono a competere con (e sovente superare) esseri umani molto preparati, allora molte applicazioni che pensavamo lontane o rischiose diventano più realistiche.

In terzo luogo, si torna a parlare di cosa significhi intelligenza artificiale di “livello generale” (Artificial General Intelligence, AGI). Non che questo sia AGI, ma il fatto che modelli così recenti possano svolgere compiti che sembravano prerogativa esclusiva degli umani — ragionare su problemi nuovi, adattarsi, essere creativi — è un segnale che il divario si sta restringendo.

Ci sono molti aspetti che restano da esplorare e domande che ancora pesano. Per esempio, che cosa succede quando i problemi non sono ben definiti, quando i vincoli cambiano continuamente, quando la “domanda” non è del tipo algoritmico puro ma richiede comprensione umana del contesto, intuizione soggettiva, giudizi morali, valori sociali? In questi casi, i modelli possono ancora trovarsi in difficoltà.

C’è poi la questione delle risorse: modelli come GPT-5 o Gemini 2.5 sono costosi da addestrare, richiedono enormi quantità di dati e potenza computazionale. Anche se i risultati impressionano, non è detto che tutti possano permettersi di utilizzare versioni “full scale” per applicazioni pratiche.

Inoltre, la velocità non è sempre tutto: risolvere un problema è una cosa, farlo efficacemente in contesti reali – con interfacce utente, controlli di sicurezza, limiti di tempo, costi, disponibilità di dati puliti, e con richieste di interpretabilità — è un’altra cosa.

Infine, c’è il tema etico e sociale: se macchine e algoritmi iniziano a risolvere problemi complessi che prima erano campo esclusivo degli umani, come cambierà il valore del lavoro umano, come evolveranno le competenze richieste, come garantire che queste tecnologie siano usate bene, con responsabilità, trasparenza e giustizia?

Se i modelli già oggi possono “andare forte” in competizioni di alto livello come l’ICPC, cosa ci attende domani? Immagino un mondo in cui alcune aziende usano modelli AI per progettare nuovi algoritmi, ottimizzare processi molto complessi, fare ricerca matematica avanzata, generare soluzioni in campi “hard” come la fisica computazionale, la logistica, le simulazioni, ma anche scienze applicate dove l’innovazione richiede combinazioni creative di conoscenze.

Allo stesso tempo diventa probabile che cresca la domanda per modelli che non solo siano potenti, ma interpretabili, sicuri, verificabili: cioè che chi li usa — persone o organizzazioni — possa capire perché un modello ha scelto una certa soluzione, possa controllarne il funzionamento, intervenire se sbaglia, e assicurarsi che non emerga bias o errore inaspettato.