Le reti neurali hanno rivoluzionato l’intelligenza artificiale, applicandosi a compiti complessi come l’elaborazione del linguaggio naturale, la visione artificiale, il gameplay strategico, l’assistenza sanitaria, e persino la guida autonoma. Tuttavia, l’espansione e la complessità di questi modelli comportano sfide significative: elevati requisiti di dati e potenza di calcolo li rendono costosi e sollevano preoccupazioni sulla sostenibilità. Inoltre, la loro natura “black-box” limita la loro interpretabilità, un aspetto cruciale per l’adozione in settori sensibili. Le Reti Kolmogorov-Arnold (KAN) emergono come un’alternativa promettente, offrendo una soluzione più efficiente e interpretabile per l’IA.

I perceptron multistrato (MLP) sono fondamentali per molti modelli di intelligenza artificiale. Queste reti neurali consistono in più strati di nodi o “neuroni”, dove ogni nodo di uno strato è collegato a ogni nodo dello strato successivo. Tipicamente, un MLP include uno strato di input, uno o più strati nascosti, e uno strato di output. I nodi applicano una funzione di attivazione ai segnali in arrivo, consentendo alla rete di apprendere e adattarsi durante l’addestramento.

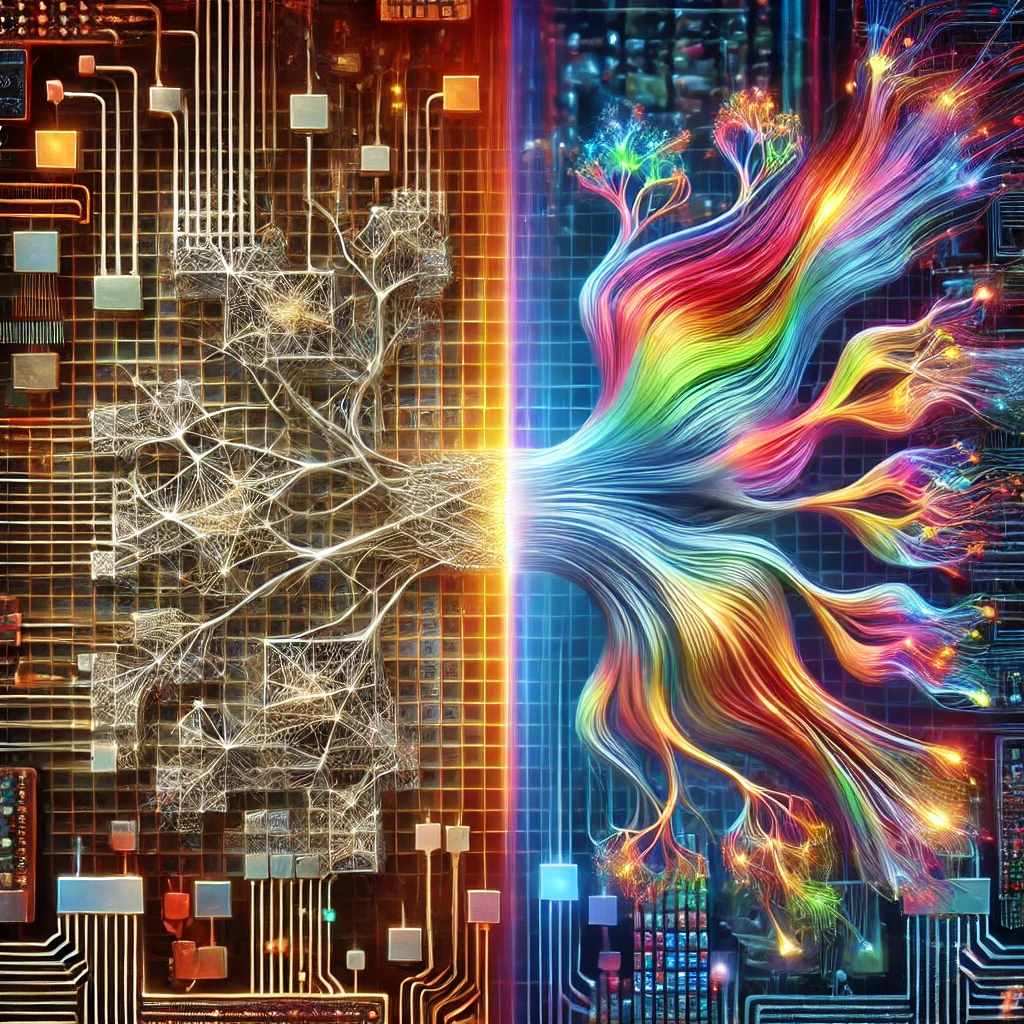

Le reti Kolmogorov-Arnold (KAN) rappresentano un’evoluzione significativa nel design delle reti neurali. Ispirate dal teorema di rappresentazione di Kolmogorov-Arnold, queste reti utilizzano funzioni regolabili sulle connessioni tra i nodi, anziché funzioni di attivazione fisse. Invece di apprendere solo i pesi delle connessioni, le KAN apprendono l’intera funzione che mappa l’input all’output. Questo approccio consente loro di applicare la non linearità ai segnali prima di sommarli, rendendole più flessibili ed efficienti rispetto agli MLP.

Gli MLP utilizzano un approccio fisso per trasformare i segnali in output, il che può richiedere una rete più grande per gestire la complessità dei dati. Immagina di risolvere un puzzle con pezzi rigidi che non si adattano perfettamente: è necessario aggiungere più pezzi per completare l’immagine.

Le KAN, invece, si adattano meglio ai dati grazie alle loro funzioni regolabili, che possono cambiare in base alla natura specifica dei dati. Usando pezzi di puzzle che possono cambiare forma, le KAN possono risolvere problemi complessi con reti più piccole e meno parametri, risultando più efficienti. Ad esempio, una KAN a 2 strati di larghezza 10 può superare in accuratezza ed efficienza una MLP a 4 strati di larghezza 100.

Gli MLP tendono a creare relazioni complesse tra i segnali, rendendo difficile comprendere come vengono prese le decisioni. Le KAN, al contrario, semplificano l’integrazione dei segnali, rendendo più facile visualizzare come questi contribuiscono all’output finale. Questo approccio trasparente permette ai ricercatori di semplificare il modello e comprendere meglio il comportamento complessivo della rete.

Le KAN hanno il potenziale di rivelare meccanismi nascosti in diverse aree scientifiche, grazie alla loro interpretabilità e capacità di modellare relazioni complesse. Alcuni casi d’uso includono:

- Fisica: Scoprire e modellare leggi fisiche fondamentali.

- Biologia e Genomica: Analizzare le relazioni tra geni, proteine e funzioni biologiche.

- Scienza del Clima: Migliorare l’accuratezza dei modelli climatici.

- Chimica e Scoperta di Farmaci: Modellare reazioni chimiche e prevedere le proprietà di nuovi composti.

- Astrofisica: Simulare fenomeni complessi come la formazione di galassie e buchi neri.

- Economia e Scienze Sociali: Modellare sistemi complessi come mercati finanziari e social network.

Nonostante il loro potenziale, le KAN affrontano alcune sfide. La loro flessibilità può complicare il processo di progettazione e formazione, richiedendo più risorse e tempi di formazione più lunghi. Inoltre, le KAN non sono ancora ottimizzate per l’uso su GPU, e non esistono strumenti standardizzati per il loro utilizzo, il che può limitarne l’adozione. Questi problemi evidenziano la necessità di ulteriori ricerche e sviluppi per superare gli ostacoli pratici e sfruttare appieno i benefici delle KAN.