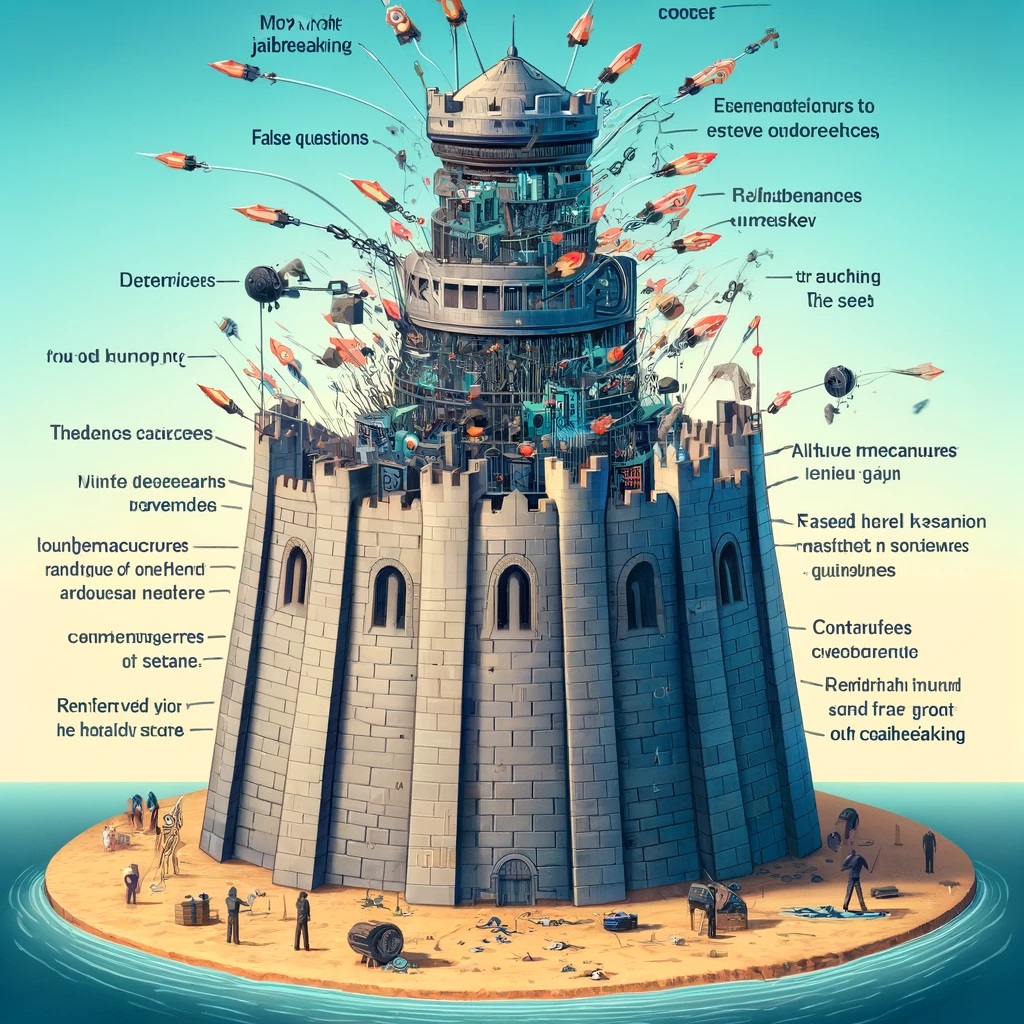

Recentemente, i ricercatori di Anthropic hanno pubblicato un articolo su “Many-shot Jailbreaking”, una nuova tecnica per eseguire il jailbreak che supera i limiti di sicurezza dei modelli di linguaggio naturale (LLM).

Questo nuovo metodo di jailbreaking, chiamato jailbreak multi-shot, sfrutta la lunga finestra di contesto dei più recenti LLM e apprende solo dalle informazioni fornite nel prompt. In sostanza, aggiunge diverse domande false in un unico messaggio per abbassare gradualmente le difese di sicurezza del modello.

Il problema è che, se il numero di domande false è troppo basso, il modello potrebbe rifiutare di rispondere. Tuttavia, se le domande false sono troppe, il modello potrebbe ignorare le difese di sicurezza e fornire risposte dannose.

I ricercatori hanno testato questa tecnica utilizzando Claude 2 e hanno scoperto che, aumentando il numero di domande false, il modello era molto più incline a fornire risposte dannose.

Per prevenire questi jailbreak, Anthropic ha preso misure, come limitare la lunghezza della finestra di contesto o modificare i prompt prima di inviarli al modello. Ciò ha ridotto significativamente il successo degli attacchi, portando da un tasso di successo del 61% al 2%.

Questo studio mette in luce la necessità per gli sviluppatori di LLM di considerare attentamente i rischi di sicurezza e di adottare misure preventive per proteggere i propri modelli da potenziali exploit.