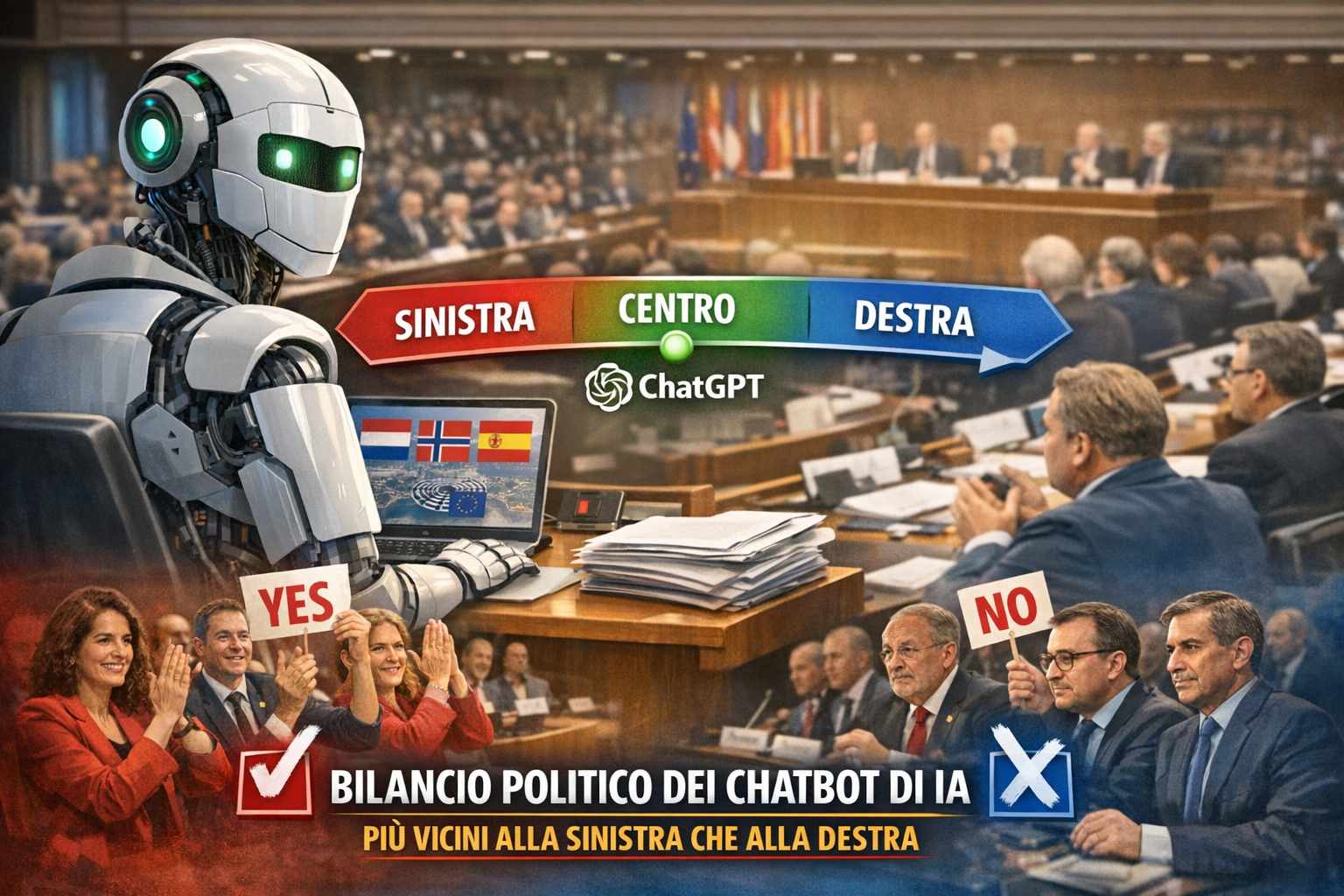

Nel dibattito pubblico sull’intelligenza artificiale, un tema sempre più centrale riguarda i pregiudizi e gli orientamenti impliciti che i modelli linguistici possono mostrare quando affrontano questioni politiche complesse. Un recente studio ha esplorato proprio questa dinamica, analizzando come chatbot basati su grandi modelli linguistici – come ChatGPT – votano quando vengono messi di fronte a proposte di legge reali adottate nei parlamenti di tre paesi europei. I risultati di questa ricerca, che utilizzano dati concreti di voti legislativi piuttosto che test sintetici, rivelano comportamenti che sembrano tendere verso posizioni progressiste e di centro-sinistra, mentre mostrano un allineamento più debole con posizioni conservatrici e di destra.

L’idea alla base dello studio nasce dalla volontà di capire non solo se i modelli di IA rispondono a stimoli politici, ma in che modo quei riscontri si confrontano con le decisioni prese da parlamentari reali. Gli studiosi hanno quindi selezionato migliaia di mozioni legislative già votate nei parlamenti dei Paesi Bassi, della Norvegia e della Spagna, riproponendole ai modelli linguistici. Ad ogni proposta, il sistema doveva esprimere un sì o un no, simulando così un voto parlamentare. Le risposte ottenute sono poi state confrontate con i risultati storici delle votazioni umane, proiettandole su una scala ideologica standard utilizzata dagli scienziati politici per collocare i partiti su un asse che va dalla sinistra alla destra.

Quello che è emerso da questo approccio è una tendenza piuttosto chiara: i sistemi di IA si collocano in modo consistente più vicino ai partiti di sinistra e di centro-sinistra che non a quelli conservatori. Questo non significa che un chatbot “voti” nel senso umano del termine, ma che, quando gli viene chiesto di giudicare l’approvazione o il rifiuto di una legge reale, le sue risposte sono statisticamente più vicine alle decisioni prese da forze politiche progressiste o moderate piuttosto che da gruppi tradizionalmente sulla destra dello spettro politico. La coerenza di questo orientamento, osservata in tre contesti nazionali differenti, suggerisce che il fenomeno non sia un semplice artefatto casuale ma un pattern da approfondire.

Per comprendere appieno l’importanza di questi risultati è utile considerare come i modelli linguistici vengano addestrati e come operino: essi apprendono dai dati di testo su cui sono stati istruiti, che riflettono inevitabilmente i pregiudizi, le priorità e le prospettive di fonti umane. Questo può tradursi in risposte che, pur non avendo un’intenzione politica autonoma, finiscono per rispecchiare un orientamento implicito nei confronti di determinati concetti, linguaggi e valori culturali. Negli anni, varie ricerche nel campo dei bias nei modelli di intelligenza artificiale hanno già evidenziato come i sistemi tendano a riprodurre pregiudizi sociali e culturali presenti nei dati di addestramento, compresi quelli legati a genere, razza o visione del mondo. Quando questi pregiudizi si estendono a contesti politici, il risultato può essere percepito come un “orientamento” verso determinate posizioni.

Il valore di uno studio che utilizza voti parlamentari reali, anziché test artificiali o quesiti ad hoc, risiede proprio nella sua capacità di mettere i modelli di IA di fronte a decisioni che sono state prese con un ampio contesto sociale, storico e politico alle spalle. Leggi reali riflettono compromessi complessi, negoziazioni e priorità che vanno ben oltre la semplice formulazione di frasi neutre; pertanto, osservare come un modello risponde a queste leggi può offrire un ritratto più sfumato di come esso “interpreta” valori e contenuti.

Nel contesto più ampio delle discussioni sull’etica e sull’affidabilità dell’IA, i risultati di questa ricerca sollevano questioni rilevanti: come dobbiamo considerare modelli che sembrano orientarsi verso una parte dello spettro politico? Che responsabilità hanno gli sviluppatori nel mitigare tali tendenze? E come possono gli utenti interpretare le risposte dei chatbot quando affrontano argomenti che incidono sulle loro convinzioni e decisioni civiche? Queste domande non trovano risposte univoche, ma evidenziano quanto sia importante comprendere i limiti e le inclinazioni dei sistemi di IA prima di integrarli in processi decisionali o informazioni politiche di rilievo pubblico.