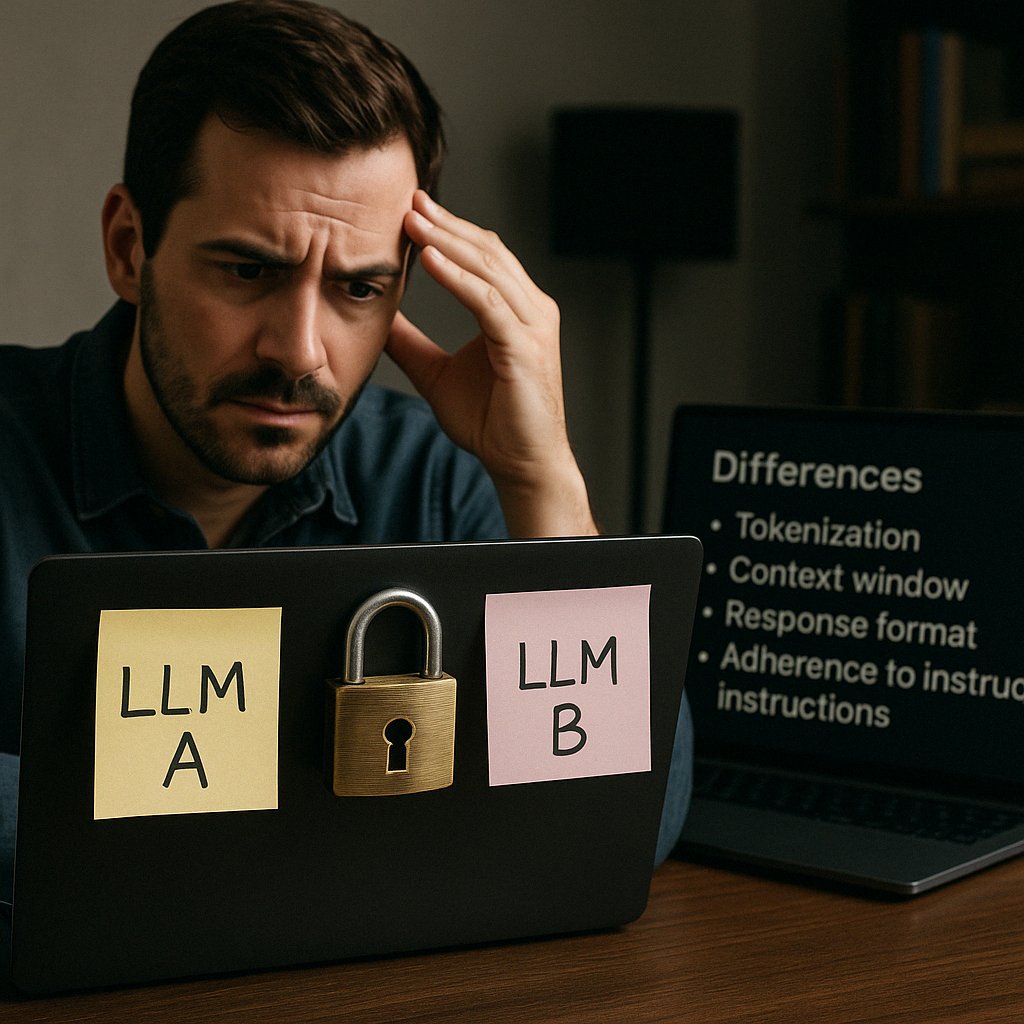

Nel mondo dell’intelligenza artificiale, si è diffusa la convinzione che passare da un modello linguistico di grandi dimensioni (LLM) a un altro sia un’operazione semplice, simile a un cambio di chiave API. Tuttavia, come sottolineato da Lavanya Gupta in un’analisi pubblicata su VentureBeat, questa transizione nasconde complessità significative che vanno ben oltre la mera sostituzione tecnica. Le differenze tra i modelli, infatti, possono influire profondamente su costi, prestazioni e qualità dei risultati ottenuti.

Ogni famiglia di modelli LLM, come GPT-4o di OpenAI, Claude di Anthropic o Gemini di Google, presenta caratteristiche uniche che ne determinano il comportamento e le prestazioni. Queste differenze non sono solo tecniche, ma anche strutturali e funzionali, e includono:

- Tokenizzazione: Ogni modello ha una propria strategia per suddividere il testo in token. Ad esempio, il modello Sonnet 3.5 di Anthropic tende a suddividere lo stesso testo in un numero maggiore di token rispetto a GPT-4o di OpenAI, influenzando così la lunghezza dell’input e i costi associati.

- Finestra contestuale: La capacità di un modello di gestire il contesto varia. Mentre molti modelli di punta supportano finestre contestuali fino a 128.000 token, Gemini di Google offre finestre fino a 1 o 2 milioni di token. Tuttavia, l’efficacia di questi modelli può diminuire con l’aumento della lunghezza del contesto.

- Struttura delle risposte: Alcuni modelli, come GPT-4o, tendono a generare risposte strutturate in formato JSON, mentre altri, come Claude, preferiscono risposte in formato XML o markdown. Queste differenze richiedono adattamenti nei processi di post-elaborazione delle risposte.

- Adesione alle istruzioni: I modelli basati su ragionamento, come GPT-4o, rispondono meglio a istruzioni semplici, mentre i modelli in stile chat, come Claude, richiedono istruzioni più chiare e strutturate.

Le aziende che decidono di migrare tra modelli LLM devono affrontare una serie di sfide pratiche. Non si tratta solo di cambiare un’API, ma di adattare l’intero flusso di lavoro e le aspettative. Le modifiche nei costi per token, nelle prestazioni con contesti lunghi e nella qualità delle risposte possono influire significativamente sull’efficacia delle applicazioni basate su IA.

Per affrontare queste sfide, molte aziende si stanno rivolgendo a piattaforme come Google Vertex AI, Microsoft Azure AI Studio e AWS Bedrock, che offrono strumenti per l’orchestrazione dei modelli e la gestione dei prompt. Questi strumenti aiutano a semplificare la migrazione, ma non eliminano completamente la necessità di adattamenti specifici per ciascun modello.

La migrazione tra modelli LLM non è un’operazione plug-and-play. Le differenze tra i modelli richiedono un’attenta pianificazione e adattamento. Le aziende devono essere consapevoli delle implicazioni tecniche e pratiche di questa transizione per garantire che l’adozione di un nuovo modello migliori effettivamente le loro applicazioni e non introduca regressioni o inefficienze.