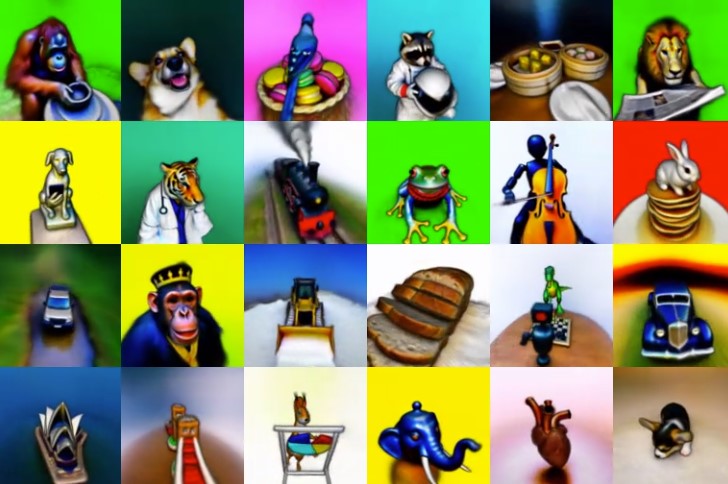

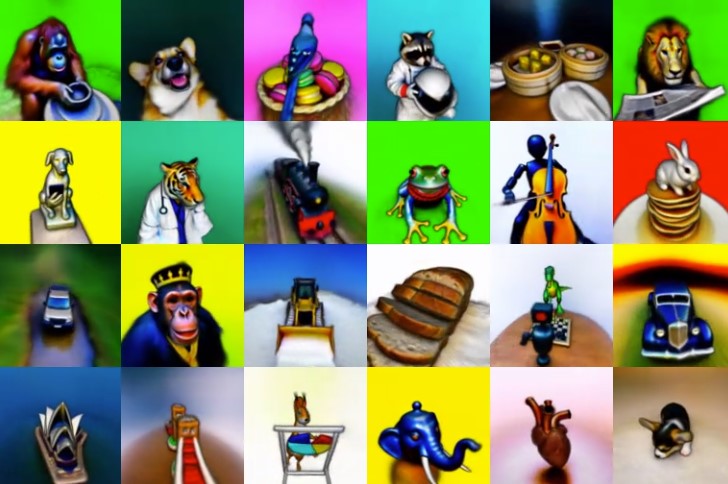

Gli utenti possono ora generare modelli da testo a 3D utilizzando la diffusione 2D

Il nuovo metodo chiamato “DreamFusion” utilizza la diffusione 2D per generare diversi modelli 3D, portando progressi nella sintesi da testo a immagine.

Un gruppo di ricercatori di Google ha adattato un nuovo approccio alla sintesi 3D. Gli utenti possono ora generare modelli 3D con prompt di testo come input. Il nuovo metodo, chiamato “DreamFusion” , utilizza la diffusione 2D ed è impostato per apportare notevoli progressi alla sintesi da testo a immagine.

In genere, i progressi nei sistemi generativi dell’IA sono guidati da modelli di diffusione addestrati su miliardi di coppie immagine-testo. I ricercatori affermano che un tale adattamento della sintesi del modello 3D richiederebbe set di dati su larga scala di risorse 3D etichettate e architetture efficienti per eliminare il rumore dei dati 3D, nessuno dei quali attualmente esiste. Invece, il team ha aggirato tali limitazioni per utilizzare un modello di diffusione da testo a immagine 2D pre-addestrato che esegue la sintesi da testo a 3D .

I ricercatori hanno ottimizzato un modello 3D inizializzato in modo casuale chiamato ” NeRF” (un campo di radianza neurale) tramite la discesa del gradiente in modo che i rendering in 2D da angoli casuali ottengano una perdita minore.

Un estratto dal blog dice : “Il modello 3D risultante del testo dato può essere visto da qualsiasi angolazione, illuminato da un’illuminazione arbitraria o composto in qualsiasi ambiente 3D. Il nostro approccio non richiede dati di addestramento 3D e nessuna modifica al modello di diffusione dell’immagine, dimostrando l’efficacia dei modelli di diffusione dell’immagine pre-addestrati come precedenti”.

Come funziona?

Un modello generativo da testo a immagine chiamato “Imagen” viene utilizzato per ottimizzare una scena 3D. La ricerca propone anche lo Score Distillation Sampling (SDS) , un modo per generare campioni da un modello di diffusione ottimizzando una funzione di perdita, consentendo agli utenti di ottimizzare i campioni in uno spazio di parametri arbitrari (3D).

Una parametrizzazione della scena 3D , simile a Neural Radiance Fields o NeRF , viene utilizzata per definire la mappatura differenziabile. Mentre SDS produce un aspetto della scena ragionevole, DreamFusion instilla regolatori aggiuntivi e strategie di ottimizzazione per migliorare la geometria. I NeRF addestrati risultanti sono coerenti, con geometria della superficie e normali di alta qualità.